Web Scraper Service - Datenextraktion leicht gemacht im Jahr 2022

WebscrapingAPI am 04. November 2022

Die Praxis des Einsatzes von Bots zum Sammeln von Informationen und Material von einer Website ist als Web Scraping bekannt. Ein Web Scraper-Dienstleister sammelt den grundlegenden HTML-Code und die Daten, die auf einem Server gespeichert sind, im Gegensatz zum Screen Scraping, bei dem die auf dem Bildschirm sichtbaren Pixel erfasst werden. Danach kann der Scraper den gesamten Inhalt einer Website an anderer Stelle duplizieren.

Viele Digitalfirmen, die auf Datenerfassung angewiesen sind, nutzen Web Scraping. Unternehmen, die Marktforschung betreiben, verwenden Scraper, um Informationen aus sozialen Medien und Foren zu erhalten. Eine Website wird von Web-Suchalgorithmen gecrawlt, die dann ihre Daten untersuchen und ihr eine Bewertung zuweisen.

Preisvergleichs-Websites verwenden Bots, um Produktpreise und -details von den Websites der angeschlossenen Verkäufer zu erhalten. Web Scraping wird darüber hinaus für Aktivitäten wie Preisabsprachen und Diebstahl von Inhalten eingesetzt. Eine Website, die von Scraping betroffen ist, kann erhebliche finanzielle Verluste erleiden, insbesondere wenn es sich um ein Unternehmen handelt, das auf wettbewerbsfähige Preismethoden angewiesen ist oder Inhalte verbreitet.

Der groß angelegte Diebstahl von Material von einer bestimmten Website wird als Content Scraping bezeichnet. Online-Produktverzeichnisse und Websites, die auf digitales Material angewiesen sind, um Besucher zu generieren, sind häufige Ziele. Ein Content-Scraping-Angriff kann für diese Unternehmen fatal sein.

Die Erstellung des Materials für ihre Datenbank erfordert beispielsweise Zeit, Kosten und Aufwand für virtuelle lokale Branchenverzeichnisse. Scraping kann dazu führen, dass das gesamte Material der Öffentlichkeit zugänglich gemacht, für Spamming-Versuche verwendet oder an konkurrierende Unternehmen verkauft wird.

Wichtige Faktoren, die bei der Auswahl einer Web-Scraping-Strategie zu berücksichtigen sind

Sie kennen nun die Standardmethoden für die Durchführung von Web Scraping. Die Aufstellung eines Plans wäre der nächste Schritt. Bevor Sie sich für eine Web-Scraping-Strategie entscheiden, müssen Sie einige Aspekte berücksichtigen, die sich auf Ihre Kosten und die Qualität der gewonnenen Daten auswirken können.

- Die Qualität der Daten, die ausgewertet wurden

Bevor Sie einen Dienst in Anspruch nehmen, müssen Sie sich über Ihre Anforderungen im Klaren sein. Sie sollten die Qualität der Daten, den Umfang und die Korrektheit der Daten sowie die Häufigkeit und den Umfang des Scrapings von Websites berücksichtigen. Sie müssen sich vergewissern, dass die gewählte Scraping-Methode ohne den Verlust wichtiger Daten auskommt. Für die Datenanalyse müssen die Daten eventuell bereinigt werden.

- Das Auftreten von Kratzern

Wenn Sie beabsichtigen, häufig viele Daten zu scrapen, kann es passieren, dass die Website, von der Sie Daten extrahieren, Ihnen das Scrapen nicht mehr erlaubt. In solchen Fällen sollten Sie sicherstellen, dass Ihre Web-Scraping-Mitarbeiter über das nötige Fachwissen verfügen, um mit Anti-Scraping-Problemen umzugehen, oder dass Ihre Web-Scraping-Technologie eine IP-Rotation beinhaltet, um zu verhindern, dass sie blockiert wird.

Für die interne Sammlung und die Cloud-Extraktion bietet WebScrapingAPI automatische IP-Rotation (Sie können benutzerdefinierte Proxys manuell hinzufügen). Im Gegensatz zu anderen Online-Scraping-Lösungen erhebt WebScrapingAPI keine zusätzlichen Gebühren für die Möglichkeit, benutzerdefinierte IPs hinzuzufügen.

Weitere Informationen zur IP-Rotation finden Sie hier.

- Von wie vielen Websites möchten Sie Daten sammeln?

Bei der Auswahl einer Scraping-Technik sollte auch die Anzahl der Websites, die Sie scrapen möchten, berücksichtigt werden. Angesichts der Anzahl der Websites kann die Handhabung von Scraping-Crawlern mühsam sein. Viele Unternehmen nehmen einen Web-Scraping-Dienst in Anspruch, um sich nicht mit dem ganzen Aufwand befassen zu müssen.

Verwenden Sie eine Web-Scraping-Lösung, die eine breite Palette von Websites verarbeiten, alle Crawler gleichzeitig steuern und mit verschiedenen Systemen interagieren kann, die die Datenübertragung erleichtern, wenn Sie sich entscheiden, es selbst zu tun. Alternativ können Sie auch mit einer Gruppe oder einem Freiberufler zusammenarbeiten, um den gesamten Prozess zu verwalten und Aufwand zu sparen.

Kriterien für die Auswahl eines Web Scraper-Dienstes

Anbieter von Web-Scraping-Diensten bieten Unternehmen Datenerfassungs- und -exportdienste an. Datenextraktion ist das Extrahieren von Informationen aus einer Website oder anderen Quellen, wie Online-Anwendungen, Texten und anderen, mit Hilfe von Web-Scraping-Diensten, auch bekannt als Web Scraping.

Web-Scraping-Technologien replizieren Data Scraping, indem sie spezifische Informationen vom Herausgeber sammeln. Mit Datenextraktionsdiensten können Unternehmen ihre Erfassungsanforderungen an Spezialisten und Techniker auslagern, die Webseiten, Datensätze, Dateien, Fotos und Dateien präzise filtern.

Die Kunden können ihre Anfragen und Informationsquellen an diese Web-Scraper-Dienstleister übermitteln, die das gesamte Extraktionsverfahren in ihrem Namen durchführen.

Unternehmen können Web Scraper-Dienstleister nutzen, um Leads zu generieren, hilfreiche Informationen von Websites von Wettbewerbern zu erhalten, Erkenntnisse aus großen Datensätzen zu gewinnen und die Analyse ansonsten unstrukturierter Daten zu verbessern. Diese Dienste können Datenextraktionssoftware verwenden, um den Extraktionsprozess zu unterstützen.

Ein Anbieter von Web Scraper-Diensten muss die folgenden Kriterien erfüllen, um in die Kategorie der Datenextraktionsdienste aufgenommen zu werden:

- Stellen Sie einen Stab von Datenextraktionsprofis zur Verfügung.

- Sie müssen in der Lage sein, Informationen aus verschiedenen Quellen zu sammeln.

- Liefern Sie extrahierte Daten in einer Vielzahl von lesbaren Formaten an Ihre Kunden.

Die 6 besten Web Scraper-Dienstleister

Um an die benötigten Daten zu gelangen, müssen Sie Stunden mit der Einrichtung verbringen, manuell hosten, befürchten, blockiert zu werden (obwohl dies kein Problem ist, wenn Sie einen IP-Rotations-Proxy verwenden) usw. Stattdessen können Sie einen Web-Scraper-Dienst beauftragen, der den Anbieter von allen Problemen entlastet, so dass Sie sich auf das Sammeln von Daten für Ihr Unternehmen konzentrieren können.

Im Folgenden finden Sie einige der beliebtesten Web-Scraping-Dienste:

- Datamam

Während sich viele Unternehmen in erster Linie auf automatisierte Eingaben und die Fähigkeit ihrer Kunden, Web-Scraping-Technologien zu nutzen, verlassen, bietet Datamam eine umfassende Beratung an. Das Unternehmen arbeitet mit seinen Kunden zusammen, um maßgeschneiderte Software und Anwendungen zu entwickeln, die auf deren Anforderungen zugeschnitten sind. Dank seiner Erfahrung mit Zehntausenden von Suchanfragen kann das Unternehmen bei der Gestaltung von Lösungen, geeigneten Websites, Suchraten und Datenstrukturen beraten.

Sie liefert den Kunden wichtige Informationen, die es ihnen ermöglichen, schnell bessere Entscheidungen zu treffen. Die Web-Scraping-Lösung von Datamam kann Ihnen dabei helfen, alles zu erreichen, von der Suche nach wettbewerbsfähigen Preisen bis hin zur Überprüfung von Händlerverzeichnissen und der Verfolgung von Kundenmeinungen.

Eigenschaften

- Maßgeschneiderte Lösungen

Ingenieure erstellen einzigartige Software und Anwendungen für Ihr Unternehmen und sparen Ihnen so Zeit.

- Scraping-Dienste ohne Grenzen

Eine einfache Software ermöglicht es Ihnen, für wenig Geld Wissen zu jedem Thema zu suchen und zu erhalten.

- Extraktion durch Automatisierung

Der benutzerdefinierte Code ermöglicht ein schnelles Scraping von zugänglichen Datensätzen von beliebigen Anbietern.

Scraping Process Optimization spart Zeit und ermöglicht es Ihnen, Methoden zu verbessern und wichtige Entscheidungen schneller zu treffen.

Preisgestaltung: - $5.000 - $40.000/Monat

- CrawlNow

CrawlNow bietet datengesteuerten Unternehmen jeder Größe cloudbasierte, maßgeschneiderte Web Scraping-Lösungen. Aufgrund seiner Erfahrung mit hochgradig verteiltem Web Mining und erstklassiger Technologie ist es die zuverlässigste, zugänglichste und kostengünstigste Datenextraktionslösung auf dem Markt.

Es kümmert sich um alles, von der Produkterstellung über die Einrichtung und Verwaltung von Webcrawlern bis hin zur Sicherstellung der Datenqualität und der rechtzeitigen Übermittlung. CrawlNow ist eine verlässliche Quelle, deren Datenströme stets vollständig und korrekt sind.

Eigenschaften

- Web Scraping-Lösung für Unternehmen jeder Größe

- Daten als Service, der vollständig verwaltet wird, ohne dass eine IT-Infrastruktur erforderlich ist

- Leichte Zugänglichkeit

- Eine schnellere und kostengünstigere Option für die Einstellung eines Web-Scraping-Entwicklers

- Beliebige(r) Bereich(e), beliebige Komplexität und beliebiges Tempo

- Kostenlose Projektbewertung

- Am besten geeignet für größere Teams und Datenanforderungen

- Dashboard für Daten QA

- API-Zugang und Datenströme nach einem Zeitplan für die Datenextraktion

- Zusammenarbeit in der Gruppe

- Es gibt unzählige Aufzeichnungen

- Kostenlose Projektbewertung

Preisgestaltung: - $449 - $799/Monat

- ScrapeHero

ScrapeHero ist ein Web Scraper Service, der Lösungen auf Unternehmensniveau anbietet. Er arrangiert Crawler, führt sie aus, verarbeitet die Daten, bewertet die Integrität und stellt sicher, dass sie pünktlich bereitgestellt werden. Außerdem bietet er Automatisierung, Anpassungsfähigkeit und betriebliche Effizienz, um unseren Kunden einen hervorragenden Service ohne zusätzliche Kosten zu bieten.

Eigenschaften

- Intensives Web-Scanning

Sie müssen sich keine Gedanken über Blockierungen, den Kauf von Servern oder die Verwaltung von Proxys machen und können Millionen von Websites mit unglaublicher Geschwindigkeit durchsuchen.

- Daten über Tourismus, Fluggesellschaften und Hotels

Mit unseren hochentwickelten Web Scraping Services können Sie Hotelbewertungen, Preise, Reservierungen und Flugticketkosten aus verschiedenen Quellen sammeln.

- Prozess automatisieren

Optimieren Sie jeden Bereich Ihres Unternehmens.

Verringern Sie manuelle Arbeit, Kosten und Fehler, die durch menschliche Dateneingabe und -überprüfung entstehen.

Sammeln Sie die Informationen und führen Sie sie von Websites ohne Schnittstelle zusammen.

Erstellen Sie komplizierte Automatisierungsprozesse oder automatisieren Sie zeitaufwändige, umfangreiche Aufgaben.

- Überwachung der Marke

Web Scraping ist die treibende Kraft hinter dem Programm zur Markenüberwachung, das nach Ihren Anforderungen und Spezifikationen erstellt wird.

Preise: - 449 $ - 5.000 $/Monat

- Grepsr

Grepsr stattet Unternehmen mit zuverlässigen, präzisen und wertvollen Daten aus. Es bietet eine Datenmanagement-Plattform, die die Zusammenarbeit von Projektteams ermöglicht, die Prozesse zur Extraktion und Bereitstellung von Daten automatisiert und unsere Fähigkeit verbessert, qualitativ hochwertige Dienstleistungen in großem Umfang anzubieten.

Darüber hinaus bietet es technische Beratung an, um Ihnen bei der Gestaltung Ihres Datenbedarfs zu helfen und die gesuchten Ergebnisse zu finden. In den vergangenen zehn Jahren hat das Unternehmen mit fast allen Branchen zusammengearbeitet und sich mit Anwendungsfällen befasst, die in ihrer Komplexität ihresgleichen suchen.

Eigenschaften

- Entwicklung einer einzigartigen Software für gelegentliche oder kleinere Datenextraktionen, die den gesetzlichen Anforderungen und der GDPR (General Data Protection Regulation) entspricht. Ideal für typische Anforderungen an das Data Scraping.

- Verwalten Sie Ihre Datenintegrations- und -erfassungsvorgänge und überprüfen Sie die Datenqualität.

- Erstellen Sie personalisierte Zeitpläne, um sicherzustellen, dass Standardextraktionen pünktlich erfolgen. Planen Sie Ihre Datensammler mit unserem Scheduler, um den Datenerfassungsprozess zu verwalten.

- Unterstützung für eine Vielzahl von Bereitstellungsorten und Datenstrukturen. Integration mit bekannten Systemen wie Google Cloud, Azure, Amazon S3 und mehr.

- Überprüfung des Gesetzes und der Einhaltung der GDPR

- Geprüfte QA-Techniken

- Anti-Ban-Lösung Benutzerdefiniertes Lieferformat Lösen

Preisgestaltung: - $450 - $5.000/Monat

- Apify

Die Ingenieure von Apify stehen Ihnen während der gesamten Projektlaufzeit zur Seite. Sie können Sie bei der Inbetriebnahme, der Wartung und dem Nachweis der Konzeptentwicklung unterstützen. Es garantiert eine qualitativ hochwertige Konstruktion, die mit geringerer Wahrscheinlichkeit kaputt geht, was die Kosten senkt und die Zuverlässigkeit im Laufe der Zeit erhöht.

Apify ermöglicht es Unternehmen und Programmierern, alle manuellen Aufgaben, die sie online durchführen, zu vereinfachen.

Eigenschaften

- Entwurf eines Konzeptnachweises

Sie können den Konzeptnachweis erbringen, indem Sie die Entwicklung an Apify auslagern und die Scraper in Ihre bestehenden Geschäftsplattformen integrieren.

- Wartung

Durch einen Servicevertrag abgesichert, kann die Apify-Gruppe die Leistung Ihrer Web-Scraper im Auge behalten, um sicherzustellen, dass etwaige Fehler erkannt und behoben werden, so dass sich eine schlechte Datenqualität nicht auf den Rest Ihrer Systeme auswirkt.

- Start

Im Vergleich zu einer internen Methode kann das Apify-Projektteam mehr Web Scraper für Sie erstellen und einsetzen, wodurch das interne Entwicklungsteam für andere Aufgaben und Projekte frei wird.

Suchen Sie nach zufälligen Websites und geben Sie JavaScript-Code ein, um Informationen von Webseiten zu sammeln. Der Operator verarbeitet sowohl URLs als auch iteratives Scannen. Diese Funktion ist das grundlegende Web-Scan-Tool von Apify.

Preisgestaltung: - $49 - $499/Monat

- WebScrapingAPI

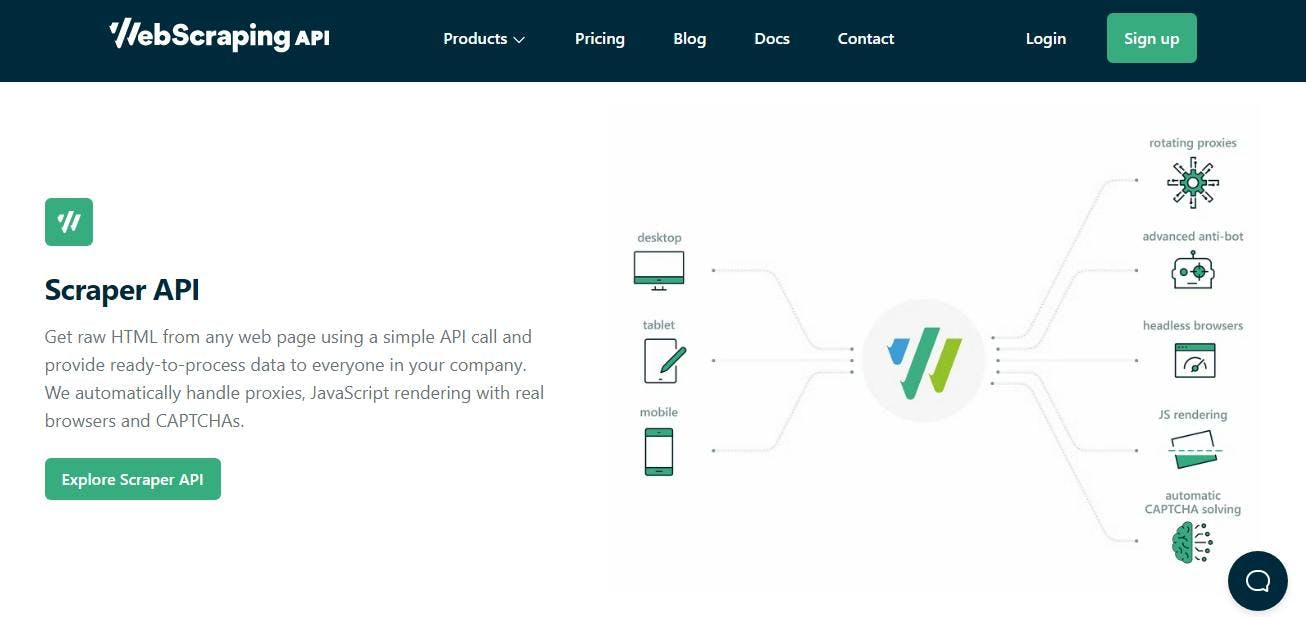

WebScrapingAPI ist eine einfache, schnelle und zuverlässige REST-API, die HTML aus jeder Online-Seite extrahiert. Es behandelt alle potenziellen Blockierungsfaktoren im Backend, einschließlich Firewalls, Javascript-Verarbeitung, IP-Spins, CAPTCHAs und andere. Wenn Sie versuchen, eine Website zu scrapen, können Sie auf verschiedene Hindernisse stoßen, die WebScrapingAPI beseitigt.

Der Einsatz von Web Scraping APIs (WSAPI) hilft Unternehmen, ihre aktuellen webbasierten Systeme als gut durchdachte Sammlung von Diensten zur Unterstützung von mobilen Anwendungen und Entwicklern, zur Entwicklung neuer Geschäftsplattformen und zur Verbesserung der Interaktion mit Partnern zu erweitern.

Web-Scraping-APIs stellen saubere, organisierte Daten von aktuellen Websites zur Verfügung, damit andere Anwendungen sie nutzen können. Die von Web-Scraping-APIs bereitgestellten Daten können nachverfolgt, geändert und verwaltet werden. Bei der Migration von Websites zu Einstellungen ermöglicht die integrierte Architektur von Online-Scraping-APIs den Entwicklern, Website-Änderungen zu übernehmen, ohne den Erfassungsalgorithmus zu ändern.

Eigenschaften

- Informationen von jeder Website abrufen

- Leicht anpassbar und benutzerfreundlich

- Mit unseren ausgefeilten Funktionen können Sie mit Protokollen, IP-Zuordnung, dauerhaften Sitzungen und vielen anderen Optionen experimentieren, um Ihre Abfragen an Ihre speziellen Anforderungen anzupassen.

- Skalierbarkeit auf Unternehmensniveau und blitzschnelles Scraping

Preisgestaltung: - $49 - $799/Monat

Abschließende Überlegungen

Nun, da Sie den Preis von Web Scraper Services kennen, ist es an der Zeit, das Produkt oder die Dienstleistung zu wählen, die Ihren Anforderungen und Ihrem Budget am besten entspricht.

Wenn Sie gerade erst anfangen, sollten Sie sich WebScrapingAPI ansehen, eine hervorragende No-Code-Lösung für die Beschaffung umfangreicher Webdaten. Testen Sie WebScrapingAPI, um das Universum der Daten zu erkunden!

Fähigkeiten

- Scraper-API

Mit der Web Scraping API-Funktion können Daten von Websites abgerufen werden, ohne Gefahr zu laufen, blockiert zu werden. Aus diesem Grund ist die IP-Rotation die Funktion, die sich am besten dafür eignet.

- Amazon Produktdaten-API

Sie können auch Daten im JSON-Format extrahieren, indem Sie die Amazon Product Data API-Funktion verwenden. Es wird empfohlen, diese Funktion für einen sicheren JavaScript-Rendering-Prozess zu verwenden.

- Google Suchergebnisse API

Dank der von der Search Console-API bereitgestellten Funktionen können Sie in Ihrem Search Console-Konto auf die nützlichsten Erkenntnisse und Aktionen zugreifen. Mit ihrer Hilfe können Sie Ihre Sitemaps aktualisieren, Ihre verifizierten Websites anzeigen und Ihre Suchstatistiken im Auge behalten.

Bedeutende Unternehmen wie InfraWare, SteelSeries, Deloitte und andere verlassen sich aufgrund dieser Vorteile auf WebScrapingAPI-Lösungen.

Registrieren Sie sich für eine kostenlose 30-Tage-Testversion, um das umfassende WebScrapingAPI-Paket zu testen.

Die Tatsache, dass keine Daten für die Extraktion von Webdaten mit diesen Web-Scrapern nicht zur Verfügung stehen, ist einzigartig. Machen Sie weiter und nutzen Sie die Daten, die Sie abgerufen haben, um Ihr Unternehmen zu entwickeln.

Verwandte Themen:

Nachrichten und Aktualisierungen

Bleiben Sie auf dem Laufenden mit den neuesten Web Scraping-Anleitungen und Nachrichten, indem Sie unseren Newsletter abonnieren.

Der Schutz Ihrer Daten liegt uns am Herzen. Lesen Sie unsere Datenschutzrichtlinie.

Ähnliche Artikel

Entdecken Sie die Komplexität des Scrapens von Amazon-Produktdaten mit unserem ausführlichen Leitfaden. Von Best Practices und Tools wie der Amazon Scraper API bis hin zu rechtlichen Aspekten erfahren Sie, wie Sie Herausforderungen meistern, CAPTCHAs umgehen und effizient wertvolle Erkenntnisse gewinnen.

Erforschen Sie den detaillierten Vergleich zwischen Scrapy und Selenium für Web Scraping. Von der Datenerfassung in großem Maßstab bis hin zum Umgang mit dynamischen Inhalten - entdecken Sie die Vor- und Nachteile sowie die einzigartigen Funktionen der beiden Frameworks. Erfahren Sie, wie Sie das beste Framework für die Anforderungen und den Umfang Ihres Projekts auswählen können.

Erforschen Sie die transformative Kraft des Web Scraping im Finanzsektor. Von Produktdaten bis zur Stimmungsanalyse bietet dieser Leitfaden Einblicke in die verschiedenen Arten von Webdaten, die für Investitionsentscheidungen zur Verfügung stehen.