Web Scraping vs. Web Crawling: Verstehen Sie den Unterschied

Anda Miuțescu am 01. Juli 2021

Was war zuerst da? Der Web Crawler oder der Web Scraper?

Es kommt darauf an, wie Sie zwischen Extraktion und Herunterladen unterscheiden. Web Scraping erfordert nicht immer die Nutzung des Internets. Das Extrahieren von Informationen aus einem lokalen System, einer Datenbank oder mit Hilfe von Data Scraping Tools kann als Datensammlung bezeichnet werden. In der Zwischenzeit sind Web-Crawler in erster Linie damit beauftragt, eine Kopie aller aufgerufenen Seiten für die spätere Verarbeitung durch Suchmaschinen anzufertigen, die die gespeicherten Seiten indizieren und schnell nach den nicht indizierten Seiten suchen werden.

In diesem Artikel werden die Unterschiede und gemeinsamen Funktionen von Web Scraping, Crawling und allem, was dazwischen liegt, erläutert. Als Bonus haben wir einen ausführlichen Leitfaden für die Erstellung eines eigenen Webcrawlers beigefügt, also lesen Sie weiter!

Was ist Web Scraping?

Web Scraping, auch bekannt als Datenextraktion, ist der automatisierte Prozess der Sammlung strukturierter Informationen aus dem Internet. Dieser Oberbegriff deckt ein breites Spektrum von Techniken und Anwendungsfällen ab, die den Modus Operandi von Big Data beinhalten.

Auf der einfachsten Ebene bezieht sich Web Scraping auf das Kopieren von Daten aus einer Website. Anschließend können die Benutzer die gescrapten Daten in eine Tabellenkalkulation oder eine Datenbank importieren oder eine Software zur weiteren Verarbeitung einsetzen.

Wer profitiert vom Web Scraping? Jeder, der umfangreiches Wissen zu einem bestimmten Thema benötigt. Wenn Sie sich schon einmal an eine Recherche gewagt haben, war Ihr erster Instinkt höchstwahrscheinlich, Daten aus Quellen manuell zu kopieren und in Ihre lokale Datenbank einzufügen.

Dank Automatisierungstools können Entwickler heute problemlos Web-Scraping-Techniken einsetzen. Was früher wochenlang von einem Team erledigt werden musste, kann heute innerhalb weniger Stunden mit absoluter Genauigkeit selbstständig durchgeführt werden.

Die Umstellung von manuellem auf automatisches Scraping spart dem Einzelnen Zeit. Außerdem bietet es Entwicklern einen wirtschaftlichen Vorteil. Die durch den Einsatz von Web-Scrapern gesammelten Daten können später in das CSV-, HTML-, JSON- oder XML-Format exportiert werden.

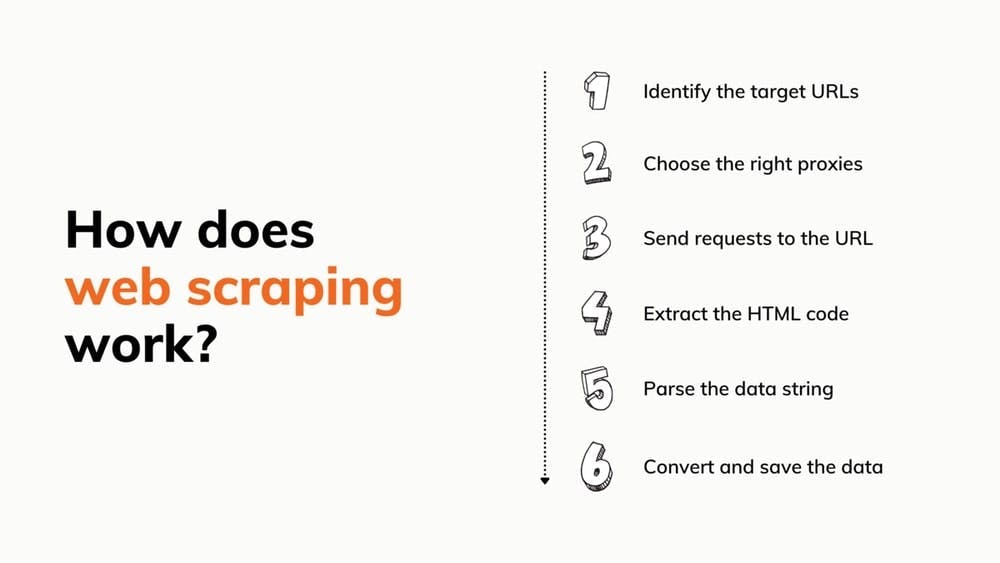

Wie funktioniert das Web Scraping?

Klingt einfach, oder? Nun, die Entwicklung eines Scrapers von 0 auf, der all das kann, ist zeitaufwändig. Ganz zu schweigen davon, dass der Bot möglicherweise nicht immer funktioniert und dass Sie Proxys mieten müssen. Wenn Sie es trotzdem versuchen wollen, haben wir einige Anleitungen, die Ihnen helfen werden.

Einer der verlockendsten Aspekte der Verwendung eines vorgefertigten Tools ist jedoch, wie einfach es ist, es in Ihr Projekt zu integrieren. Alles, was Sie brauchen, sind eine Reihe von Anmeldeinformationen und ein rudimentäres Verständnis der API-Dokumentation.

Außerdem können vorgefertigte Scraper mit vielen anderen Extras ausgestattet sein:

- Ein integrierter Headless-Browser zur Ausführung von Javascript

- Ein Captcha-Löser

- Ein Proxy-Pool, der Millionen von IPs umfasst

- Ein Proxy-Rotator

- Eine einfache Schnittstelle zur Anpassung von Anfragen

Unser Team hat eine Web-Scraping-API entwickelt, mit der Sie viel Zeit sparen können. Wir haben die Branche gründlich untersucht und uns darauf konzentriert, die vorteilhafteste Lösung zu entwickeln, die wir uns vorstellen konnten.

Was ist Web Crawling?

Wir alle kennen und benutzen Google, Bing oder andere Suchmaschinen. Sie zu benutzen ist einfach - man fragt sie nach etwas und sie suchen in jeder Ecke des Webs, um einem eine Antwort zu geben. Aber letzten Endes lebt Google von der Gnade seines Googlebot-Crawlers.

Webcrawler werden von Suchmaschinen eingesetzt, um das Internet nach Seiten zu durchsuchen, die den von Ihnen eingegebenen Schlüsselwörtern entsprechen, und sie durch Indizierung für die spätere Verwendung in den Suchergebnissen zu speichern. Crawler helfen Suchmaschinen auch bei der Erfassung von Website-Daten: URLs, Hyperlinks, Meta-Tags und schriftliche Inhalte sowie die Überprüfung des HTML-Textes.

Sie müssen nicht befürchten, dass der Bot in einer Endlosschleife immer wieder dieselben Websites besucht, denn er merkt sich, was er bereits besucht hat. Ihr Verhalten wird auch durch eine Mischung von Kriterien bestimmt, wie z. B.:

- Politik der Wiederbesuche

- Auswahlverfahren

- Deduplizierungsrichtlinie

- Höflichkeitspolitik

Web-Crawler sehen sich mit mehreren Hindernissen konfrontiert, darunter das riesige und sich ständig verändernde öffentliche Internet und die Auswahl der Inhalte. Täglich werden zahllose Informationen ins Netz gestellt. Daher müssen sie ihre Indizes ständig aktualisieren und Millionen von Seiten durchforsten, um genaue Ergebnisse zu erzielen. Nichtsdestotrotz sind sie ein wesentlicher Bestandteil der Systeme, die den Inhalt von Websites untersuchen.

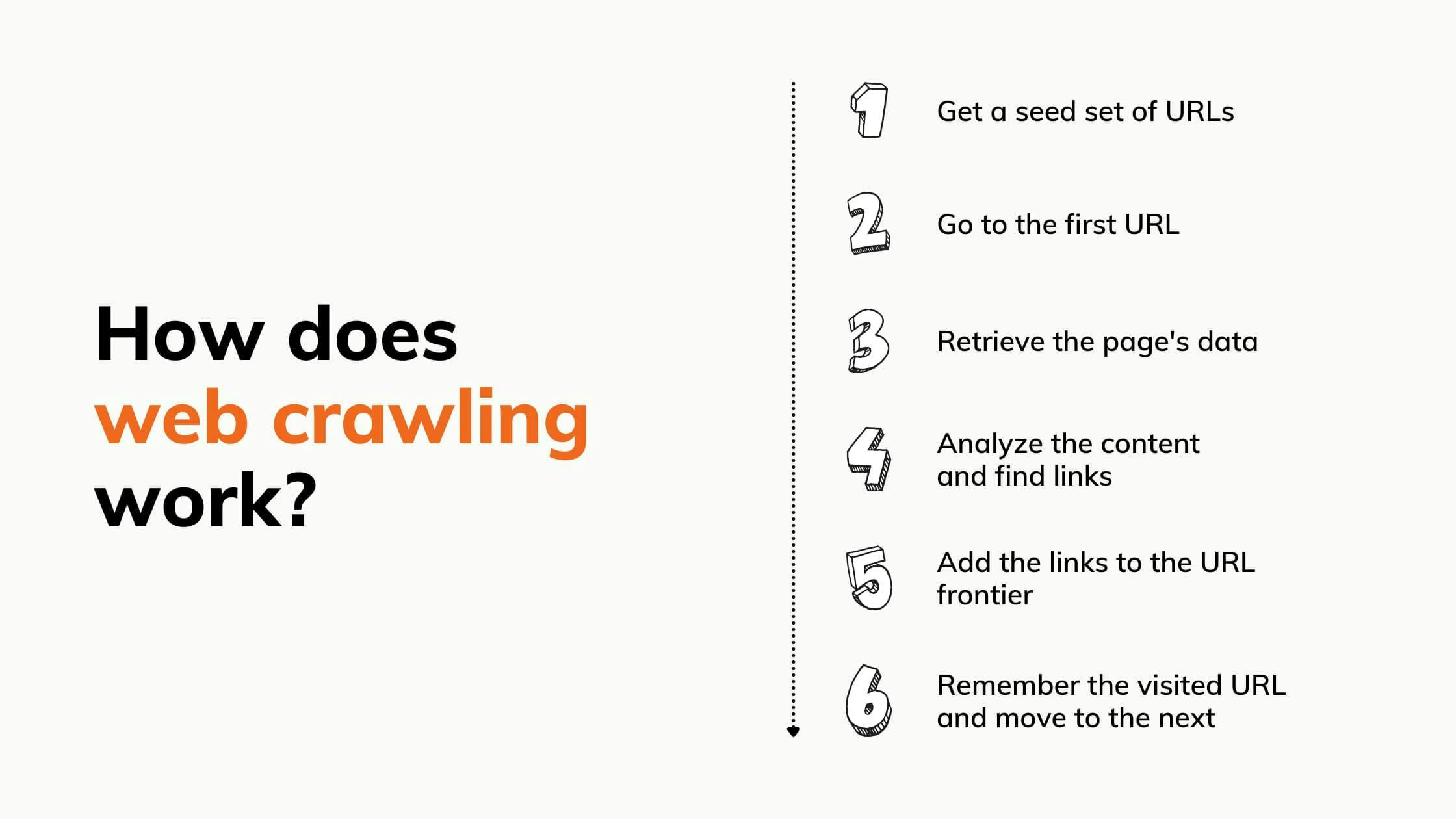

Wie funktioniert das Web-Crawling?

Suchmaschinen haben keine Möglichkeit zu erkennen, welche Webseiten es gibt. Bevor sie die relevanten Seiten nach Schlüsselwörtern durchsuchen können, müssen die Robots sie crawlen und indexieren. Hier sind die 7 umfassenden Schritte:

Web Scraping vs. Web Crawling

Web Scraping wird häufig mit Web Crawling verwechselt. Web-Scraping unterscheidet sich vom Web-Crawling dadurch, dass es Daten von jeder Seite, auf die es zugreift, extrahiert und dupliziert, während Web-Crawling Seiten für die Indizierung durchsucht und liest. Crawling sucht nach Seiten und Inhalten, Scraping sorgt dafür, dass die Daten zu Ihnen gelangen.

Der Mythos, dass Web Scraping und Web Crawling gleichzeitig funktionieren, ist ein Missverständnis, mit dem wir gerne aufräumen. Web Scraping ist eine Technik zur Extraktion von Daten aus Webseiten. Unabhängig davon, ob es sich um gecrawlte Seiten, um alle Seiten hinter einer bestimmten Website oder um Seiten in digitalen Archiven handelt, kann beim Web Crawling eine URL-Liste erstellt werden, die der Scraper sammeln soll. Wenn ein Unternehmen beispielsweise Informationen von einer Website sammeln will, wird es die Seiten crawlen und dann diejenigen auslesen, die wertvolle Daten enthalten.

Die Kombination von Web Crawling und Web Scraping führt zu mehr Automatisierung und weniger Ärger. Durch Crawling können Sie eine Linkliste erstellen und diese dann an den Scraper senden, damit dieser weiß, was zu extrahieren ist. Der Vorteil ist das Sammeln von Daten aus dem gesamten World Wide Web ohne jegliche menschliche Arbeit.

Anwendungsfälle

Web Scraping und Web Crawling sind eine hervorragende Kombination, um schnell Daten zu sammeln und zu verarbeiten, die ein Mensch nicht in der Lage wäre, in der gleichen Zeit zu analysieren. Hier sind einige Beispiele dafür, wie dieses Tandem in der Wirtschaft helfen kann:

Schutz der Marke. Sie können die Tools nutzen, um schädliche Online-Inhalte für Ihre Marke (wie Patentdiebstahl, Markenrechtsverletzungen oder Fälschungen) schnell zu finden und aufzulisten, damit Sie rechtliche Schritte gegen die Verantwortlichen einleiten können.

Überwachung von Marken. Die Überwachung von Marken ist viel einfacher, wenn ein Webcrawler eingesetzt wird. Der Crawler kann Erwähnungen Ihres Unternehmens in der Online-Umgebung aufspüren und sie so kategorisieren, dass sie leichter zu verstehen sind, z. B. Nachrichtenartikel oder Beiträge in sozialen Medien. Fügen Sie Web Scraping hinzu, um den Prozess zu vervollständigen und die Informationen in Ihre Hände zu bekommen.

Preiskontrolle. Unternehmen nutzen Scraping, um Produktdaten zu extrahieren, zu analysieren, wie sie sich auf ihr Verkaufsmodell auswirken, und um die beste Marketing- und Verkaufsstrategie zu entwickeln. Crawler hingegen suchen nach neuen Produktseiten, die wertvolle Informationen enthalten.

E-Mail-Marketing. Web Scraping kann Websites, Foren und Kommentarabschnitte mit halsbrecherischer Geschwindigkeit erfassen und alle E-Mail-Adressen extrahieren, die Sie für Ihre nächste Kampagne benötigen. E-Mail-Crawling kann sogar Foren und Chat-Gruppen durchsuchen und nach E-Mails suchen, die zwar versteckt sind, aber in den Kopfzeilen gefunden werden können.

Verarbeitung natürlicher Sprache. In diesem Fall werden die Bots in der Sprachforschung eingesetzt, wo Maschinen bei der Interpretation der von Menschen verwendeten natürlichen Sprachen helfen.

Crawler und Scraper werden eingesetzt, um diesen Maschinen riesige Mengen sprachlicher Daten zu liefern, damit sie Erfahrungen sammeln können. Je mehr Daten an die Maschine gesendet werden, desto schneller wird sie ihr ideales Verständnisniveau erreichen. Foren, Marktplätze und Blogs, die verschiedene Arten von Bewertungen enthalten, sind die häufigsten Orte, an denen diese Art von Informationen gesammelt werden.

Über das Internet kann es trainiert werden, Slang zu lernen und zu erkennen, was im heutigen Marketing von entscheidender Bedeutung ist und eine Vielzahl von Hintergründen ansprechen soll.

Immobilien Asset Management: In der Immobilienbranche werden Webcrawler und Scraper häufig für die Analyse von Marktdaten und Trends eingesetzt. Beide liefern detaillierte Informationen über Immobilien oder bestimmte Gebäudegruppen, unabhängig von der Anlageklasse (Büro, Industrie oder Einzelhandel), was den Vermietungsunternehmen einen Wettbewerbsvorteil verschafft. Um die Dinge ins rechte Licht zu rücken, schaffen die Bots Erkenntnisse, die zu besseren Marktprognosen und besseren Immobilienverwaltungspraktiken führen.

Lead-Generierung. Anzeigen und Sonderangebote sind nutzlos, wenn sie nicht die richtigen Leute erreichen. Unternehmen setzen Crawler und Scraper ein, um diese Personen zu finden, sei es in sozialen Medien oder in Unternehmensregistern. Die Bots können schnell Kontaktinformationen finden und sammeln, die dann an das Vertriebs- oder Marketingteam weitergeleitet werden.

Wie man einen Webcrawler baut

Jetzt, wo Sie wissen, wie das Rad sich dreht, fragen Sie sich wahrscheinlich, wie man Websites crawlen kann. Einen eigenen Crawler zu bauen, spart Geld und ist einfacher, als Sie vielleicht denken. Auf dieser Grundlage haben wir einen detaillierten Leitfaden über die Vor- und Nachteile, die Vorgehensweisen und alles, was dazwischen liegt, erstellt.

Voraussetzungen

- Python3.

- Python-IDE. Empfehlung: In diesem Leitfaden verwenden wir Visual Studio Code, aber jede andere IDE ist ebenfalls geeignet.

- Selenium: zum Scrapen des HTML von dynamischen Websites.

- Beautifulsoup: zum Parsen des HTML-Dokuments.

- ChromeDriver: ein Web-Treiber zur Konfiguration von Selenium. Laden Sie die richtige Version herunter und merken Sie sich den Pfad, in dem Sie sie gespeichert haben!

Einrichten der Umgebung

Installieren wir zunächst die benötigten Bibliotheken. Öffnen Sie ein Terminal in der IDE Ihrer Wahl und führen Sie die folgenden Befehle aus:

> pip install selenium

> pip install beautifulsoup4

Nun importieren wir die Bibliotheken, die wir installiert haben, in unseren Python-Code. Außerdem definieren wir die URL, die wir crawlen werden, und fügen die Konfiguration für Selenium hinzu. Erstellen Sie einfach eine Datei crawler.py und fügen Sie Folgendes hinzu:

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

from bs4 import BeautifulSoup

CHROMEDRIVER_PATH = "your/path/here/chromedriver_win32/chromedriver"

BASE_URL = "https://ecoroots.us"

SECTION = "/collections/home-kitchen"

FULL_START_URL = BASE_URL + SECTION

options = Options()

options.headless = True

driver = webdriver.Chrome(CHROMEDRIVER_PATH, options=options)

Wählen Sie eine Website und prüfen Sie den HTML-Code

Wir haben eine E-Commerce-Website gewählt, die Zero-Waste-Produkte verkauft, und wir werden auf die Seite jedes Produkts zugreifen und dessen HTML extrahieren. Wir werden also nach allen internen Links auf der Website des Geschäfts suchen und rekursiv auf sie zugreifen. Doch zunächst werfen wir einen Blick auf die Seitenstruktur und stellen sicher, dass wir nicht auf Probleme mit der Crawlability stoßen. Klicken Sie mit der rechten Maustaste auf eine beliebige Stelle der Seite, dann auf Element inspizieren, und voila! Das HTML ist unser.

Aufbau des Crawlers

Jetzt können wir mit dem Schreiben des Codes beginnen. Um unseren Crawler zu erstellen, folgen wir einem rekursiven Ablauf, so dass wir auf alle Links zugreifen können, die wir finden. Aber zuerst müssen wir unseren Einstiegspunkt definieren:

def crawl(url, filename):

page_body = get_page_source(url, filename)

soup = BeautifulSoup(page_body, 'html.parser')

start_crawling(soup)

crawl(FULL_START_URL, 'ecoroots.txt')

Wir implementieren die Crawl-Funktion, die die HTML-Dokumente über unsere get_page_source-Prozedur extrahiert. Dann wird das BeautifulSoup-Objekt erstellt, das uns das Parsen erleichtert, und die Funktion start_crawling aufgerufen, die mit der Navigation auf der Website beginnt.

def get_page_source(url, filename):

driver.get(url)

soup = BeautifulSoup(driver.page_source, 'html.parser')

body = soup.find('body')

file_source = open(filename, mode='w', encoding='utf-8')

file_source.write(str(body))

file_source.close()

return str(body)

As stated earlier, the get_page_source function will use selenium to get the HTML content of the website and will write in a text file in the <body> section, as it’s the one containing all the internal links we are interested in.

unique_links = {}

def start_crawling(soup):

links = soup.find_all(lambda tag: is_internal_link(tag))

for link in links:

link_href = link.get('href')

if not link_href in unique_links.keys() or unique_links[link_href] == 0:

unique_links[link_href] = 0

link_url = BASE_URL + link_href

link_filename = link_href.replace(SECTION + '/products/', '') + '.txt'

crawl(link_url, link_filename)

unique_links[link_href] = 1Dies ist die Hauptlogik des Crawlers. Sobald er das BeautifulSoup-Objekt erhält, extrahiert er alle internen Links. Dazu verwenden wir eine Lambda-Funktion mit ein paar Bedingungen, die wir in der Funktion is_internal_link definiert haben:

def is_internal_link(tag):

if not tag.name == 'a': return False

if tag.get('href') is None: return False

if not tag.get('href').startswith(SECTION + '/products'): return False

return True

This means that for every HTML element that we encounter, we first verify if it’s a <a> tag, if it has an href attribute, and then if the href attribute’s value has an internal link.

Nachdem wir die Auflistung der Links erhalten haben, wiederholen wir jeden einzelnen, erstellen die vollständige URL und extrahieren den Namen des Produkts. Mit diesen neuen Daten haben wir eine neue Website, die wir von unserem Einstiegspunkt aus an die Crawl-Funktion übergeben, und so beginnt der Prozess von vorne.

Was aber, wenn wir auf einen Link stoßen, den wir bereits besucht haben? Wie lässt sich ein endloser Zyklus vermeiden? Nun, für diese Situation gibt es die Datenstruktur unique_links. Für jeden Link, den wir durchlaufen, überprüfen wir, ob er bereits besucht wurde, bevor wir mit dem Crawlen beginnen. Wenn es ein neuer Link ist, markieren wir ihn einfach als besucht, sobald das Crawling abgeschlossen ist.

Sobald Sie Ihr Skript gestartet haben, beginnt der Crawler, die Produkte der Website zu durchsuchen. Das kann einige Minuten dauern, je nachdem, wie groß die von Ihnen gewählte Website ist. Schließlich sollten Sie jetzt eine Reihe von Textdateien haben, die den HTML-Code jeder Seite enthalten, die Ihr Crawler besucht.

Abschließende Überlegungen

Web-Crawling und Web-Scraping sind eng miteinander verwoben und beeinflussen den Erfolg des jeweils anderen, indem sie zu den Informationen beitragen, die letztendlich verarbeitet werden. Wir hoffen, dass dieser Artikel Ihnen hilft, die Verwendung dieser beiden Mechanismen und die Umgebungen, in denen sie eingesetzt werden können, zu beurteilen.

Automatisierung ist die Zukunft der Datenerfassung. Allein aus diesem Grund haben wir mit eine Lösung entwickelt, die Ihnen das Schreiben von Code erspart, bei der Sie schnellen Zugang zu Webinhalten erhalten und IP-Sperren vermeiden. Bevor Sie Ihr Budget in Ordnung bringen, sollten Sie unser kostenloses Testpaket ausprobieren, in dem Proxys für private und mobile Endgeräte von Anfang an enthalten sind. Kratzen Sie weiter.

Nachrichten und Aktualisierungen

Bleiben Sie auf dem Laufenden mit den neuesten Web Scraping-Anleitungen und Nachrichten, indem Sie unseren Newsletter abonnieren.

Der Schutz Ihrer Daten liegt uns am Herzen. Lesen Sie unsere Datenschutzrichtlinie.

Ähnliche Artikel

Erfahren Sie, wie Sie mit Hilfe von Datenparsing, HTML-Parsing-Bibliotheken und schema.org-Metadaten effizient Daten für Web-Scraping und Datenanalysen extrahieren und organisieren können.

Automatisieren Sie Web Scraping und Dateidownloads mit Python und wget. Erfahren Sie, wie Sie mit diesen Tools Daten sammeln und Zeit sparen können.

In diesem Tutorial wird gezeigt, wie man mit Python das Web crawlen kann. Web-Crawling ist ein leistungsfähiger Ansatz zum Sammeln von Daten aus dem Web, indem alle URLs für eine oder mehrere Domänen gefunden werden.