Wie man mit WebScrapingAPI jede Website scrapen kann

Robert Munceanu am 07. April 2021

Wenn Sie sich für Web Scraper interessieren und eine Lösung suchen, die verschiedene Daten aus dem Internet extrahieren kann, sind Sie hier genau richtig!

In diesem Artikel zeigen wir Ihnen, wie einfach es ist, die WebScrapingAPI zu nutzen, um die benötigten Informationen in wenigen Augenblicken zu erhalten und die Daten nach Belieben zu manipulieren.

Es ist möglich, einen eigenen Scraper zu erstellen, um Daten aus dem Internet zu extrahieren, aber die Entwicklung erfordert viel Zeit und Mühe, da auf dem Weg dorthin einige Herausforderungen zu bewältigen sind. Und Zeit ist von entscheidender Bedeutung.

Lassen Sie uns ohne weiteres sehen, wie Sie mit WebScrapingAPI Daten von jeder Website extrahieren können. Doch zunächst gehen wir darauf ein, warum WebScraper so wertvoll sind und wie sie Ihnen oder Ihrem Unternehmen helfen können, Ihre Wachstumsziele zu erreichen.

Wie Web Scraping Ihnen helfen kann

Web Scraping kann für verschiedene Zwecke nützlich sein. Unternehmen nutzen Datenextraktionstools, um ihr Geschäft auszubauen. Forscher können die Daten nutzen, um Statistiken zu erstellen oder ihre Doktorarbeit zu unterstützen. Sehen wir uns an, wie:

- Optimierung der Preisgestaltung: Wenn Sie einen besseren Überblick über Ihre Konkurrenz haben, kann Ihr Unternehmen wachsen. Auf diese Weise wissen Sie, wie die Preise in der Branche schwanken und wie sich das auf Ihr Geschäft auswirken kann. Auch wenn Sie auf der Suche nach einem Artikel sind, den Sie kaufen möchten, können Sie so die Preise verschiedener Anbieter vergleichen und das beste Angebot finden.

- Forschung: Dies ist ein effizienter Weg, um Informationen für Ihr Forschungsprojekt zu sammeln. Statistiken und Datenberichte sind wichtig für die Authentizität Ihrer Berichte. Die Verwendung eines Web-Scraping-Tools beschleunigt diesen Prozess.

- Maschinelles Lernen: Um Ihre KI zu trainieren, benötigen Sie eine große Menge an Daten, deren manuelle Extraktion sehr viel Zeit in Anspruch nehmen kann. Wenn Sie beispielsweise möchten, dass Ihre KI Hunde auf Fotos erkennt, benötigen Sie eine Menge Welpen.

Die Liste lässt sich fortsetzen, aber Sie dürfen nicht vergessen, dass Web Scraping ein sehr wichtiges Werkzeug ist, da es viele Verwendungsmöglichkeiten hat, genau wie ein Schweizer Taschenmesser! Wenn Sie neugierig sind , wann Web Scraping die Antwort auf Ihre Probleme sein kann, schauen Sie doch mal rein.

Als Nächstes sehen Sie einige Funktionen und wie WebScrapingAPI helfen kann, das Web zu scrapen und Daten zu extrahieren, als ob niemand zuschauen würde!

Was WebScrapingAPI zu bieten hat

Wahrscheinlich haben Sie daran gedacht, Ihr eigenes Web-Scraping-Tool zu erstellen, anstatt ein vorgefertigtes zu verwenden, aber es gibt viele Dinge, die Sie berücksichtigen müssen, und diese können viel Zeit und Mühe kosten.

Nicht alle Websites wollen gescraped werden, also entwickeln sie Gegenmaßnahmen, um den Bot zu erkennen und daran zu hindern, Ihr Gebot zu erfüllen. Sie können verschiedene Methoden wie CAPTCHAs, Ratenbegrenzung und Browser-Fingerprinting einsetzen. Wenn ihnen Ihre IP-Adresse verdächtig vorkommt, ist die Wahrscheinlichkeit groß, dass Sie nicht mehr lange Scraping betreiben werden.

Einige Websites wollen nur in bestimmten Regionen der Welt abgerufen werden, so dass Sie einen Proxy verwenden müssen, um auf ihre Inhalte zuzugreifen. Aber auch die Verwaltung eines Proxy-Pools ist keine leichte Aufgabe, da Sie ihn ständig wechseln müssen, um unentdeckt zu bleiben, und bestimmte IP-Adressen für geografisch eingeschränkte Inhalte verwenden müssen.

Trotz all dieser Probleme nimmt WebScrapingAPI Ihnen diese Last von den Schultern und löst die Probleme mit Leichtigkeit, so dass Scraping wie ein Kinderspiel klingt. Werfen Sie einen Blick darauf und sehen Sie selbst , welche Hindernisse beim Web-Scraping auftreten können!

Nun, da wir wissen, wie WebScrapingAPI uns helfen kann, wollen wir herausfinden, wie man es benutzt, und seien Sie versichert, dass es auch ziemlich einfach ist!

Wie man WebScrapingAPI verwendet

API-Zugangsschlüssel und Authentifizierung

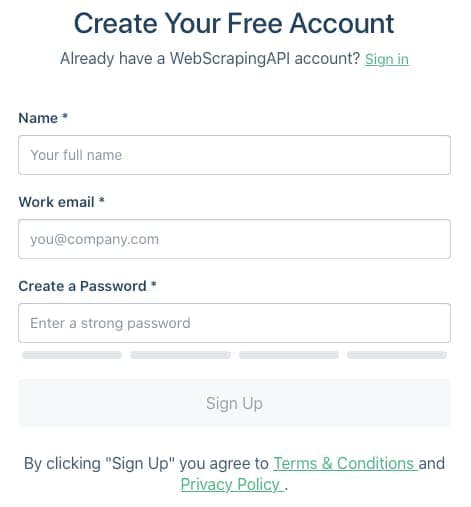

Das Wichtigste zuerst: Um WebScrapingAPI nutzen zu können, benötigen wir einen Zugangsschlüssel. Um diesen zu erhalten, müssen Sie ein Konto erstellen. Der Prozess ist ziemlich einfach, und Sie müssen nichts bezahlen, da es auch ein kostenloses Abonnement gibt!

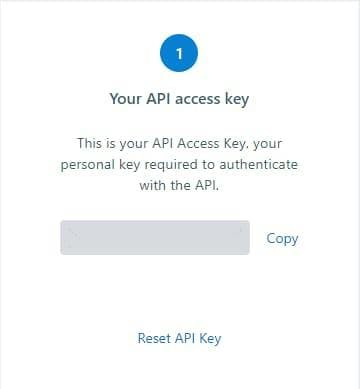

Nach der Anmeldung werden Sie zum Dashboard weitergeleitet, wo Sie Ihren eindeutigen Zugangsschlüssel sehen können. Achten Sie darauf, dass Sie ihn geheim halten, und wenn Sie jemals denken, dass Ihr eindeutiger Schlüssel kompromittiert wurde, können Sie jederzeit die Schaltfläche "API-Schlüssel zurücksetzen" verwenden, um einen neuen zu erhalten.

Nachdem Sie Ihren Schlüssel in die Hände bekommen haben, können wir zum nächsten Schritt übergehen und sehen, wie wir ihn verwenden können.

Dokumentation

Es ist wichtig zu wissen, welche Funktionen WebScrapingAPI hat, um uns bei unserem Web-Scraping-Abenteuer zu helfen. All diese Informationen finden Sie in der Dokumentation, die ausführlich und mit Codebeispielen in verschiedenen Programmiersprachen präsentiert wird. Die einfachste Anfrage, die Sie an die API stellen können, besteht darin, die Parameter api_key und url auf Ihren Zugangsschlüssel bzw. die URL der Website zu setzen, die Sie scrapen möchten. Hier ist ein kurzes Beispiel in Python:

import http.client

conn = http.client.HTTPSConnection("api.webscrapingapi.com")

conn.request("GET", "/v1?api_key=XXXXX&url=http%3A%2F%2Fhttpbin.org%2Fip")

res = conn.getresponse()

data = res.read()

print(data.decode("utf-8"))

WebScrapingAPI verfügt über weitere Funktionen, die für Scraping verwendet werden können. Einige davon können durch die Angabe einiger weiterer Parameter genutzt werden, andere sind bereits in der API implementiert, über die wir bereits gesprochen haben.

Sehen wir uns ein paar andere Parameter an, die wir einstellen können, und warum sie für unsere Datenextraktion nützlich sind:

- render_js: Bei einigen Websites werden wichtige Seitenelemente mit JavaScript gerendert, was bedeutet, dass einige Inhalte beim ersten Laden der Seite nicht angezeigt werden und nicht erfasst werden können. Mit einem Headless-Browser kann WSA diese Inhalte rendern und für Sie auslesen. Setzen Sie einfach render_js=1, und Sie können loslegen!

- proxy_type: Sie können wählen, welche Art von Proxys Sie verwenden möchten. Hier erfahren Sie , warum Proxys so wichtig sind und wie sich die Art des Proxys auf Ihr Web Scraping auswirken kann.

- Land: Die Geolokalisierung ist nützlich, wenn Sie von verschiedenen Standorten aus scrapen wollen, da der Inhalt einer Website je nach Region unterschiedlich oder sogar exklusiv sein kann. Hier legen Sie den von WSA unterstützten 2-Buchstaben-Ländercode fest.

API-Spielplatz

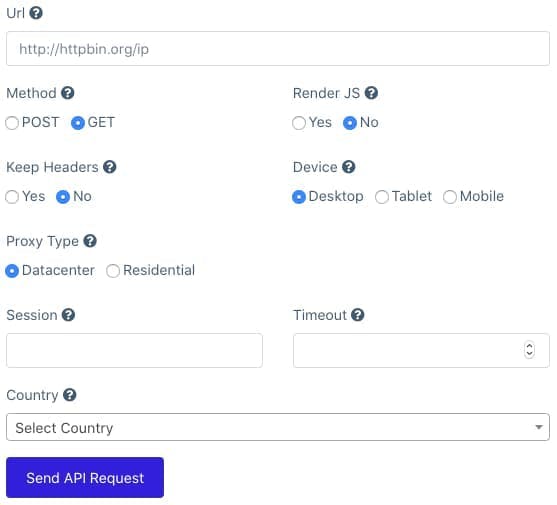

Wenn Sie die WebScrapingAPI in Aktion sehen möchten, bevor Sie sie in Ihr Projekt integrieren, können Sie die Spielwiese verwenden, um einige Ergebnisse zu testen. Es hat eine freundliche Schnittstelle und ist einfach zu bedienen. Wählen Sie einfach die Parameter für die Art von Scraping, die Sie durchführen möchten, und senden Sie die Anfrage.

Im Ergebnisbereich sehen Sie die Ausgabe nach dem Scraping und das Codebeispiel der besagten Anfrage in verschiedenen Programmiersprachen zur leichteren Integration.

API-Integration

Wie können wir WSA in unserem Projekt verwenden? Werfen wir einen Blick auf dieses kurze Beispiel, in dem wir Amazon scrapen, um die teuerste Grafikkarte auf einer Seite zu finden. Dieses Beispiel ist in JavaScript geschrieben, aber Sie können es in jeder Programmiersprache machen, mit der Sie sich wohl fühlen.

Zuerst müssen wir einige Pakete installieren, die uns bei der HTTP-Anfrage(got) und beim Parsen des Ergebnisses(jsdom) helfen, indem wir diese Befehlszeile im Terminal des Projekts verwenden:

npm install got jsdom

Als Nächstes müssen wir die für unseren Antrag erforderlichen Parameter festlegen:

const params = {

api_key: "XXXXXX",

url: "https://www.amazon.com/s?k=graphic+card"

}So bereiten wir die Anfrage an WebScrapingAPI vor, um die Website für uns zu scrapen:

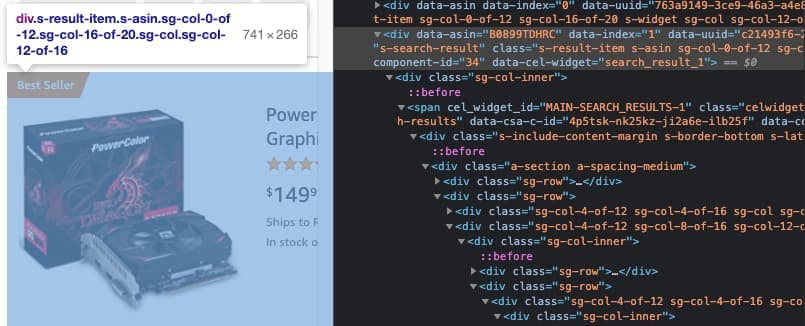

const response = await got('https://api.webscrapingapi.com/v1', {searchParams: params})Jetzt müssen wir sehen, wo sich jedes Element der Grafikkarte im HTML befindet. Mit dem Developer Tool haben wir herausgefunden, dass die Klasse s-result-item alle Details über das Produkt enthält, wir aber nur den Preis benötigen.

Innerhalb des Elements befindet sich ein Preis-Container mit der Klasse a-price und der Unterklasse a-offscreen , aus dem wir den Text extrahieren werden, der den Preis darstellt.

WebScrapingAPI gibt die Seite im HTML-Format zurück, so dass wir sie parsen müssen. JSDOM wird den Trick machen.

const {document} = new JSDOM(response.body).windowNach dem Senden der Anfrage und dem Parsen der von WSA erhaltenen Antwort müssen wir das Ergebnis filtern und nur das herausziehen, was für uns wichtig ist. Aus dem vorherigen Schritt wissen wir, dass die Details jedes Produkts in der Klasse s-result-item enthalten sind, also iterieren wir über sie. Innerhalb jedes Elements prüfen wir, ob die Preis-Containerklasse a-price vorhanden ist, und wenn ja, extrahieren wir den Preis aus dem Element a-offscreen darin und schieben ihn in ein Array.

Herauszufinden, welches das teuerste Produkt ist, sollte jetzt ein Kinderspiel sein. Iterieren Sie einfach durch das Array und vergleichen Sie die Preise untereinander.

Der endgültige Code sollte mit einer asynchronen Funktion wie folgt aussehen:

const {JSDOM} = require("jsdom");

const got = require("got");

(async () => {

const params = {

api_key: "XXX",

url: "https://www.amazon.com/s?k=graphic+card"

}

const response = await got('https://api.webscrapingapi.com/v1', {searchParams: params})

const {document} = new JSDOM(response.body).window

const products = document.querySelectorAll('.s-result-item')

const prices = []

products.forEach(el => {

if (el) {

const priceContainer = el.querySelector('.a-price')

if (priceContainer) prices.push(priceContainer.querySelector('.a-offscreen').innerHTML)

}

})

let most_expensive = 0

prices.forEach((price) => {

if(most_expensive < parseFloat(price.substring(1)))

most_expensive = parseFloat(price.substring(1))

})

console.log("The most expensive item is: ", most_expensive)

})();Abschließende Überlegungen

Wir hoffen, dass dieser Artikel Ihnen gezeigt hat, wie nützlich ein vorgefertigtes Web-Scraping-Tool sein kann und wie einfach es ist, es in Ihrem Projekt zu verwenden. Es beseitigt die Hindernisse, die Websites darstellen, hilft Ihnen beim heimlichen Scrapen des Internets und kann Ihnen viel Zeit sparen.

Warum probieren Sie WebScrapingAPI nicht einmal aus? Sehen Sie selbst, wie nützlich es ist, falls Sie es noch nicht getan haben. Das Anlegen eines Kontos ist kostenlos und 1000 API-Aufrufe können Ihnen helfen, Ihr Web-Scraping-Abenteuer zu beginnen.

Fangen Sie jetzt an!

Nachrichten und Aktualisierungen

Bleiben Sie auf dem Laufenden mit den neuesten Web Scraping-Anleitungen und Nachrichten, indem Sie unseren Newsletter abonnieren.

Der Schutz Ihrer Daten liegt uns am Herzen. Lesen Sie unsere Datenschutzrichtlinie.

Ähnliche Artikel

Entdecken Sie die Komplexität des Scrapens von Amazon-Produktdaten mit unserem ausführlichen Leitfaden. Von Best Practices und Tools wie der Amazon Scraper API bis hin zu rechtlichen Aspekten erfahren Sie, wie Sie Herausforderungen meistern, CAPTCHAs umgehen und effizient wertvolle Erkenntnisse gewinnen.

Erfahren Sie, welcher Browser am besten geeignet ist, um Cloudflare-Erkennungssysteme beim Web-Scraping mit Selenium zu umgehen.

Erfahren Sie, wie Sie mit Hilfe von Datenparsing, HTML-Parsing-Bibliotheken und schema.org-Metadaten effizient Daten für Web-Scraping und Datenanalysen extrahieren und organisieren können.