Rotierende Proxys: Alles, was Sie wissen müssen

Raluca Penciuc am 08. Januar 2023

Als Sie anfingen, die Grundlagen des Web-Scraping zu erlernen, hatten Sie da einen "Oh verdammt, dafür brauche ich Proxys" Moment? Nun, bereiten Sie sich darauf vor, diese Art von Offenbarung noch einmal zu erleben, denn rotierende Proxys sind die nächste Stufe der Web-Scraping-Funktionalität.

Sie glauben mir nicht? Schauen wir uns die Vorteile an, die Proxys bringen, wenn Sie sie nicht rotieren, und dann die zusätzlichen Vorteile, die Sie durch Rotation erhalten. Hier ist, was nicht rotierende IPs bringen:

- Sie können das Scraping einer Seite/Website wiederholen, nachdem die erste IP gesperrt wurde.

- Sie können die Adresse manuell wechseln, um Websites zu umgehen, die Inhalte durch Geolokalisierung einschränken.

- Sie geben Ihren tatsächlichen Standort nicht preis.

- Durch Hinzufügen einer Anfrageverzögerung können Sie Daten von Websites mit Anti-Scraping-Gegenmaßnahmen extrahieren.

Das sind sicherlich gute Voraussetzungen, aber mal sehen, was passiert, wenn man noch einen draufsetzt (Wortspiel beabsichtigt):

- Der Scraper sendet so lange Anfragen, bis er die gewünschten Informationen erhalten hat.

- Sie können von jedem Land aus, in dem Sie einen Proxy haben, problemlos auf geografisch eingeschränkte Inhalte zugreifen.

- Websites wissen nicht einmal, dass sie von Bots besucht werden.

- Sie können Daten von jeder beliebigen Website abrufen, ohne dass die Anfragen verlangsamt werden müssen.

Das ist nur ein kurzer Überblick über die Unterschiede, aber es ist ziemlich beeindruckend, oder? Lassen Sie uns also eintauchen und erfahren, wie diese Vorteile zustande kommen!

Was sind rotierende Proxys?

Unter rotierenden Proxys verstehen wir den Prozess des automatischen Wechsels von einer IP zu einer anderen bei jeder gesendeten Anfrage. Theoretisch kann dies auch manuell erfolgen, aber das würde bedeuten, dass Sie eine Liste von URLs für das Scraping nicht in eine Warteschlange stellen könnten. Stattdessen müssten Sie einen Proxy zuweisen, eine Anfrage senden, einen anderen Proxy zuweisen, eine weitere Anfrage senden und so weiter. Ich hoffe, Sie verstehen, wie ineffizient das wäre.

Für die automatische Proxy-Rotation benötigen Sie einen neuen Mittelsmann, einen Proxy für Ihren Proxy, wenn Sie so wollen. Dieser neue Mittelsmann ist ein Server, der Zugriff auf Ihren gesamten Proxy-Pool hat. Sie müssen also nicht mehr die IP-Liste durchsuchen, sondern der Server übernimmt diese Aufgabe für Sie. Alles, was Sie tun müssen, ist, ihm den Befehl zu geben.

Hier ist ein Überblick über den Scraping-Prozess mit einem Programm, das Proxys rotiert:

- Der Benutzer sendet eine Anfrage an den Proxy-Management-Server.

- Der Server wählt einen Proxy nach dem Zufallsprinzip aus (sofern nicht anders angegeben) und sendet die Anfrage an ihn.

- Der Proxy sendet dann die Anfrage an das endgültige Ziel, die Webseite mit den zu extrahierenden Daten.

- Die Antwort erfolgt auf demselben Weg zurück zum Nutzer.

Diese vier Schritte werden wiederholt, bis der Nutzer alle gewünschten Informationen hat. Jede Anfrage durchläuft einen neuen Proxy, der die Aktionen vieler verschiedener Nutzer simuliert, die sich mit einer Website verbinden.

Im Grunde genommen erfordern rotierende Proxys also keine zusätzliche Arbeit für Sie. Das ist das Schöne daran. Es ist mehr Automatisierung für ein Tool, das bereits dazu gedacht ist, tonnenweise Informationen zu sammeln, ohne dass der Nutzer sich anstrengen muss.

Für die IP-Rotation benötigen Sie natürlich in erster Linie einen Proxy-Pool. Da jedoch nicht alle Proxys gleich sind, müssen Sie auch die richtigen IPs sammeln. Hier sind die beiden führenden Anbieter:

Rechenzentrum vs. Wohngebäude

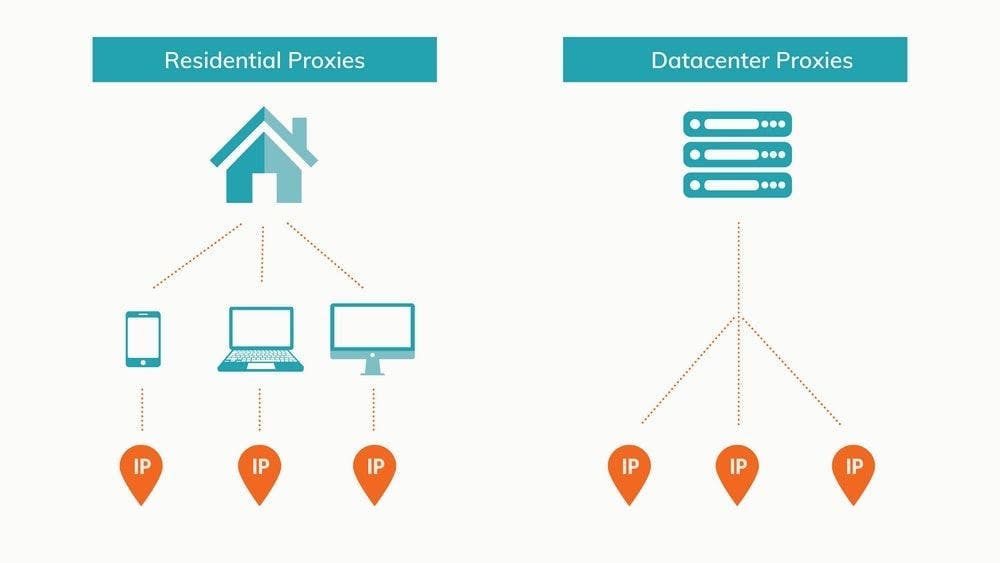

Es gibt mehrere Möglichkeiten, Proxys zu klassifizieren. Sie können nach Anonymität, Zugang oder Herkunft unterschieden werden. Der letztgenannte Faktor ist für Web-Scraping-Projekte am wichtigsten. In diesem Sinne sind Proxys im Allgemeinen entweder Rechenzentren oder Wohngebiete. Schauen wir uns beide an.

Rotierende Rechenzentrums-Proxys

Rechenzentren werden so genannt, weil sie über eine unübertroffene Kapazität verfügen, Informationen online zu speichern und weiterzugeben. Der Begriff "in der Cloud gespeichert" ist nur eine kürzere Version von "in einem Rechenzentrum gespeichert, und Sie können darauf zugreifen, solange Sie Internet haben". Die kürzere Version lässt sich viel besser auf der Zunge zergehen.

Rechenzentren sind im Wesentlichen riesige Ansammlungen von miteinander verbundenen Servern mit einer kolossalen kombinierten Speicherkapazität und der Infrastruktur, um sie am Laufen zu halten. Wie Sie vielleicht schon erraten haben, werden Rechenzentrums-Proxys in diesen Strukturen gehostet. Um Proxys zu erhalten, müssen Sie einen virtuellen Server erstellen, ein Betriebssystem darauf installieren und dann spezielle Software installieren, um IPs als Proxys einzurichten.

Der Schlüssel zu effizienten Rechenzentrums-Proxys liegt darin, die richtige Balance zwischen Servern und IPs zu finden. Ein Server kann mehrere IPs enthalten, aber jede einzelne verursacht mehr Aufwand. Irgendwann ist die Rentabilität des Servers nicht mehr gegeben und man muss einen neuen Server einrichten. Das Jonglieren mit Servern und IPs ist eine Menge Arbeit, so dass die meisten Entwickler es vorziehen, diese Proxys einfach zu mieten oder von spezialisierten Unternehmen zu kaufen.

Die IPs sind nicht mit einem Internetdienstanbieter verbunden. Stattdessen haben Sie es mit den Eigentümern der Rechenzentren oder einem Dritten zu tun, der Speicherplatz nutzt, um Proxys einzurichten und sie an Kunden zu verteilen.

Sie sind eine beliebte Wahl für Web-Scraper, weil:

- Sie sind im Vergleich zu IPs für Privatkunden kostengünstig, da sie massenhaft eingerichtet werden;

- Ihre überragende Geschwindigkeit bedeutet, dass Sie mehr Daten in kürzerer Zeit erfassen können;

- Dank der soliden Infrastruktur der Rechenzentren sind sie sehr zuverlässig;

- Es ist einfach, in großen Mengen von derselben Serverfarm zu kaufen oder zu mieten.

Natürlich hat alles seine Schattenseiten. Für Rechenzentrums-Proxys sind das:

- Ihre IPs sind für aufmerksame Websites leichter zu erkennen;

- Alle Proxys aus demselben Rechenzentrum haben eine gemeinsame Subnetz-Kennung, was sie anfälliger für pauschale Sperren macht.

- Es ist schwieriger, einen Proxy-Pool mit IPs aus jedem Land aufzubauen, da es nur wenige Rechenzentren gibt.

Durch die Verwendung rotierender Proxys für Rechenzentren können Sie erfolgreich auf die meisten Websites zugreifen und diese scrapen. Da jede neue Anfrage von einer anderen IP-Adresse kommt, ist es relativ schwierig, den Scraper zu verfolgen und zu blockieren.

Bei fortgeschrittenen und beliebten Websites sieht es anders aus. Amazon, Google und andere große Namen sind täglich mit Scrapern und anderen Bots konfrontiert. Daher ist es viel wahrscheinlicher, dass dies bemerkt wird. Außerdem besteht bei Proxys für Rechenzentren immer die Gefahr, dass sie bereits gesperrt sind, da sich alle IPs desselben Rechenzentrums ein Subnetz teilen.

Es kommt vor allem darauf an, wen Sie als Ihren Proxy-Dienstanbieter wählen und wie er seine IPs verwaltet. WebScrapingAPI-Rechenzentrums-Proxys zum Beispiel sind privat und garantieren wenig bis gar kein Blacklisting.

Rotierende Wohnsitzvollmachten

Während Rechenzentren die neue High-Tech-Alternative sind, sind private IPs die bewährte Option. Bei privaten IPs handelt es sich um echte Geräte, die über einen ISP mit dem Internet verbunden sind. Diese Proxys sind praktisch nicht von normalen Nutzern zu unterscheiden, weil sie in gewissem Sinne genau das sind.

Um einen Proxy-Pool für ein Rechenzentrum einzurichten, braucht man etwas CS-Wissen, Geld und die richtige Software. Andererseits ist das Sammeln von IPs von Privatpersonen viel komplizierter. Zunächst müssen Sie die Leute davon überzeugen, dass sie Ihnen erlauben, eine spezielle Software auf ihrem Gerät zu installieren, die Ihnen den Zugriff aus der Ferne ermöglicht. Dann müssten sie die Geräte immer eingeschaltet lassen. Andernfalls wäre der Proxy manchmal unbrauchbar.

Aufgrund der Unannehmlichkeiten und des erforderlichen Maßes an Vertrauen ist es für Entwickler wesentlich einfacher, Wohn-Proxys von speziellen Dienstleistern zu mieten.

Im Vergleich zu Proxys für Rechenzentren haben private IPs einige entscheidende Vorteile:

- Die IP-Adressen von Privatpersonen werden von Internet-Diensteanbietern gesichert und sehen beim Surfen im Internet wie normale Besucher aus, so dass der Scraper schwerer zu entdecken ist;

- Jede IP-Adresse ist eindeutig, d. h. selbst wenn ein Proxy identifiziert und blockiert wird, sind alle anderen weiterhin nutzbar;

- Es ist einfacher, einen Proxy-Pool von einer Vielzahl von Standorten aus vorzubereiten, was einen leichteren Zugang zu geografisch eingeschränkten Inhalten gewährleistet.

Trotz dieser beträchtlichen Vorteile, die Wohn-Proxys zu den Besten der Besten in Bezug auf ihre Wirksamkeit machen, haben sie auch einige Nachteile:

- Sie sind im Allgemeinen mit höheren Kosten verbunden;

- Aufgrund des Standorts und der Internetverbindung des Geräts variiert die Abfragegeschwindigkeit von IP zu IP und ist in der Regel langsamer als bei Proxys in Rechenzentren;

- Sie müssen einen Proxy-Anbieter sorgfältig auswählen und darauf achten, dass er eine gute Anzahl von IPs anbietet und Proxys in den Ländern hat, die Sie für Ihr Projekt benötigen.

Wohnsitz-Proxys in Kombination mit einem IP-Rotationssystem und einem Skript, das die Header von Anfragen (insbesondere den User-Agent) zyklisch überprüft, bieten den besten Schutz. Damit kann Ihr Web Scraper Daten sammeln, ohne auf Hindernisse wie IP-Sperren oder CAPTCHAs zu stoßen.

Aufgrund ihrer Authentizität werden Wohn-Proxys häufig für das Scraping komplexerer Websites wie Suchmaschinen, große E-Commerce-Websites oder Social-Media-Plattformen verwendet. Wenn Sie sich jedoch auf diesen Websites anmelden, sollten Sie die Proxy-Rotation ausschalten, damit alle Anfragen von derselben IP-Adresse kommen. Andernfalls sieht es so aus, als würde ein und derselbe Benutzer innerhalb weniger Sekunden Anfragen aus der ganzen Welt senden, was beweist, dass es sich um einen Bot handelt.

Warum Sie rotierende Proxys für Web Scraping verwenden sollten

Einige Websites sind ein beliebtes Ziel für Web-Scraper. Ich denke dabei an Google, Amazon und Facebook. Diese Plattformen rechnen mit Bots und setzen daher Methoden ein, um sie zu verlangsamen und zu stoppen. Mit der zunehmenden Popularität von Web-Scrapern werden diese Gegenmaßnahmen von immer mehr Websites eingesetzt.

In diesem Zusammenhang wird es immer wichtiger, dass Sie Ihre IPs rotieren lassen. Andernfalls laufen Sie Gefahr, ständig mit IP-Sperren und Captchas konfrontiert zu werden, und Ihr Proxy-Pool wird langsam ineffektiv.

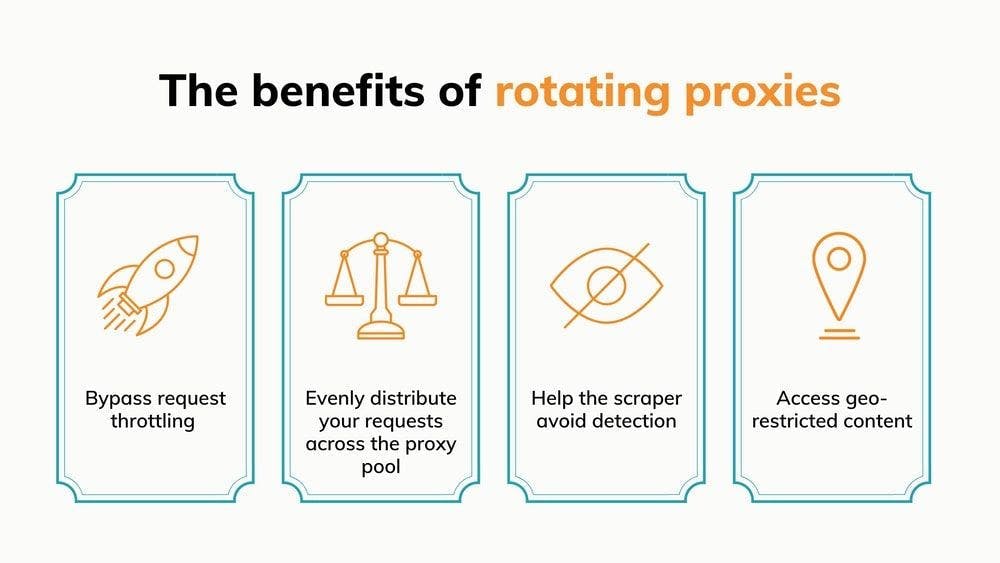

Umgehung der Anforderungsdrosselung

Bei der Anforderungsdrosselung handelt es sich um eine Technik, mit der Websites die Geschwindigkeit verringern, mit der Bots navigieren können. Einfach ausgedrückt, wird damit die Anzahl der Anfragen begrenzt, die ein Besucher innerhalb einer bestimmten Zeitspanne stellen kann.

Sobald das Limit erreicht ist, wird der Bot auf eine CAPTCHA-Seite umgeleitet. Wenn Ihr Web-Scraping-Tool keine CAPTCHA-Lösungsfunktionen hat oder diese nicht funktionieren, kann der IP das Scraping auf dieser Website nicht fortsetzen.

Das Wichtigste dabei ist, dass Websites die Anzahl der von jeder IP-Adresse gesendeten Anfragen überwachen. Wenn Ihre Anfragen von mehreren Adressen gesendet werden, wird die Last zwischen ihnen aufgeteilt. Hier ist ein Beispiel:

Wenn eine Website so eingerichtet ist, dass nach 10 Anfragen die 11. ein CAPTCHA auslöst, bedeutet das, dass Sie 10 Seiten scrapen können, bevor Sie anhalten und die IP manuell ändern müssen. Wenn Sie Preisinformationen sammeln wollen, kann das ein Tropfen auf den heißen Stein sein, verglichen mit der Gesamtzahl der Seiten, die Sie scrapen wollen.

Wenn Sie Ihre Proxys rotieren lassen, müssen Sie nicht mehr manuell eingreifen. Sie können die zehnfache Anzahl an Proxys abrufen, die Sie haben. Die einzige Grenze ist dann die Größe des Proxy-Pools, wobei jede IP ihr volles Potenzial ausschöpft.

Das Beste daran ist, dass die Anforderungsdrosselung die Anzahl der Besuche innerhalb eines bestimmten Zeitraums begrenzt. Bei einem ausreichend großen Proxy-Pool läuft der Timer für die bereits genutzten Proxys ab, bevor Sie sie erneut aufrufen müssen, wodurch Sie praktisch unbegrenzte Scraping-Möglichkeiten erhalten.

Gleichmäßige Verteilung von Anfragen über den Proxy-Pool

Nach der gleichen Logik wie beim vorherigen Punkt sorgt die Proxy-Rotation dafür, dass Sie dieselben IPs nicht übermäßig nutzen, während andere untätig bleiben. Ganz einfach ausgedrückt: Sie nutzen Ihre Ressourcen so effizient wie möglich. Das Ergebnis: Sie können die gleichen Ergebnisse mit einer geringeren Anzahl von IPs erzielen.

Ohne Proxy-Rotation verwenden Sie dieselbe IP-Adresse, bis sie gesperrt wird, während alle anderen Proxys Staub ansetzen. Wenn einer nicht mehr funktioniert, geht man zum nächsten über. Diese Methode lässt Proxys wie eine endliche Ressource erscheinen, die zum Sammeln von Daten aufgebraucht wird. Das ist aber nicht nötig.

Bei einer guten Verteilung der Standorte und der Rechenzentren/Wohnorte kann ein guter Proxy-Pool unbegrenzt weiterlaufen, wenn Sie die IPs rotieren. Sie müssen nur darauf achten, dass kein Proxy herausragt und Gefahr läuft, blockiert zu werden.

In gleicher Weise kann die Proxy-Rotation den Scraping-Prozess exponentiell beschleunigen. Der Schlüssel dazu sind gleichzeitige Anfragen. Die meisten Web-Scraping-APIs können mehrere Anfragen gleichzeitig senden, wobei die Anzahl von dem von Ihnen gewählten Paket abhängt.

Wenn Sie 50 Anfragen zur gleichen Zeit an dieselbe Website senden, ist das ein Grund, die Alarmglocken zu läuten. Es ist sogar so weit vom normalen Nutzerverhalten entfernt, dass Sie höchstwahrscheinlich sofort gesperrt werden. Sie können sich wahrscheinlich denken, worauf das hinausläuft. Das Rotieren Ihrer Proxys ist ein Muss, denn so können Sie den Scraper bis an seine Grenzen bringen, ohne dass er blockiert wird.

Helfen Sie dem Abstreifer, nicht entdeckt zu werden

Einer der wichtigsten Vorteile der rotierenden Proxys ist die Anonymität, die sie gewährleisten. Lassen Sie uns das näher ausführen!

Websites sind nicht gerade erpicht darauf, von Bots besucht zu werden. Vielleicht wollen sie verhindern, dass Sie Daten sammeln, oder sie wollen einfach nur sicherstellen, dass kein bösartiges Programm versucht, ihre Server zum Absturz zu bringen. Aus diesem Grund setzen sie verschiedene Gegenmaßnahmen ein, um Bots zu erkennen und zu blockieren. Da Web Scraper schneller im Internet surfen als normale Nutzer, fallen sie auf. Denken Sie an das Beispiel mit den 50 gleichzeitigen Anfragen zurück. Laut ContentSquare's 2020 Digital Experience Benchmark verbringt der durchschnittliche Nutzer 62 Sekunden auf einer einzigen Seite. Der Unterschied im Verhalten ist deutlich zu erkennen.

Mit rotierenden Proxys wechseln Sie ständig zwischen IPs und vermeiden es, zahlreiche Anfragen von einer einzigen Adresse zu senden. Das Ergebnis: Die Website sieht den von Ihnen generierten Traffic als eine Gruppe separater Besucher, zwischen denen keine Verbindung besteht.

Zugriff auf geografisch eingeschränkte Inhalte

Ein Proxy-Rotator sollte nicht nur IPs nach dem Zufallsprinzip wechseln. Sicher, manchmal reicht das aus, aber eine fortgeschrittene Funktion, nach der Sie suchen sollten, ist die Option, Proxys aus einer bestimmten Region zu rotieren.

Diese Funktion ist von entscheidender Bedeutung, wenn Sie versuchen, Informationen zu sammeln, die sich auf eine einzige Region beziehen. Je nach der geografischen Herkunft einer Anfrage können einige Websites:

- Anzeige von Daten, die für die Herkunft der IP spezifisch sind

- Zugriff einschränken, weil die Anfrage aus einem gesperrten Land kommt

Durch die Rotation eines vielfältigen Vertretungspools können Sie also sowohl die Nachteile abmildern als auch die Vorteile nutzen. Übertragen auf die vorherigen Punkte bedeutet dies:

- Verschaffen Sie sich einen besseren Überblick über ausländische Märkte, indem Sie sich länderspezifische Daten beschaffen;

- Extrahieren Sie Informationen, die andernfalls nicht zugänglich wären, weil die Website für bestimmte Länder gesperrt ist.

Es ist wichtig, wachsam zu sein und zu bemerken, wenn Websites ihren Inhalt je nach Herkunft der Anfrage anpassen. Diese Websites können einen guten Einblick in die Daten eines Landes bieten. Wenn Sie jedoch nicht wissen, dass Sie benutzerdefinierte Informationen erhalten, kann es zu erheblichen Ungenauigkeiten in Ihren Daten kommen.

Wie man rotierende Proxys verwendet

Wie bei Web-Scrapern können Sie einen Proxy-Rotator ganz allein erstellen, verwalten und nutzen. Dazu benötigen Sie Programmierkenntnisse (Python ist ideal, da es viele wertvolle Frameworks und eine aktive Community gibt), einige allgemeine CS-Kenntnisse, eine Liste von Proxys und eine Menge Geduld.

Die einfachste Form wäre ein Skript, das eine Variable mit Ihrer Proxy-Liste erhält und für jede Anfrage zufällige IPs zuweist. Sie könnten z. B. die Funktion random.sample() verwenden, um jedes Mal eine IP nach dem Zufallsprinzip auszuwählen, aber das bedeutet, dass derselbe Proxy möglicherweise mehrmals hintereinander verwendet wird. In diesem Fall könnten Sie dafür sorgen, dass eine IP nach ihrer Verwendung aus der Proxy-Liste gestrichen wird, so dass sie erst wieder verwendet wird, wenn alle anderen Adressen ebenfalls verwendet wurden.

Hier ist ein kurzes Beispiel in Python:

import random

import requests

proxy_pool = ["191.5.0.79:53281", "202.166.202.29:58794", "51.210.106.217:443", "5103.240.161.109:6666"]

URL = 'https://httpbin.org/get'

while len(proxy_pool) >0:

random_proxy_list = random.sample(proxy_pool, k=1)

random_proxy = {

'http': 'http://' + random_proxy_list[0],

}

response = requests.get(URL, proxies=random_proxy)

print(response.json())

proxy_pool.remove(random_proxy_list[0])

Der Code durchläuft den Proxy-Pool nur einmal und das auch nur für eine einzige URL, aber er sollte die Logik gut veranschaulichen. Ich habe die IPs übrigens von https://free-proxy-list.net/ übernommen. Es überrascht nicht, dass sie nicht funktionierten.

Genau das ist das Problem beim Bau eines eigenen Rotators. Sie brauchen immer noch gute dedizierte oder zumindest gemeinsam genutzte IPs. Wenn Sie schon einmal dabei sind, Proxys zu kaufen, können Sie auch nach einer Lösung suchen, die die IPs für Sie rotiert. Auf diese Weise müssen Sie weder zusätzliche Zeit für den Aufbau noch zusätzliches Geld für das Outsourcing aufwenden. Außerdem erhalten Sie mehr Goodies wie:

- Eine schnelle Option, um nur IPs aus einer bestimmten Region zu rotieren;

- Die Möglichkeit, zu wählen, welche Arten von Proxys verwendet werden sollen (Rechenzentrum oder Wohngebäude; regulär oder mobil; usw.)

- Einrichten von statischen IPs für den Fall, dass Sie hinter einem Anmeldebildschirm scannen;

- Automatische Wiederholungsversuche mit neuen IPs, wenn eine Anfrage fehlschlägt.

Nehmen wir WebScrapingAPI als Beispiel dafür, wie einfach es ist, eine Seite mit rotierenden Proxys zu scrapen. Der folgende Code stammt direkt aus der Dokumentation, in der es noch viele weitere Schnipsel dieser Art gibt:

import requests

url = "https://api.webscrapingapi.com/v1"

params = {

"api_key":"XXXXXX",

"url":"https://httpbin.org/get",

"proxy_type":"datacenter",

"country":"us"

}

response = requests.request("GET", url, params=params)

print(response.text)

Dies ist der gesamte Code, den Sie benötigen, um eine URL unter Verwendung von Rechenzentrums-Proxys aus den USA zu scrapen. Beachten Sie, dass es keine Liste der zu wechselnden IPs gibt und auch keinen Parameter dafür. Das liegt daran, dass die API standardmäßig die Proxys wechselt. Wenn Sie dieselbe IP für mehrere Sitzungen verwenden möchten, fügen Sie einfach einen neuen Parameter hinzu:

import requests

url = "https://api.webscrapingapi.com/v1"

params = {

"api_key":"XXXXXX",

"url":"https://httpbin.org/get",

"proxy_type":"datacenter",

"country":"us",

"session":"100"

}

response = requests.request("GET", url, params=params)

print(response.text)

Verwenden Sie einfach dieselbe ganze Zahl für den Parameter "session", um dieselbe statische IP für jede URL zu verwenden.

Die besten Anbieter von rotierenden Proxys

Da Sie nun wissen, wie rotierende Proxys den Web-Scraping-Prozess optimieren können, sollten Sie als Nächstes einen Proxy-Anbieter auswählen, der Ihren Bedürfnissen und Ressourcen entspricht. Ich habe eine Liste meiner Favoriten zusammengestellt, die auf verschiedenen Faktoren basiert: Preise, Proxy-Standorte und die Anzahl der Proxys für Rechenzentren und Privatanwender.

1. WebScrapingAPI

Ich frage Sie: Was ist besser als schnelle, effiziente und kostengünstige Proxys für die Verbindung zu Ihrem Web Scraper zu bekommen?

Die Antwort: eine schnelle, effiziente und erschwingliche Web Scraping API, die alles für Sie erledigt. Ich könnte noch viel mehr über die Datenextraktionsfunktionen von WebScrapingAPI erzählen, aber konzentrieren wir uns erst einmal auf IPs. Der gesamte Proxy-Pool umfasst über 100 Millionen IPs, die über den gesamten Globus verteilt sind.

Anstatt die Bandbreitennutzung zu messen, können Sie ein Paket mit einer bestimmten Anzahl von API-Aufrufen wählen. Jeder API-Aufruf bedeutet eine gescrapte Seite, jede über eine andere IP, da, wie ich bereits erwähnt habe, die Proxy-Rotation standardmäßig aktiviert ist.

Es stehen fünf Pakete zur Auswahl, darunter eine kostenlose Option, bei der Sie jeden Monat 1.000 API-Aufrufe erhalten (neben der kostenlosen Testphase), um sich eine Meinung über das Produkt zu bilden. Der Preis beginnt bei 20 $ für 200.000 API-Aufrufe, und die Tarife werden bei größeren Paketen besser. Für spezielle Anwendungsfälle können wir einen maßgeschneiderten Plan ausarbeiten, der Ihren Anforderungen entspricht.

Wenn Sie Daten über Proxys von einem bestimmten Standort aus extrahieren möchten, haben Sie mehrere Möglichkeiten. Der Proxy-Pool für Rechenzentren ist auf 7 Länder aufgeteilt, während für Privatanwender IPs aus 40 verschiedenen Gebieten ausgewählt werden können. Wenn Ihnen das nicht reicht, können Sie sich für ein benutzerdefiniertes Paket entscheiden, das die Möglichkeit bietet, 195 weitere Standorte in Ihre Liste aufzunehmen.

2. Oxylabs

Oxylabs hat mit der IP-Rotation einen interessanten Ansatz gewählt. Wenn Sie sich für ein Paket entscheiden, müssen Sie normalerweise die IPs selbst rotieren, aber Sie haben auch die Möglichkeit, den Proxy-Rotator als Add-on zu kaufen.

Während einige Anwendungsfälle nicht unbedingt auf rotierende Proxys angewiesen sind, ist dies bei der Datenextraktion unerlässlich. Wenn Sie sich also für Oxylabs-Proxys entscheiden, sollten Sie auch den Rotator kaufen.

Das Unternehmen bietet separate Pakete für Proxys für Privatpersonen und Rechenzentren an. Der Preis für die IP-Nutzung für Privatkunden richtet sich nach der genutzten Bandbreite, wobei der niedrigste Plan bei 300 US-Dollar pro Monat für 20 GB Datenverkehr beginnt. Rechenzentrums-Proxys haben eine unbegrenzte Bandbreite, und die Pakete unterscheiden sich darin, wie viele IPs Sie erhalten. Diese beginnen bei $160 pro Monat, und Sie haben die Wahl zwischen 100 US-amerikanischen IPs oder 60 Nicht-US-IPs.

Insgesamt gibt es über 100 Millionen Proxys für Privatpersonen und 2 Millionen Proxys für Rechenzentren. Es ist also unwahrscheinlich, dass Ihnen die IPs ausgehen.

Der Proxy-Pool ist über ein beeindruckendes Gebiet verteilt - 186 verschiedene Standorte. Obwohl alle diese Länder IPs für Wohngebiete haben, sollten Sie nicht erwarten, dass alle auch Proxys für Rechenzentren haben.

3. Schaltung

Shifter nutzt die hochmoderne Infrastruktur, die hinter den Proxies für Rechenzentren steht, in vollem Umfang. Daher bieten sie neben der gewohnten dedizierten IP-Option auch gemeinsam genutzte Rechenzentrums-Proxys an.

Was uns an Shifters Angebot gefällt, ist die große Anzahl von Paketen, aus denen Sie wählen können. Zum Beispiel beginnt der kleinste Proxy-Plan bei $30 pro Monat für den Zugang zu 10 gemeinsamen Proxys. Am anderen Ende des Spektrums können Sie 1000 gemeinsame Proxys für $2000 erhalten. Kurzum, Sie haben die Wahl.

Dedizierte Rechenzentrums-Proxys sind erwartungsgemäß teurer, wobei das billigste Paket bei $25 für 5 IPs beginnt, zu denen nur Sie Zugang haben.

Wenn Sie an privaten IPs interessiert sind, beginnen die Preise bei 250 $ pro Monat für 10 spezielle Backconnect-Proxys, was bedeutet, dass ein Server die Proxy-Rotation übernimmt, so dass Sie sich nicht darum kümmern müssen.

Ihr Proxy-Pool enthält mehr als 31 Millionen IPs, und die genaue Anzahl können die Nutzer in ihrem Kontrollpanel einsehen.

Geo-Targeting ist für jedes Land der Welt verfügbar, aber es gibt eine Einschränkung - Sie können es nur mit IP-Adressen von Privatpersonen verwenden.

4. SmartProxy

Neben dem beeindruckenden Proxy-Pool bietet SmartProxy eine schöne Auswahl an Tools. Dazu gehören ein Generator für Proxy-Adressen, Add-ons für Chrome und Firefox und ein Programm, das Ihnen hilft, mit mehreren Browsern gleichzeitig im Internet zu surfen.

Aber zurück zu den Proxies. Smartproxy bietet seinen Nutzern Zugang zu über 40 Millionen privaten IPs sowie zu 40k Proxys für Rechenzentren. Darüber hinaus bietet Smartproxy auch einzigartige Proxys für Privatanwender, die für das Scraping von Suchmaschinen entwickelt wurden. Im Gegensatz zu den beiden anderen Optionen, deren Preis von der genutzten Bandbreite abhängt, haben die Suchmaschinen-Proxy-Pakete eine feste Anzahl von Anfragen.

Während die meisten IPs aus den USA, dem Vereinigten Königreich, Kanada, Deutschland, Indien und Japan stammen, gibt es mehr als hundert Standorte mit mindestens 50 IPs.

Preislich gesehen gibt es Pakete ab 50 $ für 100 GB Datenverkehr über Proxys für Rechenzentren oder 75 $ für 5 GB mit Proxys für Privatkunden. Wie Sie erwarten würden, haben umfangreichere Pläne mehr vorteilhafte Angebote.

5. Helle Daten

Bright Data verfügt über einen beeindruckenden Proxy-Pool, der sich aus Proxys für Rechenzentren, Privatanwender und Mobilgeräte zusammensetzt. In Zahlen sieht das folgendermaßen aus:

- Mehr als 700.000 IPs in Rechenzentren

- 72.000.000+ private IPs

- 85.000+ statische private IPs

- 7.500.000+ mobile IPs

Eine große Zahl, das ist sicher. Der Nachteil ist, dass auch die Preise ziemlich hoch sind. Es gibt zwar einige Pakete mit festen Preisen, aber am besten nutzen Sie den Preisrechner, um einen individuellen Plan für sich zu erstellen. Mit diesem Rechner geben Sie an, wie viele IPs Sie wollen und eine maximale Bandbreite pro Monat, und Sie erhalten den genauen Preis.

Zum Thema Geolocation: Bright Data hat IPs in fast jedem Land der Welt. Sie haben eine Seite auf ihrer Website, auf der Sie die Standorte überprüfen können. Wenn Sie bestimmte Arten von Proxys in bestimmten Gebieten benötigen, ist diese Seite sehr hilfreich.

Wie wählt man einen Proxy-Dienstanbieter aus?

Einer der wichtigsten Vorteile von Web Scraping und Proxys im Allgemeinen ist die Fülle der Möglichkeiten.

Da die meisten Menschen oder Unternehmen ein bestimmtes Ziel vor Augen haben, ist es nicht ungewöhnlich, dass sie sich für einen Anbieter entscheiden und dann feststellen, dass er nicht passt. Das ist nicht ideal, aber es kommt vor. Glücklicherweise bieten die meisten Unternehmen eine Probezeit, ein kostenloses Paket oder zumindest eine Geld-zurück-Politik an.

Der beste Rat, den ich Ihnen geben kann, ist, Ihre Möglichkeiten auszuloten, sich umzuschauen, und Sie werden bestimmt etwas finden, das zu Ihnen passt.

Neben Proxys brauchen Sie auch einen Web Scraper, richtig? Nun, unter all den Alternativen sind hier 10 Datenextraktionsprodukte, die Ihre Aufmerksamkeit verdienen.

Wenn Sie keine Zeit haben, hier eine kurze Empfehlung für Sie: Starten Sie die kostenlose Testversion von WebScrapingAPI, und Sie müssen keine anderen Scraper mehr ausprobieren!

Nachrichten und Aktualisierungen

Bleiben Sie auf dem Laufenden mit den neuesten Web Scraping-Anleitungen und Nachrichten, indem Sie unseren Newsletter abonnieren.

Der Schutz Ihrer Daten liegt uns am Herzen. Lesen Sie unsere Datenschutzrichtlinie.

Ähnliche Artikel

Entdecken Sie die Komplexität des Scrapens von Amazon-Produktdaten mit unserem ausführlichen Leitfaden. Von Best Practices und Tools wie der Amazon Scraper API bis hin zu rechtlichen Aspekten erfahren Sie, wie Sie Herausforderungen meistern, CAPTCHAs umgehen und effizient wertvolle Erkenntnisse gewinnen.

Erforschen Sie die transformative Kraft des Web Scraping im Finanzsektor. Von Produktdaten bis zur Stimmungsanalyse bietet dieser Leitfaden Einblicke in die verschiedenen Arten von Webdaten, die für Investitionsentscheidungen zur Verfügung stehen.

Vergleich von Cheerio und Puppeteer für Web Scraping? Funktionen, Vorteile und Unterschiede werden behandelt. Inklusive Tipps. Wählen Sie das beste Tool für Sie.