HTTP-Header 101: Wie man sie für effektives Web-Scraping verwendet

Raluca Penciuc am 03. Februar 2023

Web Scraping ist ein unglaubliches Werkzeug, um wertvolle Informationen aus dem Internet zu extrahieren, aber seien wir ehrlich, es kann ziemlich frustrierend sein, wenn Ihre Scraping-Skripte blockiert werden.

Es ist wie ein Katz- und Mausspiel, bei dem sich die Website-Besitzer immer wieder neue Wege einfallen lassen, um Sie auszusperren. Aber es gibt eine Geheimwaffe in Ihrem Werkzeugkasten, mit der Sie die Oberhand behalten können: HTTP-Header und Cookies.

Diese beiden Elemente spielen eine entscheidende Rolle dabei, wie Ihre Scraping-Skripte mit Websites interagieren, und ihre Beherrschung kann den Unterschied zwischen einem blockierten und einem erfolgreichen Scraping bedeuten.

In diesem Tutorial werden wir die Geheimnisse der HTTP-Header und Cookies lüften und Ihnen zeigen, wie Sie diese nutzen können, um Ihre Scraping-Bemühungen so menschenähnlich wie möglich zu gestalten.

Sie erfahren, welche Header beim Web-Scraping am häufigsten verwendet werden, wie man Header und Cookies von einem echten Browser abgreift und wie man benutzerdefinierte Header verwendet, um Sicherheitsmaßnahmen zu umgehen. Also, lassen Sie uns eintauchen und sehen, wie wir unser Scraping-Spiel auf die nächste Stufe bringen können!

Verstehen von HTTP-Headern

HTTP-Header sind Schlüssel-Wert-Paare, die Sie als Teil einer HTTP-Anfrage oder -Antwort senden. Sie werden durch einen Doppelpunkt und ein Leerzeichen getrennt und ihre Namen (Schlüssel) unterscheiden nicht zwischen Groß- und Kleinschreibung.

Sie können HTTP-Header in verschiedene Kategorien einteilen, je nach ihrer Funktion und der Richtung, in die Sie sie senden. Zu diesen Kategorien gehören:

- allgemeine Kopfzeilen: gelten sowohl für Anfrage- als auch für Antwortnachrichten

- Anfrage-Header: enthalten weitere Informationen über die Ressource, die Sie abrufen möchten, oder über den Client, der die Anfrage stellt

- Antwort-Header: enthalten zusätzliche Informationen über die Antwort, wie z. B. den Standort oder den Server, der sie bereitstellt

- Entity-Header: enthalten Informationen über den Körper der Ressource, wie z. B. ihre Größe oder den MIME-Typ

- Erweiterungs-Header: für die Abwärtskompatibilität verwendet

HTTP-Header liefern eine Vielzahl von Informationen, darunter die Art der Anfrage, den verwendeten Browser und alle zusätzlichen Informationen, die der Server zur Bearbeitung der Anfrage benötigt.

Sie ermöglichen auch die Angabe von Authentifizierungs- und Sicherheitsinformationen, die Steuerung der Zwischenspeicherung und Komprimierung sowie die Angabe der Sprache und des Zeichensatzes der Anfrage.

Hier sind zum Beispiel die Header, die Chrome beim Zugriff auf youtube.com sendet:

:authority: www.youtube.com

:method: GET

:path: /

:scheme: https

accept: text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.9

accept-encoding: gzip, deflate, br

accept-language: en-US,en;q=0.9

cache-control: no-cache

pragma: no-cache

referer: https://www.google.com/

sec-ch-ua: "Not_A Brand";v="99", "Google Chrome";v="109", "Chromium";v="109"

sec-ch-ua-arch: "x86"

sec-ch-ua-bitness: "64"

sec-ch-ua-full-version: "109.0.5414.75"

sec-ch-ua-full-version-list: "Not_A Brand";v="99.0.0.0", "Google Chrome";v="109.0.5414.75", "Chromium";v="109.0.5414.75"

sec-ch-ua-mobile: ?0

sec-ch-ua-model: ""

sec-ch-ua-platform: "Windows"

sec-ch-ua-platform-version: "15.0.0"

sec-ch-ua-wow64: ?0

sec-fetch-dest: document

sec-fetch-mode: navigate

sec-fetch-site: same-origin

sec-fetch-user: ?1

upgrade-insecure-requests: 1

user-agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/109.0.0.0 Safari/537.36

x-client-data: CIm2yQEIorbJAQjEtskBCKmdygEI5PDKAQiWocsBCKr2zAEI7oLNAQibiM0BCLqIzQEI9YjNAQ==

Decoded:

message ClientVariations {

// Active client experiment variation IDs.

repeated int32 variation_id = [3300105, 3300130, 3300164, 3313321, 3324004, 3330198, 3357482, 3359086, 3359771, 3359802, 3359861];

}

Verstehen von Web-Cookies

Web-Cookies oder HTTP-Cookies sind kleine Textdateien, die eine Website im Browser des Benutzers speichert. Danach werden die Cookies jedes Mal, wenn der Nutzer eine neue Anfrage an die Website sendet, automatisch einbezogen.

Sie sind eindeutig identifizierbar, und Sie finden sie als:

- Sitzungscookies: Sie sind temporär und verfallen, wenn der Nutzer den Browser schließt.

- dauerhafte Cookies: Sie haben ein bestimmtes Verfallsdatum und verbleiben auf dem Gerät des Nutzers, bis sie ablaufen oder vom Nutzer gelöscht werden.

Websites verwenden Web-Cookies, um die Erfahrung des Nutzers zu personalisieren. Dazu kann es gehören, dass sie sich an ihre Anmeldeinformationen erinnern und den Inhalt des Warenkorbs speichern, um zu verstehen, wie die Nutzer mit der Website interagieren, und um gezielte Werbung zu liefern.

Auch hier können wir am Beispiel von youtube.com sehen, was Cookies speichern:

Cookie: CONSENT=YES+srp.gws-20210816-0-RC3.ro+FX+801; __Secure-3PAPISID=jG4abs_wYhyzcDG5/A2yfWlePlb1U9fglf; VISITOR_INFO1_LIVE=pJuwGIYiJlE; __Secure-3PSIDCC=AEf-XMRV_MjLL0AWdGWngxFHvNUF3OIpk3_jdeUwRiZ76WZ3XsSY0Vlsl1jM9n7FLprKTqFzvw; __Secure-3PSID=RAi8PYLbf3qLvF1oEav9BnHK_eOXwimNM-0xwTQPj1-QVG1Xwpz17T4d-EGzT6sVps1PjQ.YSC=4M3JgZEwyiA; GPS=1; DEVICE_INFO=ChxOekU1TURJMk1URTBOemd5TWpJeU5qVTJOdz09EOvgo54GGOvgo54G; PREF=tz=Europa.Bukarest&f6=40000000&f4=4000000; CONSISTENCY=ACHmjUr7DnoYSMf5OL-vaunKYfoLGz1lWYRUZRepFyIBDRpp_jrEa85E4wgRJLJ2j15l688hk9IVQu7fIjYXo7sdsZamArxVHTMuChgHd22PkX_mbfifnMjyp4OX2swyQJRS-8PE6cOCt_6129fGyBs; amp_adc4c4=Ncu7lbhgeiAAYqecSmyAsS.MXVDWTJjd3BXdmRkQ3J0YUpuTkx3OE5JcXVKMw==..1gn4emd4v.1gn4en556.0.4.4

Die Bedeutung von Kopfzeilen und Cookies beim Web Scraping

Beim Web-Scraping können Sie Kopfzeilen und Cookies verwenden, um Sicherheitsmaßnahmen zu umgehen und auf eingeschränkte Inhalte zuzugreifen sowie Informationen bereitzustellen, mit deren Hilfe Ihr Scraping-Skript als legitimer Browser identifiziert werden kann.

Indem Sie zum Beispiel den richtigen User-Agent-Header angeben (mehr dazu im folgenden Abschnitt), können Sie Ihr Skript so aussehen lassen, als wäre es ein Chrome-Browser, was Ihnen helfen kann, die Erkennung durch die Website zu vermeiden.

Durch das Speichern und Senden von Cookies kann Ihr Scraper auch auf Inhalte zugreifen, die nur angemeldeten Benutzern zur Verfügung stehen. Da die Website Cookies verwendet, um gezielte Werbung zu schalten, können Sie sie auch nutzen, um genauere Daten zu gewinnen und die Website besser zu verstehen.

Neben dem Spiel mit HTTP-Headern und Cookies sollten Sie auch einige nützliche Best Practices für Web Scraping beachten , die in diesem Leitfaden aufgeführt sind.

Übliche Kopfzeilen beim Web Scraping

Es gibt viele verschiedene Kopfzeilen, die beim Web Scraping verwendet werden können, aber einige der am häufigsten verwendeten sind:

Benutzer-Agent

Sie wird verwendet, um den Browser und das Betriebssystem des anfragenden Kunden zu identifizieren. Diese Informationen werden von den Servern verwendet, um festzustellen, welchen Browser und welches Betriebssystem der Kunde verwendet, damit die entsprechenden Inhalte und Funktionen bereitgestellt werden können.

Die User-Agent-Zeichenfolge enthält Informationen wie den Browsernamen, die Version und die Plattform. Eine User-Agent-Zeichenkette für Google Chrome unter Windows könnte zum Beispiel so aussehen:

Benutzer-Agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, wie Gecko) Chrome/109.0.0.0 Safari/537.36

Beim Web-Scraping können Sie durch die Angabe eines User-Agents, der zu einem gängigen Webbrowser gehört, Ihr Skript als einen Browser erscheinen lassen, der von legitimen Nutzern häufig verwendet wird, so dass es weniger wahrscheinlich blockiert wird.

Akzeptieren

Er wird verwendet, um die Arten von Inhalten anzugeben, die der Browser als Antwort auf eine HTTP-Anfrage akzeptiert, z. B. Text, Bilder, Audio oder Video. Ein Accept-Header kann wie folgt aussehen:

Akzeptieren:

text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,/;q=0.8

Beim Web Scraping können Sie durch die Angabe des richtigen Accept-Headers sicherstellen, dass Ihr Skript die richtigen Daten erhält. Wenn Sie zum Beispiel eine HTML-Seite scrapen wollen, können Sie als Accept-Header text/html angeben.

Einige Websites können diese Kopfzeile jedoch verwenden, um Scraper aufzuspüren, daher ist es wichtig, sie vorsichtig und nur bei Bedarf zu verwenden.

Accept-Language

Diese Kopfzeile gibt die bevorzugte Sprache des Inhalts an, die der Browser als Antwort auf eine HTTP-Anfrage akzeptieren will. Der Accept-Language-Header wird von Servern verwendet, um zu bestimmen, welche Sprache an den Client gesendet werden soll.

Ein Browser, der eine HTML-Seite in englischer Sprache anfordert, könnte einen Accept-Language-Header senden, der wie folgt aussieht:

Accept-Language: en-US,en;q=0.9

Keks

Websites verwenden diese Kopfzeile, um nach einer Anfrage Cookies an einen Client zu senden. Ein Cookie-Header kann wie folgt aussehen:

Cookie: session_id=1234567890; user_id=johndoe

Beim Web Scraping können Sie diese Kopfzeile verwenden, um Sitzungscookies zu übergeben und auf Inhalte zuzugreifen, die nur angemeldeten Benutzern zur Verfügung stehen. Ein weiterer Anwendungsfall wäre die Verwendung dauerhafter Cookies, um personalisierte Ergebnisse zu erhalten.

Referent

Diese Kopfzeile gibt die URL der vorherigen Webseite an, von der aus ein Link zur aktuellen Seite verfolgt wurde. Er wird von Servern verwendet, um den Ursprung der Anfrage zu verfolgen und den Kontext der Anfrage zu verstehen.

Wenn ein Benutzer beispielsweise auf einen Link von einer Webseite zu einer anderen Webseite klickt, sendet der Browser eine Anfrage an die zweite Webseite mit der URL der ersten Webseite im Referer-Header. Die Anfrage an die zweite Webseite würde also einen Referer-Header haben, der wie folgt aussieht:

Referent: https://www.example.com/

Beim Web Scraping können Sie den Referer-Header verwenden, um auf Websites zuzugreifen, die keine direkten Anfragen zulassen.

Abrufen von Kopfzeilen und Cookies von einem echten Browser

Aber genug der Theorie. Schauen wir uns an, wie Sie HTTP-Header und Web-Cookies, die an eine Website gesendet werden, extrahieren können.

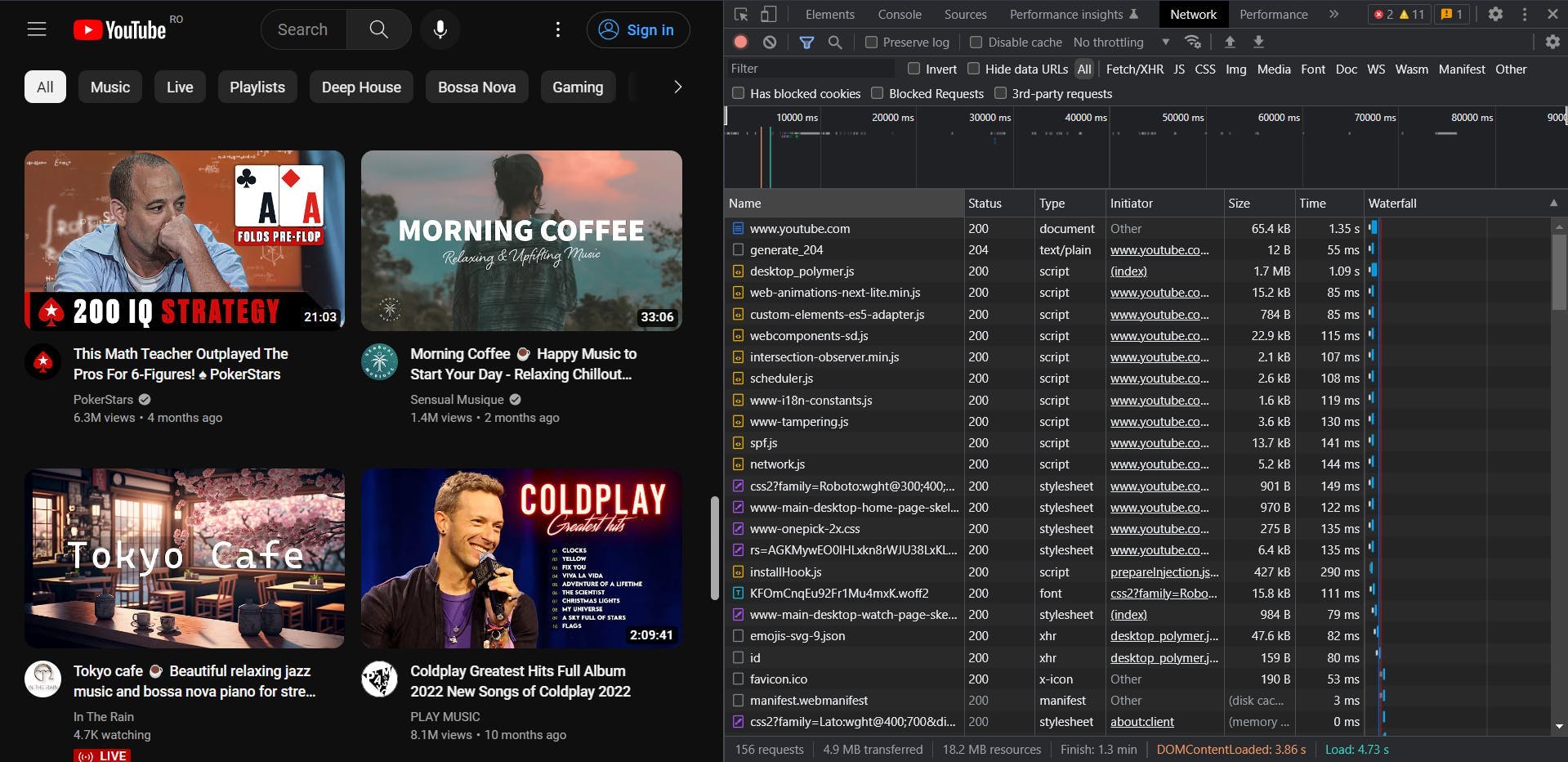

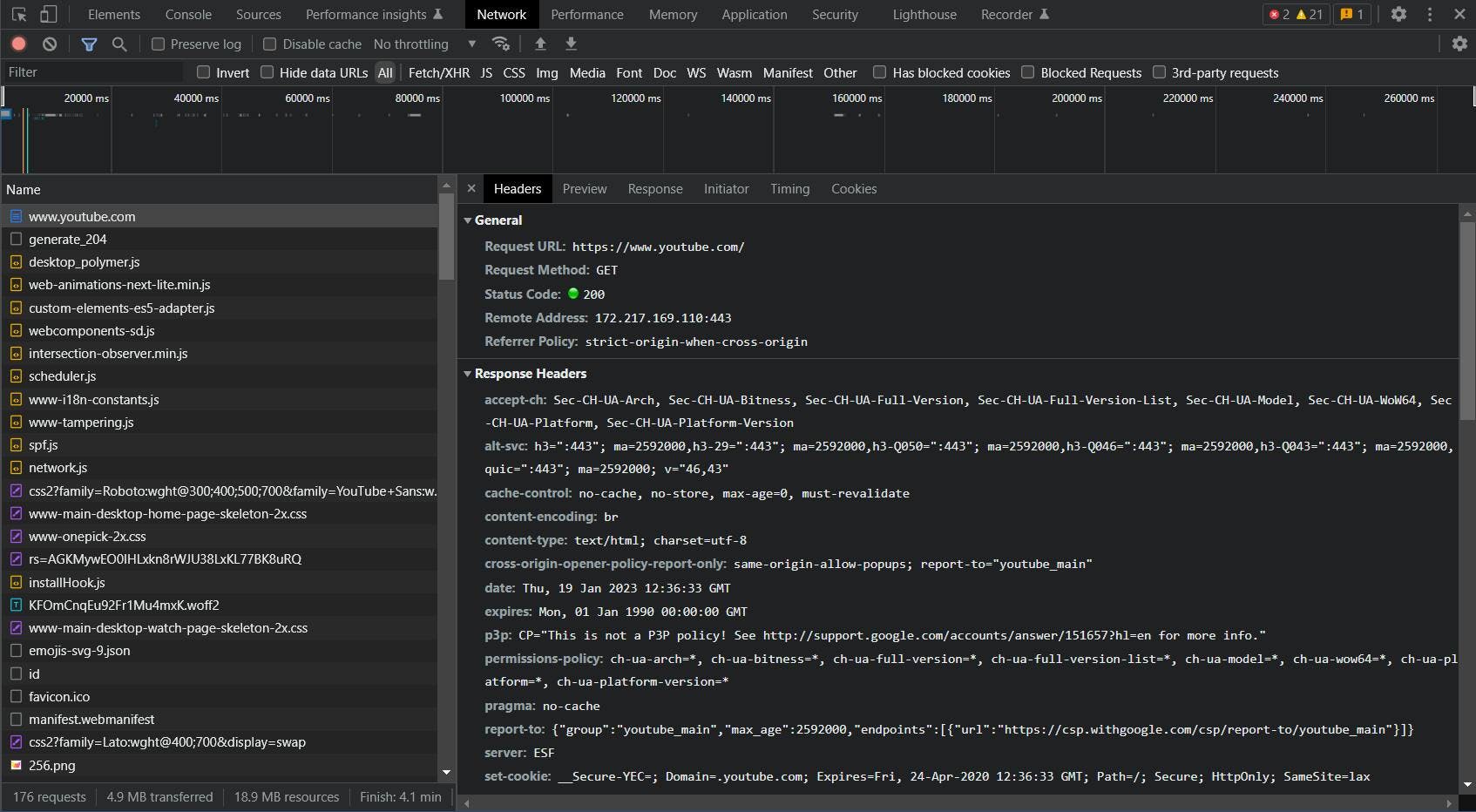

Zurück zu unserem Beispiel: Navigieren Sie in Ihrem echten Browser zu youtube.com. Klicken Sie dann mit der rechten Maustaste auf eine beliebige Stelle der Seite und wählen Sie die Option "Untersuchen". Wenn sich die Entwicklertools öffnen, gehen Sie auf die Registerkarte "Netzwerk".

Nachdem Sie die Seite aktualisiert haben, sollten Sie sehen, dass die Anfragen in Echtzeit geladen werden. Klicken Sie auf die erste (und wichtigste) Anfrage, und eine zusätzliche Registerkarte wird angezeigt.

Hier können Sie alle Details der von Ihnen gesendeten Anfrage sehen: URL, Methode, Statuscode, Remote-Adresse und vor allem: die Anfrage- und Antwort-Header, nach denen wir gesucht haben.

Benutzerdefinierte Kopfzeilen beim Web Scraping verwenden

- httpbin.org verwenden, um die von einem Browser gesendeten Kopfzeilen anzuzeigen

- Wählen Sie eine Programmiersprache und senden Sie eine einfache GET-Anfrage, um die Kopfzeilen zu sehen

- die benutzerdefinierten Kopfzeilen übergeben, die Sie entnommen haben

- Wiederholen Sie den Vorgang für node.js und python

- Überarbeitung des Abschnitts für WSA

- Link zu API-Dokumenten

- Beschreibung der Funktion der benutzerdefinierten Kopfzeilen

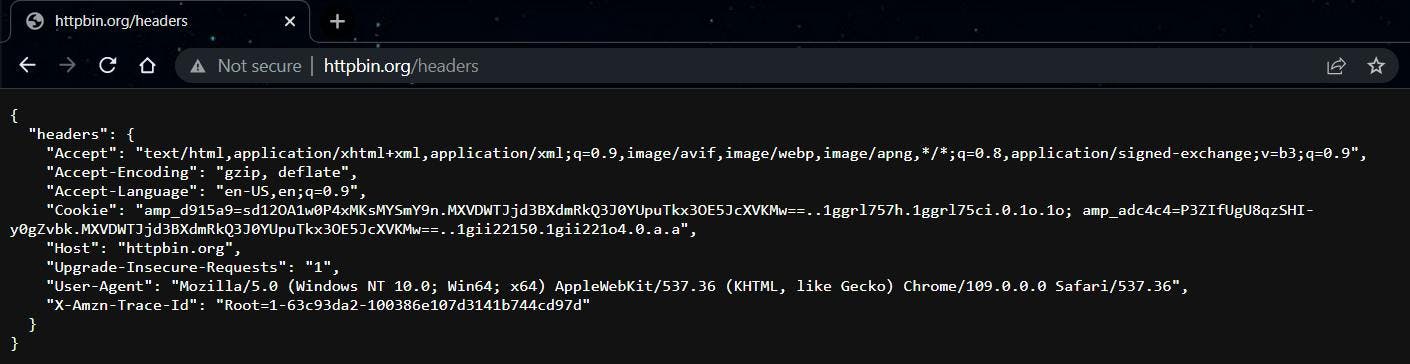

Nun wollen wir sehen, wie wir diese Kopfzeilen nutzen können, um unsere Scraper zu verbessern. Für diesen Teil nehmen wir als Beispiel eine einfache spiegelnde Website, die uns direkt die Kopfzeilen zeigt, die wir senden: https://httpbin.org/headers.

Kopieren Sie den Inhalt des Objekts "headers" und beginnen Sie mit dem Schreiben des Codes.

Node.js

Nachdem Sie sichergestellt haben, dass Ihre Node.js-Umgebung korrekt eingerichtet und Ihr Projekt initialisiert ist, führen Sie den folgenden Code aus:

import got from 'got';

(async () => {

const response = await got('https://httpbin.org/headers')

console.log(response.body)

})()

Auf diese Weise können wir sehen, wie die einfachste GET-Anfrage aussieht. Das Ergebnis sollte sein:

{

"headers": {

"Accept-Encoding": "gzip, deflate, br",

"Host": "httpbin.org",

"User-Agent": "got (https://github.com/sindresorhus/got)",

"X-Amzn-Trace-Id": "Root=1-63c93ff5-0c352d6319620b3d6b46df02"

}

}Dies sieht ganz anders aus als das, was wir in unserem Browser gesehen haben. Allein am User-Agent kann ein Server leicht erkennen, dass die Anfrage automatisiert ist.

Übergeben wir nun unsere benutzerdefinierten Kopfzeilen und senden wir die Anfrage erneut:

import got from 'got';

(async () => {

const custom_headers = {

"Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.9",

"Accept-Encoding": "gzip, deflate, br",

"Accept-Language": "en-US,en;q=0.9",

"Cache-Control": "no-cache",

"Cookie": "amp_d915a9=sd12OA1w0P4xMKsMYSmY9n.MXVDWTJjd3BXdmRkQ3J0YUpuTkx3OE5JcXVKMw==..1ggrl757h.1ggrl75ci.0.1o.1o; amp_adc4c4=P3ZIfUgU8qzSHI-y0gZvbk.MXVDWTJjd3BXdmRkQ3J0YUpuTkx3OE5JcXVKMw==..1gn51hk3v.1gn51lql7.0.e.e",

"Host": "httpbin.org",

"Pragma": "no-cache",

"Sec-Ch-Ua": "\"Not_A Brand\";v=\"99\", \"Google Chrome\";v=\"109\", \"Chromium\";v=\"109\"",

"Sec-Ch-Ua-Mobile": "?0",

"Sec-Ch-Ua-Platform": "\"Windows\"",

"Sec-Fetch-Dest": "document",

"Sec-Fetch-Mode": "navigate",

"Sec-Fetch-Site": "none",

"Sec-Fetch-User": "?1",

"Upgrade-Insecure-Requests": "1",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/109.0.0.0 Safari/537.36",

"X-Amzn-Trace-Id": "Root=1-63c93e34-1ad0141279d49bfc28fb058e"

}

const response = await got('https://httpbin.org/headers', {

headers: custom_headers

})

console.log(response.body)

})()

Wenn Sie das Skript erneut ausführen, sollten Sie feststellen, dass unsere Anfrage jetzt so aussieht, als würde sie von einem echten Chrome-Browser gesendet, obwohl wir keinen echten Browser geöffnet haben.

Python

Versuchen wir nun das Gleiche in Python. Auch wenn die Syntax und die Bibliotheken unterschiedlich sind, ist das Prinzip dasselbe.

import requests

url = 'https://httpbin.org/headers'

headers = {

"Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.9",

"Accept-Encoding": "gzip, deflate, br",

"Accept-Language": "en-US,en;q=0.9",

"Cache-Control": "no-cache",

"Cookie": "amp_d915a9=sd12OA1w0P4xMKsMYSmY9n.MXVDWTJjd3BXdmRkQ3J0YUpuTkx3OE5JcXVKMw==..1ggrl757h.1ggrl75ci.0.1o.1o; amp_adc4c4=P3ZIfUgU8qzSHI-y0gZvbk.MXVDWTJjd3BXdmRkQ3J0YUpuTkx3OE5JcXVKMw==..1gn51hk3v.1gn51lql7.0.e.e",

"Host": "httpbin.org",

"Pragma": "no-cache",

"Sec-Ch-Ua": "\"Not_A Brand\";v=\"99\", \"Google Chrome\";v=\"109\", \"Chromium\";v=\"109\"",

"Sec-Ch-Ua-Mobile": "?0",

"Sec-Ch-Ua-Platform": "\"Windows\"",

"Sec-Fetch-Dest": "document",

"Sec-Fetch-Mode": "navigate",

"Sec-Fetch-Site": "none",

"Sec-Fetch-User": "?1",

"Upgrade-Insecure-Requests": "1",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/109.0.0.0 Safari/537.36",

"X-Amzn-Trace-Id": "Root=1-63c93e34-1ad0141279d49bfc28fb058e"

}

response = requests.get(url, headers=headers)

print(response.text)

Das Ergebnis nach dem Ausführen des Skripts wird unabhängig von der verwendeten Programmiersprache gleich aussehen.

Benutzerdefinierte Kopfzeilen in WebScrapingAPI

Jede seriöse Scraping-API sollte die leistungsstarke Funktion bieten, benutzerdefinierte HTTP-Header und Cookies an eine Anfrage zu übergeben. Der Standard kann je nach API unterschiedlich sein, daher sollten Sie immer zuerst die offizielle Dokumentation konsultieren.

Standardmäßig stellt WebScrapingAPI bei jeder Anfrage eine Reihe von benutzerdefinierten Headern bereit. Zufällige User-Agent-Header wären nur eines der Beispiele.

Da Websites jedoch sehr komplex oder einfach veraltet sein können, haben Sie die Möglichkeit, dieses Verhalten zu deaktivieren und Ihre Anfrage vollständig anzupassen. Stellen Sie einfach sicher, dass Sie sich zuerst einen API-Schlüssel besorgen und dann den folgenden Code ausführen:

import got from 'got';

(async () => {

const response = await got("https://api.webscrapingapi.com/v1", {

searchParams: {

api_key: "YOUR_API_KEY",

url: "https://httpbin.org/headers",

keep_headers: '0',

},

headers: {

"Wsa-Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.9",

"Wsa-Accept-Encoding": "gzip, deflate, br",

"Wsa-Accept-Language": "en-US,en;q=0.9",

"Wsa-Cache-Control": "no-cache",

"Wsa-Cookie": "amp_d915a9=sd12OA1w0P4xMKsMYSmY9n.MXVDWTJjd3BXdmRkQ3J0YUpuTkx3OE5JcXVKMw==..1ggrl757h.1ggrl75ci.0.1o.1o; amp_adc4c4=P3ZIfUgU8qzSHI-y0gZvbk.MXVDWTJjd3BXdmRkQ3J0YUpuTkx3OE5JcXVKMw==..1gn51hk3v.1gn51lql7.0.e.e",

"Wsa-Pragma": "no-cache",

"Wsa-Sec-Ch-Ua": "\"Not_A Brand\";v=\"99\", \"Google Chrome\";v=\"109\", \"Chromium\";v=\"109\"",

"Wsa-Sec-Ch-Ua-Mobile": "?0",

"Wsa-Sec-Ch-Ua-Platform": "\"Windows\"",

"Wsa-Sec-Fetch-Dest": "document",

"Wsa-Sec-Fetch-Mode": "navigate",

"Wsa-Sec-Fetch-Site": "none",

"Wsa-Sec-Fetch-User": "?1",

"Wsa-Upgrade-Insecure-Requests": "1",

"Wsa-User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/109.0.0.0 Safari/537.36",

"Wsa-X-Amzn-Trace-Id": "Root=1-63c93e34-1ad0141279d49bfc28fb058e"

}

})

console.log(response.body)

})()

In diesem Fall müssen wir laut den API-Dokumenten das Präfix "Wsa-" an den Namen eines Headers anhängen, um ihn an die Anfrage zu übergeben. Diese Maßnahme wurde eingeführt, um zu verhindern, dass unbeabsichtigte Kopfzeilen übergeben werden, z. B. wenn die API-Anforderung von einem Browser gesendet wird.

Schlussfolgerung

In diesem Artikel wurde ein Überblick über die Bedeutung und Verwendung von HTTP-Headern und Web-Cookies beim Web-Scraping gegeben.

Wir haben erörtert, was Header und Cookies sind, wie Sie sie verwenden können, um auf eingeschränkte Inhalte zuzugreifen und Ihr Scraping-Skript als legitimen Browser erscheinen zu lassen, und wie sie zur Nachverfolgung und Analyse verwendet werden können.

Wir haben auch einige der üblichen Header vorgestellt, die beim Web Scraping verwendet werden, und erklärt, wie man Header und Cookies von einem echten Browser abruft. Dann haben wir anhand von Codebeispielen gezeigt, wie Sie diese in Ihren Scraping-Skripten verwenden können.

Wenn Sie Header und Cookies verstehen und effektiv nutzen, können Sie die Effizienz Ihrer Web-Scraping-Maßnahmen verbessern. Mit diesem Wissen können Sie Ihre Scraping-Fähigkeiten auf die nächste Stufe heben und wertvolle Informationen aus dem Web extrahieren.

Nachrichten und Aktualisierungen

Bleiben Sie auf dem Laufenden mit den neuesten Web Scraping-Anleitungen und Nachrichten, indem Sie unseren Newsletter abonnieren.

Der Schutz Ihrer Daten liegt uns am Herzen. Lesen Sie unsere Datenschutzrichtlinie.

Ähnliche Artikel

Entdecken Sie die Komplexität des Scrapens von Amazon-Produktdaten mit unserem ausführlichen Leitfaden. Von Best Practices und Tools wie der Amazon Scraper API bis hin zu rechtlichen Aspekten erfahren Sie, wie Sie Herausforderungen meistern, CAPTCHAs umgehen und effizient wertvolle Erkenntnisse gewinnen.

Erforschen Sie die transformative Kraft des Web Scraping im Finanzsektor. Von Produktdaten bis zur Stimmungsanalyse bietet dieser Leitfaden Einblicke in die verschiedenen Arten von Webdaten, die für Investitionsentscheidungen zur Verfügung stehen.

Eintauchen in die transformative Rolle von Finanzdaten bei der Entscheidungsfindung in Unternehmen. Verstehen Sie traditionelle Finanzdaten und die aufkommende Bedeutung alternativer Daten.