Der ultimative Leitfaden für Playwright Web Scraping und Automatisierung für 2023

Suciu Dan am 21. April 2023

Web Scraping und Automatisierung gehen in der digitalen Welt von heute Hand in Hand. Von Preisvergleichs-Websites bis hin zu datengesteuerten Unternehmen ist die Fähigkeit, Daten aus dem Web zu extrahieren und zu verarbeiten, zu einem integralen Bestandteil vieler Online-Unternehmungen geworden.

Hier kommt Playwright ins Spiel: ein Tool, mit dem Sie Web-Scraping- und Testaufgaben mühelos automatisieren können. Playwright ermöglicht Ihnen die Steuerung eines Headless-Browsers, mit dem Sie schnell und effizient Daten auslesen und mit Websites interagieren können.

In diesem Artikel werden wir die Möglichkeiten von Playwright für Automatisierung und Scraping erkunden. Ich zeige Ihnen, wie Sie Playwright installieren und einrichten, stelle Codebeispiele für gängige Aufgaben zur Verfügung und bespreche fortgeschrittene Techniken wie die Handhabung von Anmeldeformularen, das Erstellen von Screenshots und mehr.

Was ist Playwright?

Playwright ist eine von Microsoft entwickelte Open-Source-Bibliothek für plattformübergreifendes Node.js, mit der Sie Aufgaben in einem Webbrowser automatisieren können. Sie ist zuverlässig und einfach zu bedienen und unterstützt moderne Webfunktionen wie CSS3 und JavaScript.

Playwright kann für Aufgaben wie das Testen von Webanwendungen, die Automatisierung webbasierter Aufgaben und Web Scraping verwendet werden. Es baut auf der beliebten Web-Testing-Bibliothek Puppeteer auf und soll eine benutzerfreundlichere und wartbare API bieten.

Playwright unterstützt mehrere Browser, darunter Chromium, Firefox und WebKit. Das heißt, Sie können damit Aufgaben automatisieren und Daten in verschiedenen Browsern abrufen. Mit Playwright können Sie ganz einfach zwischen den Browsern wechseln und die Vorteile ihrer einzigartigen Funktionen nutzen.

Erste Schritte

Um Playwright auf einem lokalen Rechner zu installieren und einzurichten, müssen Sie Node.js und npm (den Paketmanager für Node.js) installiert haben. Wenn Sie diese nicht bereits haben, können Sie sie von der offiziellen Node. js-Website herunterladen und installieren.

Sobald Sie Node.js und npm installiert haben, können Sie Playwright mit den folgenden Schritten installieren:

- Öffnen Sie ein Terminal oder eine Eingabeaufforderung

- Erstellen Sie einen Ordner mit dem Namen "Playwright", in dem unser Projektcode gespeichert wird.

- Wechseln Sie zu dem neu erstellten Ordner

- Führen Sie den Befehl `npm init` aus, um das Projekt zu initialisieren (und die Datei package.json zu erstellen)

- Installieren Sie die erforderliche Abhängigkeit mit dem Befehl `npm install playwright`.

Grundlegendes Scraping mit Playwright

Erstellen Sie eine Datei namens "index.js" und fügen Sie den folgenden Code ein:

const { chromium } = require('playwright');

(async () => {

// Launch a Chromium browser

const browser = await chromium.launch();

// Create a new page in the browser

const page = await browser.newPage();

// Navigate to a website

await page.goto('https://coinmarketcap.com');

// Get the page content

const content = await page.content();

// Display the content

console.log(content);

// Close the browser

await browser.close();

})();Dieser Code startet einen Headless-Chromium-Browser, erstellt eine neue Seite, navigiert zur CoinMarketCap-Homepage, ruft den Seiteninhalt ab, protokolliert den Inhalt und schließt dann den Browser.

Sie können ähnlichen Code verwenden, um die anderen unterstützten Browser (Firefox und WebKit) zu starten, indem Sie das entsprechende Modul benötigen und "chromium" durch "firefox" oder "webkit" ersetzen.

Suche nach Elementen für die Datenextraktion

Nun, da wir eine Grundlage für unseren Scraper haben, können wir einige Daten von der Ziel-Website extrahieren. In diesem Beispiel werden wir den Namen und den Preis der ersten 10 Währungen abrufen, die auf der Seite angezeigt werden.

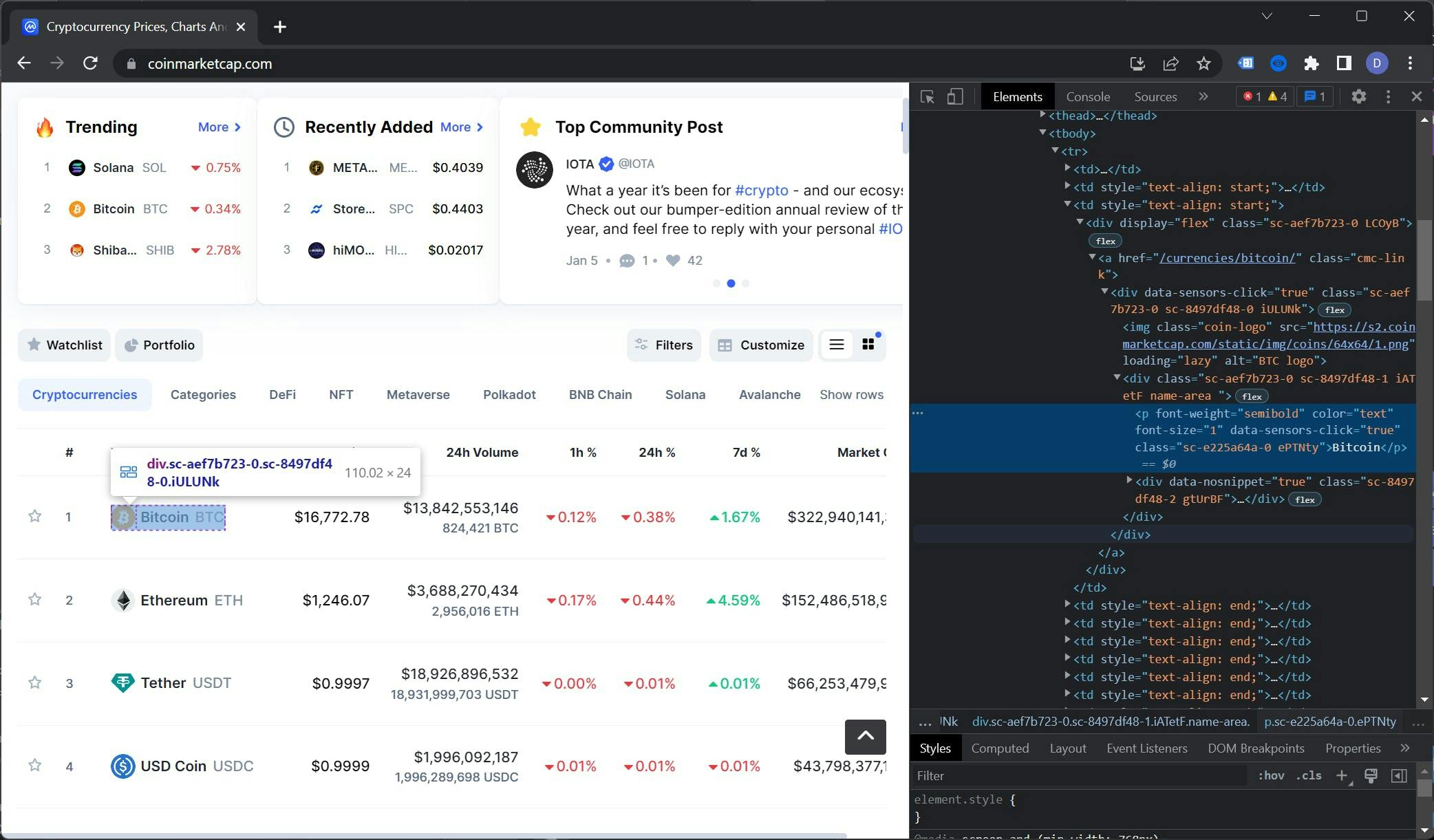

Um den DOM-Baum der CoinMarketCap-Homepage anzuzeigen, öffnen Sie die Website in einem Browser, klicken Sie mit der rechten Maustaste auf den Namen einer Währung und wählen Sie "Inspect". Dadurch werden die Entwicklertools geöffnet und der DOM-Baum angezeigt.

Die Auswahl der richtigen Selektoren ist eine Kunst für sich. In diesem Fall ist das Tabellenelement, das wir auswählen wollen, der Kontext. Diese Tabelle hat eine Klasse namens "cmc-table", die für unsere Zwecke nützlich sein wird.

Um den Selektor für den Währungsnamen zu finden, müssen wir uns im DOM-Baum nach unten bewegen. Das Element, nach dem wir suchen, befindet sich innerhalb des Elements `.cmc-table tbody tr td:nth-child(3) a .name-area p`.

Als allgemeine Faustregel gilt, dass man bei der Auswahl der Elemente so genau wie möglich sein sollte, um die Anzahl der zu bearbeitenden Fehler zu minimieren.

Mit der gleichen Technik können wir den Selektor für den Preis finden, der "cmc-table tbody tr td:nth-child(3) a span" lautet. Um es noch einmal zusammenzufassen, hier ist unsere Selektorliste:

- Name: `.cmc-table tbody tr td:nth-child(3) a .name-area p`

- Preis: `.cmc-table tbody tr td:nth-child(4) a span`

Datenextraktion

Mit Hilfe der Selektoren, die wir zuvor identifiziert haben, extrahieren wir die Daten aus der Webseite und speichern sie in einer Liste. Die Utility-Funktion $$eval gibt ein Array von Elementen zurück, die einem Selektor entsprechen, der im Kontext des DOM der Seite ausgewertet wurde.

Ersetzen wir die Zeile console.log(content); durch diese:

// Extract the currencies data

const currencies = await page.$$eval('.cmc-table tbody tr:nth-child(-n+10)', trs => {

const data = []

trs.forEach(tr => {

data.push({

name: tr.querySelector('td:nth-child(3) a .name-area p').innerHTML,

price: tr.querySelector('td:nth-child(4) a span').innerHTML,

})

})

return data

})

// Display the results

console.log(currencies)

Dieser Code verwendet die Funktion $$eval, um die ersten 10 tr-Elemente innerhalb der .cmc-Tabelle auszuwählen. Dann wird über diese Elemente iteriert, die Datenzellen der Tabelle werden mit den zuvor identifizierten Selektoren ausgewählt und ihr Textinhalt extrahiert. Die Daten werden als ein Array von Objekten zurückgegeben.

Sie können mehr über die Funktion $$eval in der offiziellen Dokumentation lesen.

Der vollständige Code sieht wie folgt aus:

const { chromium } = require('playwright');

(async () => {

// Launch a Chromium browser

const browser = await chromium.launch();

// Create a new page in the browser

const page = await browser.newPage();

// Navigate to a website

await page.goto('https://coinmarketcap.com');

// Extract the currencies data

const currencies = await page.$$eval('.cmc-table tbody tr:nth-child(-n+10)', trs => {

const data = []

trs.forEach(tr => {

data.push({

name: tr.querySelector('td:nth-child(3) a .name-area p').innerHTML,

price: tr.querySelector('td:nth-child(4) a span').innerHTML,

})

})

return data

})

// Display the results

console.log(currencies)

// Close the browser

await browser.close();

})();Umgang mit dynamischen Inhalten

Wir haben nur die ersten 10 Währungen erfasst, weil CoinMarketCap beim ersten Laden der Seite so viele lädt. Um mehr zu scrapen, müssen wir eine menschliche Aktion durchführen, nämlich die Seite scrollen. Glücklicherweise ist Playwright für diese Aufgabe gut geeignet.

Beginnen wir damit, die zuvor verwendete Funktion $$eval umzugestalten und eine Paginierung zu implementieren. Wir nennen diese neue Funktion extractData:

const extractData = async (Seite, aktuelleSeite, proSeite = 10) => {

}Wir erweitern den Selektor :nth-child, indem wir Elemente in Schritten auswählen (Elemente von 0 bis 10, von 11 bis 21, von 22 bis 32 usw.). Wir definieren den ersten Selektor (die ersten 10 Elemente):

let selector = `:nth-child(-n+${currentPage * perPage})`;Zu guter Letzt fügen wir Unterstützung für die nächsten Seiten hinzu. Der Code sieht wie folgt aus:

if(currentPage > 1) {

selector = `:nth-child(n+${(currentPage - 1) + perPage}):nth-child(-n+${(currentPage * perPage) + 1})`;

}Die endgültige Funktion wird wie folgt aussehen:

const extractData = async (page, currentPage, perPage = 10) => {

let selector = `:nth-child(-n+${currentPage * perPage})`;

if(currentPage > 1) {

selector = `:nth-child(n+${(currentPage - 1) + perPage}):nth-child(-n+${(currentPage * perPage) + 1})`;

}

return await page.$$eval(`.cmc-table tbody tr${selector}`, trs => {

const data = [];

trs.forEach(tr => {

data.push({

name: tr.querySelector('td:nth-child(3) a .name-area p').innerHTML,

price: tr.querySelector('td:nth-child(4) a span').innerHTML,

});

});

return data;

});

};Jetzt ist es an der Zeit, zu unserem Scraper-Code zurückzukehren, Scroll zu implementieren und die Datenextraktion zu erweitern. Wir machen die ganze Arbeit nach dieser Zeile:

await page.goto('https://coinmarketcap.com');Wir definieren die Variable "Währungen" neu:

// Extract the currencies data

let currencies = await extractData(page, 1, 10);

Mit der Funktion evaluate scrollen wir die Seite auf das 1,5-fache des Viewports. Dadurch werden die nächsten Elemente der Tabelle geladen:

// Scroll the page to a little more than the viewport height

await page.evaluate(() => {

window.scrollTo(0, window.innerHeight * 1.5);

});

Die eine Sekunde Wartezeit gibt der Benutzeroberfläche etwas Raum, um die Tabelle mit den von der API abgerufenen Daten aufzufüllen:

// Wait for the new elements to load

await page.waitForTimeout(1000);

Zum Schluss extrahieren wir die Daten von der zweiten Seite und protokollieren die Ergebnisse:

// Extract the next 10 elements

currencies = [...currencies, ...await extractData(page, 2, 10)]

// Display the results

console.log(currencies)

Der vollständige Code für den Scraper sollte wie folgt aussehen:

const { chromium } = require('playwright');

const extractData = async (page, currentPage, perPage = 10) => {

let selector = `:nth-child(-n+${currentPage * perPage})`;

if(currentPage > 1) {

selector = `:nth-child(n+${(currentPage - 1) + perPage}):nth-child(-n+${(currentPage * perPage) + 1})`;

}

return await page.$$eval(`.cmc-table tbody tr${selector}`, trs => {

const data = [];

trs.forEach(tr => {

data.push({

name: tr.querySelector('td:nth-child(3) a .name-area p').innerHTML,

price: tr.querySelector('td:nth-child(4) a span').innerHTML,

});

})

return data;

})

};

(async () => {

// Launch a Chromium browser

const browser = await chromium.launch();

// Create a new page in the browser

const page = await browser.newPage();

// Navigate to a website

await page.goto('https://coinmarketcap.com');

// Extract the currencies data

let currencies = await extractData(page, 1, 10)

// Scroll the page to a little more than the viewport height

await page.evaluate(() => {

window.scrollTo(0, window.innerHeight * 1.5);

});

// Wait for the new elements to load

await page.waitForTimeout(1000);

// Extract the next 10 elements

currencies = [...currencies, ...await extractData(page, 2, 10)];

// Display the results

console.log(currencies);

// Close the browser

await browser.close();

})();Der Scraper öffnet also die CoinMarketCap-Startseite, extrahiert die Daten der ersten 10 Währungen, scrollt die Seite, extrahiert die Daten der nächsten 10 Währungen und zeigt die Ergebnisse an.

Sie sollten ähnliche Ergebnisse wie diese erhalten:

[

{ name: 'Bitcoin', price: '$16,742.58' },

{ name: 'Ethereum', price: '$1,244.45' },

{ name: 'Tether', price: '$0.9997' },

{ name: 'USD Coin', price: '$1.00' },

{ name: 'BNB', price: '$255.78' },

{ name: 'XRP', price: '$0.335' },

{ name: 'Binance USD', price: '$1.00' },

{ name: 'Dogecoin', price: '$0.07066' },

{ name: 'Cardano', price: '$0.2692' },

{ name: 'Polygon', price: '$0.7762' },

{ name: 'Dai', price: '$0.9994' },

{ name: 'Litecoin', price: '$73.80' },

{ name: 'Polkadot', price: '$4.59' },

{ name: 'Solana', price: '$12.95' },

{ name: 'TRON', price: '$0.0505' },

{ name: 'Shiba Inu', price: '$0.000008234' },

{ name: 'Uniswap', price: '$5.29' },

{ name: 'Avalanche', price: '$11.43' },

{ name: 'UNUS SED LEO', price: '$3.47' },

{ name: 'Wrapped Bitcoin', price: '$16,725.03' },

{ name: 'Cosmos', price: '$9.97' }

]

Fortgeschrittene Techniken

Nachdem wir nun die Grundlagen des Web Scraping mit Playwright behandelt haben, wie z. B. das Erstellen eines Scrapers, das Finden von Selektoren, das Extrahieren von Daten und das Implementieren von unendlichem Scrollen, ist es nun an der Zeit, sich mit einigen der fortgeschrittenen Funktionen von Playwright zu beschäftigen.

Dazu gehören das Erstellen von Screenshots, das Ausfüllen von Formularen, die Verwendung von XPaths anstelle von Klassenselektoren und die Verwendung von Proxys zur Umgehung von IP-Sperren.

Einen Screenshot machen

Einer der Vorteile von Screenshots beim Web Scraping besteht darin, dass Sie sehen können, wie eine Website oder Webanwendung in verschiedenen Browsern und Auflösungen aussieht.

Dies kann besonders für Entwickler nützlich sein, die mit Hilfe von Screenshots Layout-Probleme beheben und das Erscheinungsbild ihrer Webanwendungen auf verschiedenen Plattformen testen können.

Um einen ganzseitigen Screenshot zu erstellen, können Sie die Screenshot-Methode des Page-Objekts verwenden. Hier ist ein Beispiel:

const screenshot = await page.screenshot();

Dieser Code macht ein Bildschirmfoto der gesamten Seite und gibt es als Puffer zurück. Die Funktion `Screenshot` akzeptiert Eigenschaften. Wir können den Pfad definieren, in dem der Screenshot gespeichert werden soll, und ob der Screenshot nur das Ansichtsfenster oder die gesamte Seite enthalten soll.

Dies ist der vollständige Code:

const { chromium } = require('playwright');

(async () => {

const browser = await chromium.launch();

const page = await browser.newPage();

await page.goto('https://coinmarketcap.com');

// Take a full page screenshot and save the file

await page.screenshot({

path: "screenshot.png",

fullPage: false

});

await browser.close();

})();Sie können diesen Code in einer Datei namens `screenshot.js` speichern und den Code mit dem Befehl `node screenshot.js` ausführen. Nach der Ausführung wird eine Datei `screenshot.png` in Ihrem Projektordner erstellt.

Wir können einen Screenshot von einem Bereich der Seite machen, indem wir die Eigenschaft "Clip" verwenden. Wir müssen vier Eigenschaften definieren:

- x: der horizontale Abstand von der linken oberen Ecke

- y: der vertikale Abstand von der linken oberen Ecke

- Breite: die Breite des Bereichs

- Höhe: die Höhe der Fläche

Die Screenshot-Funktion mit der eingestellten Clip-Eigenschaft sieht folgendermaßen aus:

// Take a screenshot of a part of the page

await page.screenshot({

path: "screenshot.png",

fullPage: false,

clip: {

x: 50,

y: 50,

width: 320,

height: 160

}

});

Formulare ausfüllen

Einer der Vorteile von Playwright ist, dass Sie damit auf geschützte Seiten zugreifen können. Durch die Nachahmung menschlicher Handlungen wie das Klicken auf Schaltflächen, das Scrollen der Seite und das Ausfüllen von Formularen kann Playwright die Anmeldeanforderungen umgehen und auf geschützte Inhalte zugreifen.

Verwenden wir Playwright, um auf unser Reddit-Konto zuzugreifen (wenn Sie noch kein Reddit-Konto haben, erstellen Sie jetzt eines).

Rufen Sie die Anmeldeseite auf und verwenden Sie die Techniken, die wir im Abschnitt "Elemente für die Datenextraktion finden" gelernt haben, um die Klassen für die Eingaben von Benutzernamen und Passwort zu extrahieren.

Die Selektoren sollten wie folgt aussehen:

- Eingabe des Benutzernamens: `#loginUsername`

- Eingabe des Passworts: `#loginPasswort`

- Schaltfläche "Senden": `button[type="submit"]`

Lassen Sie uns diese Selektoren im Code verwenden. Erstellen Sie eine Datei "login.js" und fügen Sie diesen Code ein:

const { chromium } = require('playwright');

(async () => {

const browser = await chromium.launch();

const page = await browser.newPage();

await page.goto('https://reddit.com/login');

// Fill up the form

await page.fill('#loginUsername', "YOUR_REDDIT_USERNAME");

await page.fill('#loginPassword', "YOUR_REDDIT_PASSWORD");

// Click the submit button

await page.click('button[type="submit"]');

// Wait for the new page to load

await page.waitForNavigation()

// Take a screenshot of the new page

await page.screenshot({

path: "reddit.png",

fullPage: false

});

// Close the browser

await browser.close();

})();Um den Code auszuführen und einen Screenshot der geschützten Seite zu erstellen, geben Sie einfach node login.js in das Terminal ein. Nach ein paar Sekunden wird ein Screenshot mit dem Namen reddit.png in Ihrem Projektverzeichnis angezeigt.

Leider kann ich den daraus resultierenden Screenshot nicht mit Ihnen teilen, da die meisten Inhalte meines Reddit-Accounts nicht sicher für die Arbeit sind.

Weitere Informationen zur Authentifizierung mit Playwright finden Sie in der offiziellen Dokumentation.

XPath für die Datenextraktion verwenden

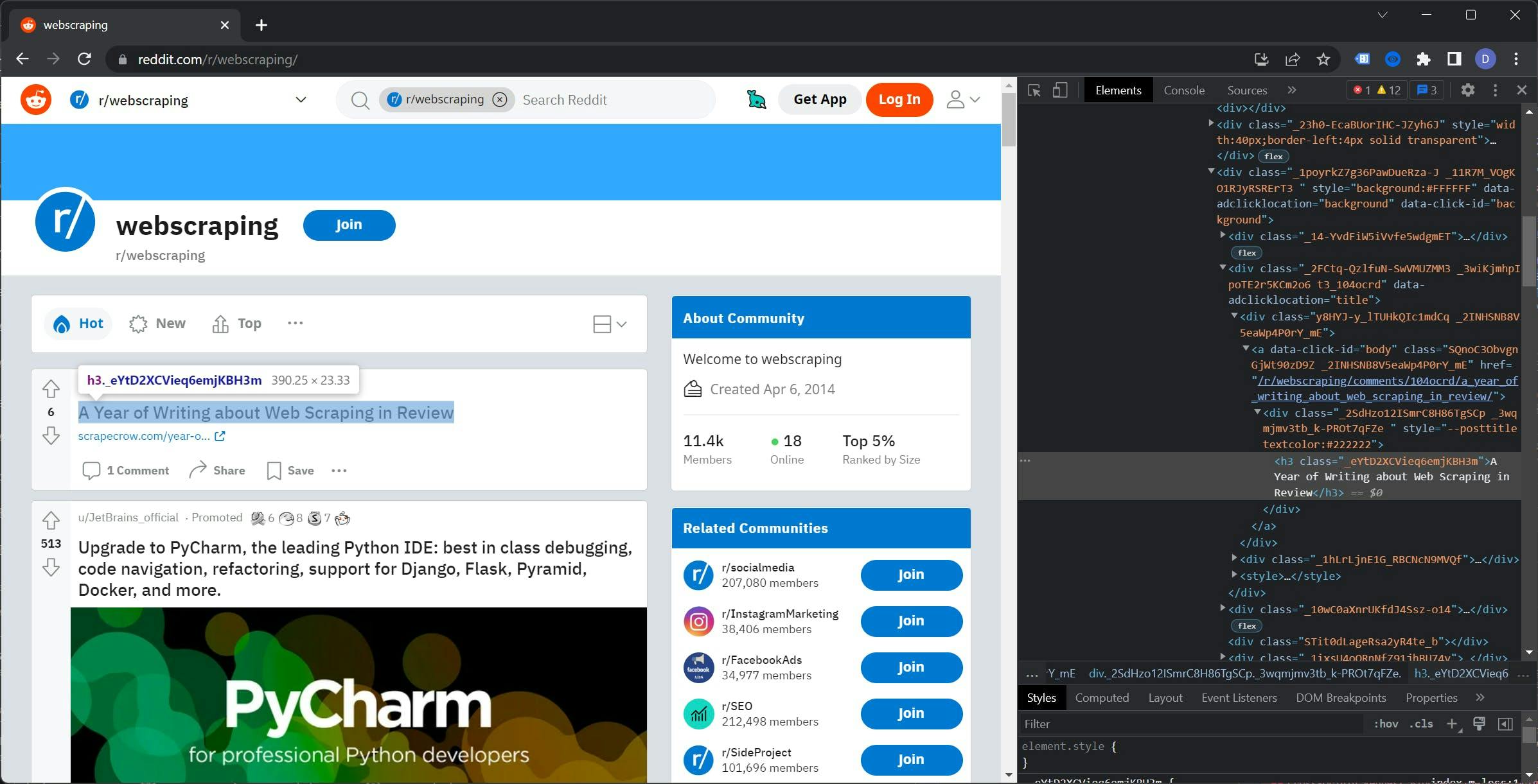

XPath kann eine stabilere Wahl für Web Scraping sein, weil es sich weniger wahrscheinlich ändert als Klassennamen. Websites wie Reddit und Google aktualisieren häufig ihre Klassennamen, was zu Problemen für Scraper führen kann, die von ihnen abhängig sind.

Im Gegensatz dazu basieren XPath-Ausdrücke auf der Struktur des HTML-Dokuments und sind weniger anfällig für Änderungen. Dies bedeutet, dass Sie XPath verwenden können, um Elemente auf zuverlässigere und stabilere Weise zu identifizieren, selbst auf Websites, die ihre Klassennamen häufig aktualisieren.

Die Verwendung von XPath kann Ihnen dabei helfen, einen robusteren und widerstandsfähigeren Web Scraper zu erstellen, der weniger anfällig für Störungen ist, wenn die Website aktualisiert wird.

Wir werden in diesem Artikel nur an der Oberfläche dessen kratzen, was Sie mit XPath tun können. Eine umfassendere Anleitung finden Sie in diesem Artikel.

Gehen wir zurück zu Reddit, öffnen Sie ein Subreddit und öffnen Sie die Entwicklertools. Ich werde den Subreddit /r/webscraping verwenden, aber Sie können jeden beliebigen Subreddit auswählen.

Wenn Sie den DOM-Baum untersuchen, werden Sie feststellen, dass die Klassen für die Elemente zufällig generiert zu sein scheinen. Die Verwendung dieser Klassen würde die Zuverlässigkeit des Scrapers verringern und eine ständige Wartung erfordern.

Klicken Sie mit der rechten Maustaste auf den Tag "h3", gehen Sie auf Kopieren und wählen Sie "XPath kopieren". Das Ergebnis sollte wie folgt aussehen:

//*[@id="t3_104ocrd"]/div[3]/div[2]/div[1]/a/div/h3

Bevor wir diese Regel verwenden, müssen wir den @id-Teil entfernen, damit der Pfad alle Beiträge umfasst und nicht nur den ersten.

Es ist Zeit, es einzusetzen. Erstellen Sie die Datei "xpath.js" und fügen Sie diesen Code ein:

const { chromium } = require('playwright');

(async () => {

const browser = await chromium.launch();

const page = await browser.newPage();

await page.goto('https://reddit.com/r/webscraping');

const titles = await page.$$eval("//*/div[3]/div[2]/div[1]/a/div/h3", element => {

const data = []

element.forEach(el => {

data.push(el.innerHTML)

})

return data

})

console.log(titles)

// Close the browser

await browser.close();

})();Um den Code auszuführen, verwenden Sie den Befehl "node xpath.js". Dieser gibt eine Liste von Titeln aus dem von Ihnen ausgewählten Subreddit zurück. Meine Liste sieht zum Beispiel so aus:

[

'A Year of Writing about Web Scraping in Review',

'Linkedin Comments Scraper - Script to scrape comments (including name, profile picture, designation, email(if present), and comment) from a LinkedIn post from the URL of the post.',

'Best Proxy Lists?',

'Sorry if this is the wrong sub, but is it possible to extract an email from an old youtube account?',

'Looking for people with datasets for sale!',

"Ändern sich die Klassennamen bei reddit regelmäßig (mit zufälligen Buchstaben und Zahlen und so)?",

'Scrape Videos von mehreren Websites',

'Kann mir jemand ein Programm schreiben, das automatisch ein PDF eines Zeitschriftenabonnements erstellt?',

'Scraping einer dynamischen Webseite mit rSelenium',

'Gibt es eine Möglichkeit, LinkedIn Sales Navigator-URLs in eine öffentliche LinkedIn-URL zu konvertieren?',

'Gurufocus / Implementierter neuer Cloudflare-Schutz?',

'Scraper zum Sammeln von APY-Daten von Web3-Frontends'

]

Weitere Informationen zu XPath finden Sie in der offiziellen Playwright-Dokumentation. Sie finden sie hier.

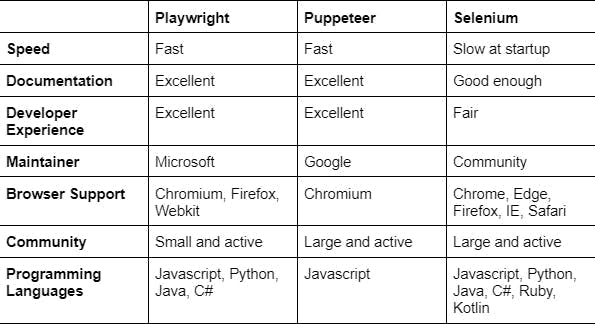

Dramatiker vs. Die Anderen

Playwright, Puppeteer und Selenium WebDriver sind allesamt Tools, die für Web Scraping und Automatisierung verwendet werden können.

Playwright, entwickelt von Microsoft, ist ein neueres Tool, das eine "vollständige" Lösung für die Web-Automatisierung sein soll. Es unterstützt mehrere Browser (Chromium, Firefox und WebKit) und mehrere Programmiersprachen (JavaScript, TypeScript, Python und C#).

Puppeteer ist ein von Google entwickeltes Tool für Web Scraping und Automatisierung, das auf dem Chrome DevTools-Protokoll aufbaut. Es wird in erster Linie mit JavaScript verwendet und verfügt über viele Funktionen, darunter die Erstellung von Screenshots, die Erzeugung von PDFs und die Interaktion mit dem DOM.

Selenium WebDriver ist ein Tool für die Webautomatisierung und -tests, das mehrere Programmiersprachen und Browser unterstützt. Es ist auf das Testen ausgerichtet und erfordert möglicherweise mehr Einrichtungsaufwand als einige andere Tools.

Vergleich der Leistung

Die Leistung ist ein wichtiger Faktor bei der Auswahl eines Web Scraping-Tools. In diesem Abschnitt vergleichen wir die Leistung von Playwright, Puppeteer und Selenium WebDriver, um zu sehen, welches Tool das schnellste und effizienteste ist.

Bei unseren Tests stellten wir fest, dass Playwright und Puppeteer bei Web Scraping und Automatisierungsaufgaben fast identische Reaktionszeiten hatten. Allerdings war Selenium WebDriver beim Start deutlich langsamer als die beiden anderen Tools.

Schlussfolgerung

Mit Web Scraping können Sie Daten aus Websites extrahieren und verarbeiten, was eine Fülle von Informationen und Möglichkeiten für Unternehmen und Privatpersonen bietet. Einige Vorteile von Web Scraping sind:

- Kosteneinsparungen: Web Scraping kann eine kosteneffiziente Art der Datenerfassung sein, da es Ihnen erlaubt, den Kauf teurer Datenbanken oder APIs zu umgehen.

- Zeiteffizienz: Das Scraping großer Datenmengen kann viel schneller erfolgen als die manuelle Erfassung der Daten.

- Aktuelle Daten: Web Scraping kann Ihnen dabei helfen, Ihre Daten auf dem neuesten Stand zu halten, da Sie Ihre Datenquellen regelmäßig scrapen und aktualisieren können.

Playwright ist ein leistungsfähiges Tool für Web-Scraping und bietet eine Vielzahl von Funktionen, die es für viele Benutzer zur ersten Wahl machen. Einige Vorteile der Verwendung von Playwright sind:

- Kompatibilität mit Chromium: Playwright basiert auf Chromium, dem Open-Source-Browser-Projekt, das auch Google Chrome betreibt. Dadurch haben Sie Zugriff auf die neuesten Funktionen der Webplattform und eine breite Palette an Kompatibilität mit Websites.

- Cross-Browser-Unterstützung: Mit Playwright können Sie Aufgaben in mehreren Browsern automatisieren, einschließlich Chrome, Firefox und Safari.

- Benutzerfreundlichkeit: Playwright verfügt über eine einfache und intuitive API, die den Einstieg in das Web-Scraping und die Automatisierung von Aufgaben erleichtert.

- Vielseitigkeit: Playwright kann für eine Vielzahl von Aufgaben verwendet werden, darunter Web Scraping, Testen und Automatisierung.

Insgesamt machen die Vorteile des Web Scraping und die Vorteile der Verwendung von Playwright es zu einem unverzichtbaren Werkzeug für jeden, der Daten aus dem Web extrahieren und verarbeiten möchte.

Wenn Sie nach einer einfacheren Lösung für Ihre Web-Scraping-Anforderungen suchen, sollten Sie WebScrapingAPI in Betracht ziehen. Unser Service ermöglicht es Ihnen, Daten von jeder beliebigen Website zu scrapen, ohne dass Sie sich mit der komplexen Einrichtung und Wartung eines Web-Scrapers befassen müssen.

Mit WebScrapingAPI können Sie einfach eine HTTP-Anfrage mit der URL der Website, die Sie scrapen möchten, an unsere API senden, und wir liefern Ihnen die Daten in Ihrem bevorzugten Format (JSON, HTML, PNG).

Unsere API übernimmt die gesamte Arbeit für Sie, einschließlich der Umgehung von CAPTCHAs, der Handhabung von IP-Sperren und der Handhabung dynamischer Inhalte.

Warum also Zeit und Ressourcen für die Entwicklung und Wartung eines eigenen Web Scrapers verschwenden, wenn Sie WebScrapingAPI nutzen und die benötigten Daten mit nur wenigen einfachen API-Anfragen erhalten können? Testen Sie uns und sehen Sie, wie wir Ihre Web-Scraping-Bedürfnisse rationalisieren können.

Nachrichten und Aktualisierungen

Bleiben Sie auf dem Laufenden mit den neuesten Web Scraping-Anleitungen und Nachrichten, indem Sie unseren Newsletter abonnieren.

Der Schutz Ihrer Daten liegt uns am Herzen. Lesen Sie unsere Datenschutzrichtlinie.

Ähnliche Artikel

Entdecken Sie die Komplexität des Scrapens von Amazon-Produktdaten mit unserem ausführlichen Leitfaden. Von Best Practices und Tools wie der Amazon Scraper API bis hin zu rechtlichen Aspekten erfahren Sie, wie Sie Herausforderungen meistern, CAPTCHAs umgehen und effizient wertvolle Erkenntnisse gewinnen.

Erforschen Sie den detaillierten Vergleich zwischen Scrapy und Selenium für Web Scraping. Von der Datenerfassung in großem Maßstab bis hin zum Umgang mit dynamischen Inhalten - entdecken Sie die Vor- und Nachteile sowie die einzigartigen Funktionen der beiden Frameworks. Erfahren Sie, wie Sie das beste Framework für die Anforderungen und den Umfang Ihres Projekts auswählen können.

Erfahren Sie, welcher Browser am besten geeignet ist, um Cloudflare-Erkennungssysteme beim Web-Scraping mit Selenium zu umgehen.