Top 5 der besten Scraping-Tools für Amazon

Robert Sfichi am 20. April 2021

Unter Web Scraping versteht man das Abrufen einer Webseite und das Extrahieren der darauf befindlichen Daten. Sobald Sie die Informationen haben, wollen Sie sie in der Regel analysieren, umformatieren oder in eine Kalkulationstabelle kopieren.

Web Scraping hat viele Verwendungszwecke, aber heute wollen wir uns auf einige wenige konzentrieren: das Sammeln von Preis- und Produktdaten von Marktplätzen. Einzelhändler nutzen dieses Wissen, um den Markt und ihre Konkurrenz besser zu verstehen.

Die Vorteile können in der Tat ziemlich groß sein. Überlegen Sie einmal: Um die Strategie Ihrer Konkurrenz zu durchkreuzen, müssen Sie sie erst einmal kennen. Wenn Sie z. B. die Preise Ihrer Konkurrenten kennen, können Sie sich mit einem Sonderrabatt oder einem niedrigeren Preis einen Vorsprung verschaffen.

Amazon ist einer der größten Marktplätze im Internet. Die Menschen nutzen seine Dienste täglich, um Lebensmittel, Bücher, Laptops und sogar Webhosting-Dienste zu bestellen. Für die Zukunft plant Amazon, diese Liste um fertig gebaute Häuser zu erweitern.

Als eine der führenden E-Commerce-Seiten ist Amazon eine der größten Datenbanken für Produkte, Bewertungen, Einzelhändler und Markttrends. Es ist eine Goldmine für Web Scraping.

Wir werden die besten 5 APIs analysieren, um Amazon-Daten abzurufen, ohne blockiert zu werden. Wenn Sie versuchen, das beste Tool zu finden, um Daten von Amazon zu extrahieren, wird dieser Artikel Ihnen eine Menge Zeit sparen.

Fangen wir an! Klicken Sie auf einen der folgenden Dienste, um zu seinem Abschnitt zu springen.

Warum sollte jemand die Daten von Amazon auslesen?

Wenn Sie jemals versucht haben, etwas online zu verkaufen, wissen Sie, dass einige der wichtigsten Schritte in diesem Prozess sind:

- Analyse der Wettbewerber;

- Verbesserung Ihrer Produkte und Ihres Leistungsversprechens;

- Erkennen von Markttrends und deren Auswirkungen.

Durch das Scrapen von Amazon-Daten können wir problemlos Informationen über konkurrierende Produkte wie Preise, Bewertungen oder Verfügbarkeit abrufen, vergleichen und überwachen. Wir können das Kostenmanagement für ihre Operationen analysieren, aber auch tolle Angebote für den Wiederverkauf finden.

Eine Sache ist sicher. Wenn Sie Amazon nutzen, um Ihre Produkte zu verkaufen, werden Sie von der Analyse aller zuvor genannten Faktoren profitieren. Sie können dies selbst tun, indem Sie Hunderte oder sogar Tausende von Produkten manuell überwachen, oder Sie können ein Tool verwenden, um dies zu automatisieren.

In den folgenden Abschnitten werden wir versuchen, eine Reihe von Lösungen für diejenigen anzubieten, die Schwierigkeiten mit dem Scrapen von Amazon-Informationen haben.

Warum brauchen Sie eine Web Scraping API?

Amazon ist einer der größten (wenn nicht sogar der größte) Shops, den das Internet je gesehen hat. Als solcher ist Amazon auch eine der größten Datensammlungen über Kunden, Produkte, Bewertungen, Einzelhändler, Markttrends und sogar das Temperament der Kunden.

Bevor wir mit der Datenextraktion beginnen, sollten Sie wissen, dass Amazon das Scraping seiner Website nicht unterstützt. Aus diesem Grund unterscheidet sich die Struktur der Seiten, wenn die Produkte in verschiedene Kategorien fallen. Die Website enthält einige grundlegende Anti-Scraping-Maßnahmen, die verhindern könnten, dass Sie Ihre dringend benötigten Informationen erhalten. Außerdem kann Amazon herausfinden, ob Sie einen Bot zum Scraping verwenden, und wird Ihre IP-Adresse definitiv sperren.

Die besten Scraping-APIs für den Job

Um die Arbeit so schnell wie möglich zu erledigen und ohne für jedes Tool, das wir testen wollen, ein neues Projekt zu erstellen, werden wir das Scraping mit einem Terminal und einigen Curl-Anfragen durchführen. Wir haben fünf vielversprechende Web-Scraping-APIs zum Ausprobieren ausgewählt.

Testen wir sie alle und finden wir heraus, welches das beste Tool zum Scrapen von Amazon-Daten ist:

1. WebScrapingAPI

WebScrapingAPI ist ein Tool, mit dem wir jede beliebige Online-Ressource scrapen können. Es sammelt den HTML-Code einer beliebigen Webseite mithilfe einer einfachen API und stellt verarbeitungsfertige Daten bereit. Es eignet sich hervorragend für die Extraktion von Produktinformationen, die Verarbeitung von Immobilien-, Personal- oder Finanzdaten und sogar die Verfolgung von Informationen für einen bestimmten Markt. Mit WebScrapingAPI können wir alle benötigten Informationen von einer bestimmten Amazon-Produktseite abrufen.

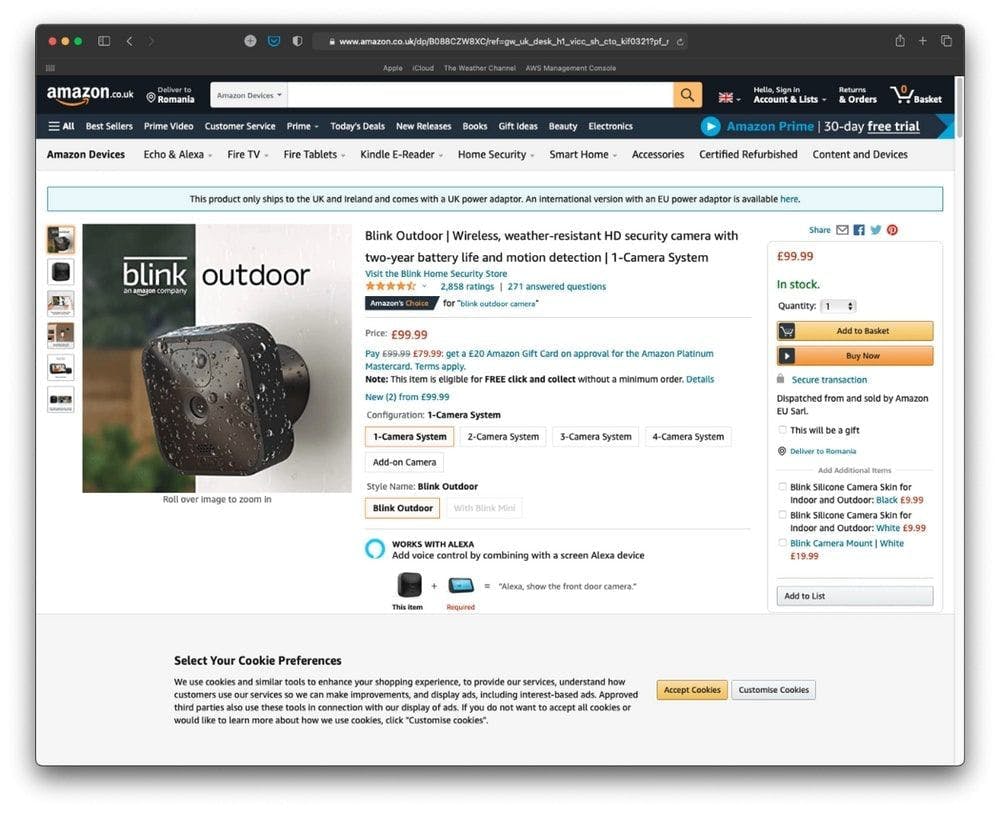

Lassen Sie uns zunächst ein interessantes Produkt auf dem Amazon-Marktplatz finden.

Wir werden die im obigen Bild dargestellte Produktseite scrapen.

Zweitens, lassen Sie uns die URL der Produktseite abrufen: https://www.amazon.co.uk/dp/B088CZW8XC/ref=gw_uk_desk_h1_vicc_sh_cto_kif0321?pf_rd_r=RYXBGN8C757Y9BD6W38B

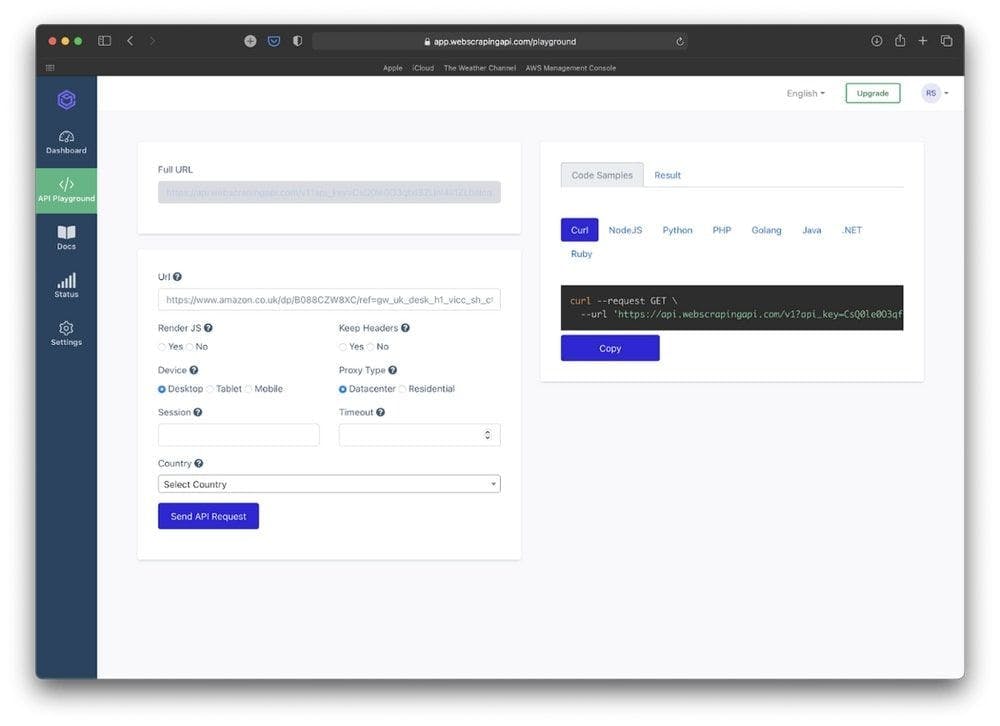

Nachdem wir ein neues WebScrapingAPI-Konto erstellt haben, werden wir zum Dashboard der Anwendung weitergeleitet. WebScrapingAPI bietet einen kostenlosen Plan mit 1000 Anfragen zum Testen der Anwendung. Das ist mehr als genug für das, was wir tun werden.

Auf der Dashboard-Seite klicken wir auf die Schaltfläche "Use API Playground". Hier sehen wir den vollständigen curl-Befehl, der uns beim Scrapen der Amazon-Produktseite helfen wird.

Fügen wir den Link des Produkts in die URL-Eingabe ein. Dadurch wird die Vorschau des URL-Befehls auf der rechten Seite geändert.

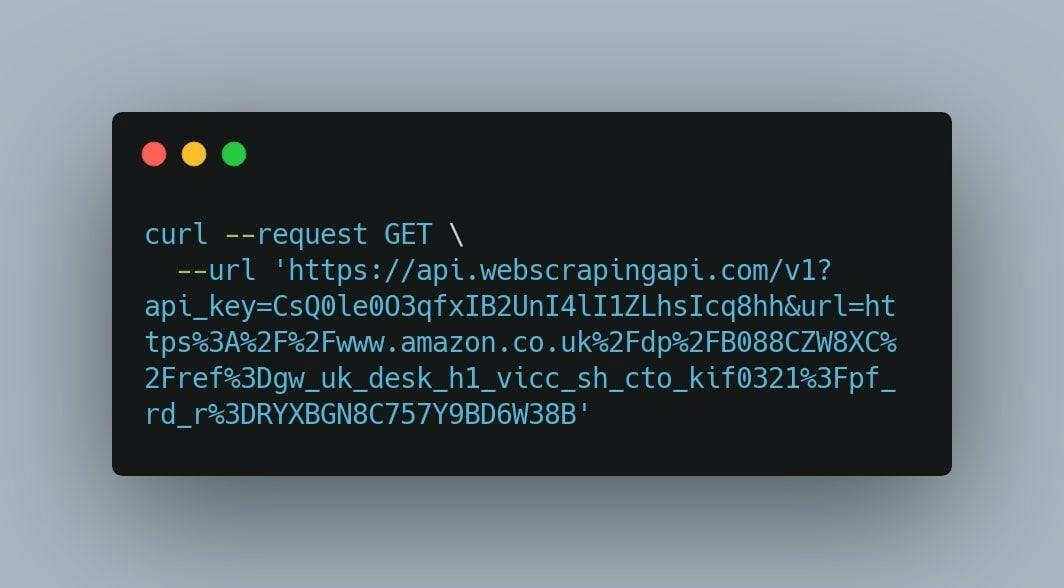

Kopieren Sie nach diesem Schritt den Befehl curl, öffnen Sie ein neues Terminalfenster und fügen Sie ihn dort ein. Wenn Sie die vorangegangenen Schritte befolgt haben, sollten Sie etwa so ein Ergebnis erhalten:

Nachdem wir die Eingabetaste gedrückt haben, wird WebScrapingAPI die Produktseite im HTML-Format zurückgeben.

Nach unseren Recherchen konnte WebScrapingAPI die benötigten Informationen in 99,7 % der Fälle mit einer Erfolgsquote von 997 von 1000 Anfragen und einer Latenzzeit von nur 1 Sekunde erfolgreich abrufen.

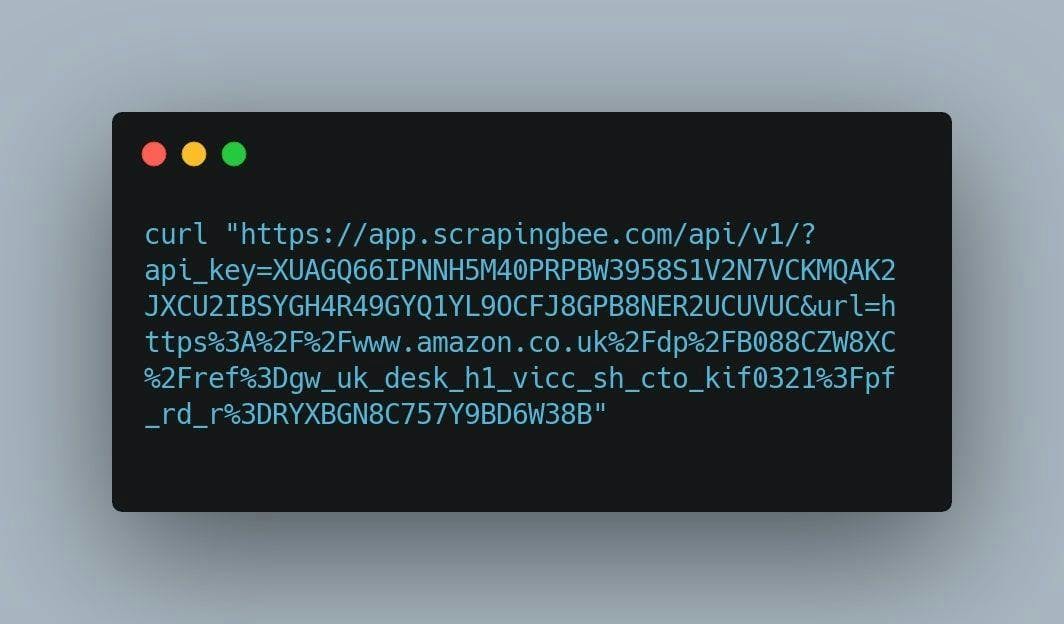

2. ScrapingBee

ScrapingBee bietet die Möglichkeit, Web-Scraping zu betreiben, ohne blockiert zu werden, sowohl mit klassischen als auch mit Premium-Proxys. Es konzentriert sich auf die Extraktion von Daten, die Sie benötigen, indem es Webseiten in einem echten Browser (Chrome) rendert. Dank des großen Proxy-Pools können Entwickler und Unternehmen Scraping betreiben, ohne sich um Proxys und Headless-Browser kümmern zu müssen.

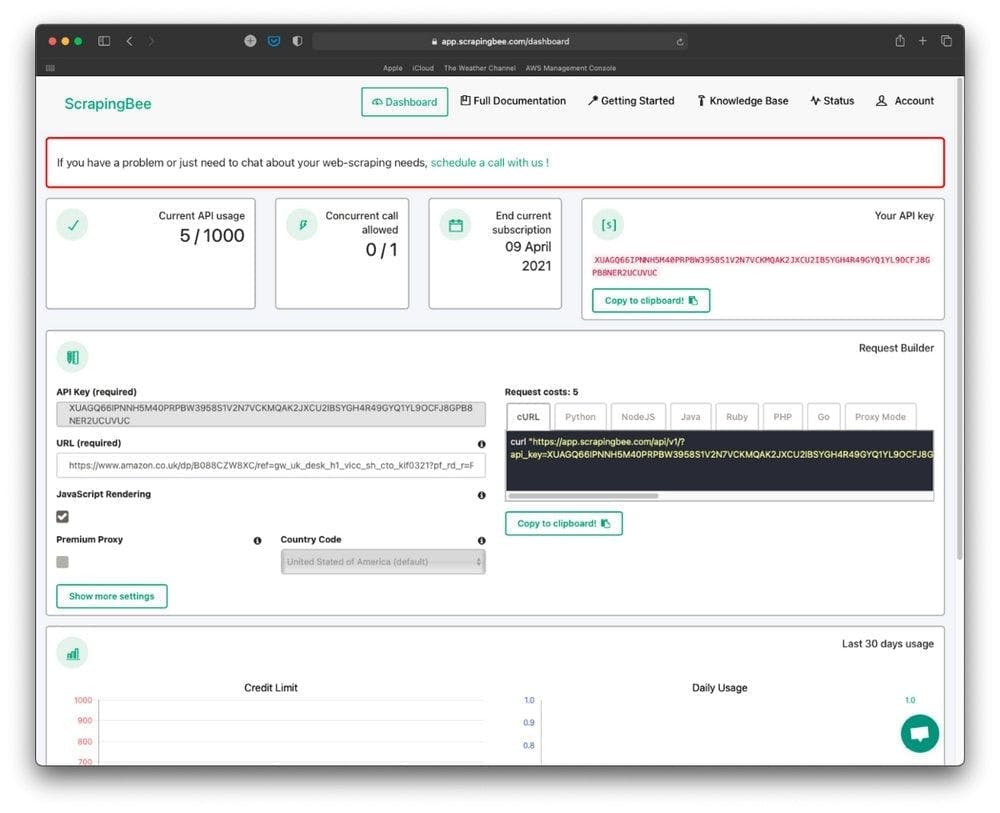

Versuchen wir, die gleiche Amazon-Seite wie zuvor zu scrapen. Erstellen Sie ein neues Konto auf ScrapingBee, gehen Sie zum Dashboard der Anwendung und fügen Sie die zuvor präsentierte URL in die URL-Eingabe ein.

Klicken Sie auf die Schaltfläche "In die Zwischenablage kopieren", die sich im Abschnitt "Request Builder" befindet.

Öffnen wir nun ein Terminal-Fenster, fügen wir den soeben kopierten Code ein und drücken ENTER.

Mit diesem Befehl werden wir dieselbe Seite auf dem Amazon-Marktplatz abrufen, so dass wir die Ergebnisse jeder API vergleichen können.

Bei unseren Recherchen haben wir herausgefunden, dass ScrapingBee die Informationen in 92,5 % der Fälle erfolgreich abrufen konnte, und das bei einer ziemlich großen Latenz von 6 Sekunden.

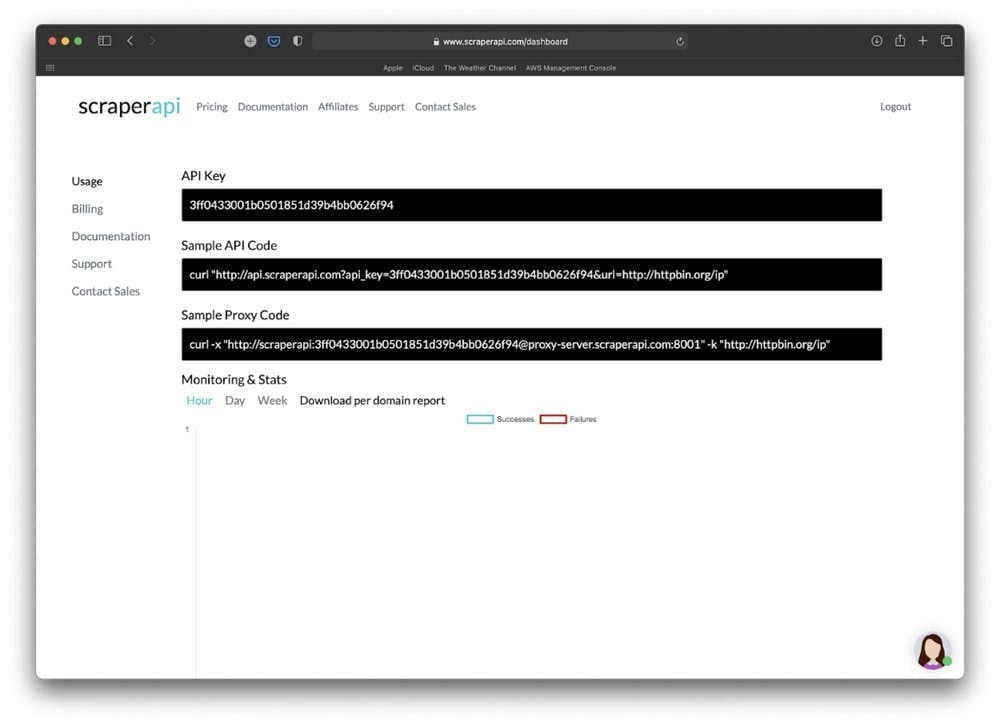

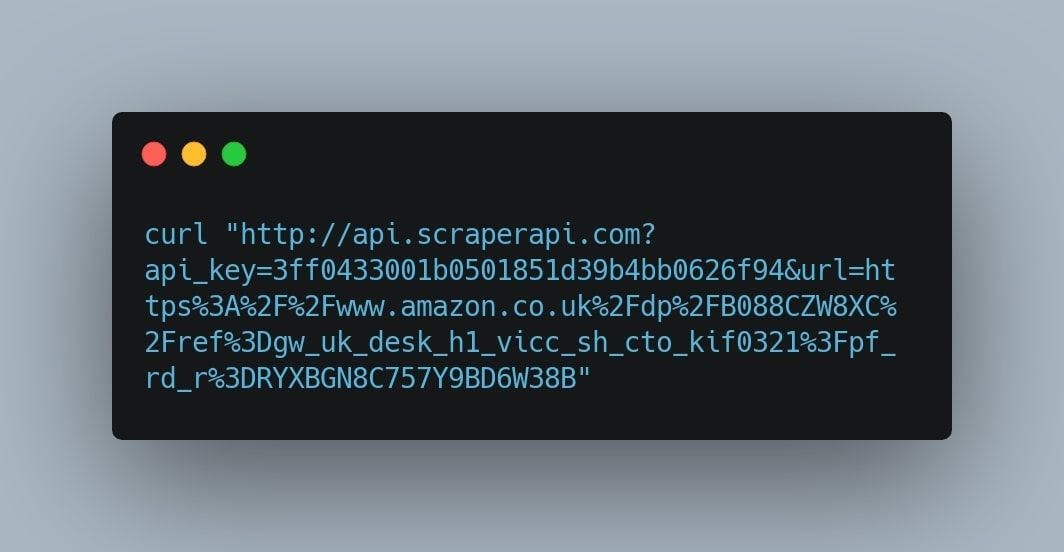

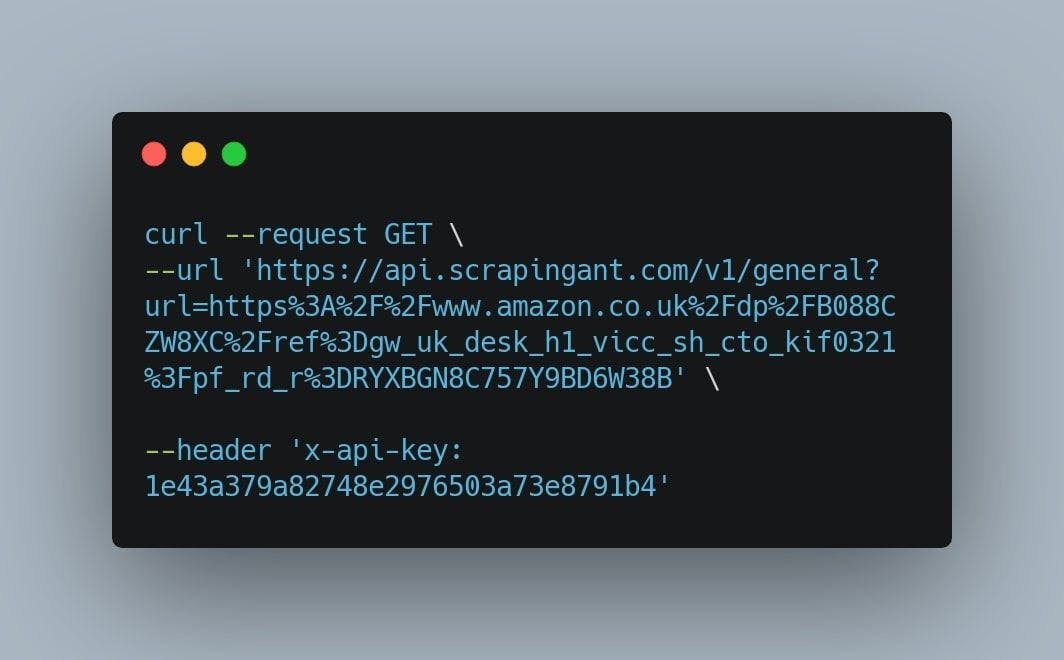

3. ScraperAPI

ScraperAPI ist ein Tool für Entwickler, die Web-Scraper erstellen - wie sie sagen - das Tool, das jede Seite mit einem einfachen API-Aufruf scrappt. Der Webservice verarbeitet Proxys, Browser und CAPTCHAs, so dass Entwickler den rohen HTML-Code von jeder Website erhalten können. Außerdem schafft es das Produkt, ein einzigartiges Gleichgewicht zwischen seinen Funktionen, seiner Zuverlässigkeit und seiner Benutzerfreundlichkeit zu finden.

Wie zuvor werden wir ein neues Konto bei ScraperAPI erstellen und die 1000 kostenlosen Anfragen nutzen, um das Scraping-Tool zu testen. Nachdem wir den Registrierungsprozess abgeschlossen haben, werden wir auf die folgende Seite weitergeleitet:

Auf den ersten Blick sieht es nicht so aus, als ob die ScraperAPI die Möglichkeit bietet, die Curl-Anfrage durch das Schreiben einer neuen URL anzupassen. Das ist keine große Sache. Wir öffnen ein neues Terminalfenster und kopieren den Code aus der Eingabe "Sample API Code".

Wie wir sehen können, ist die Standard-URL, die abgefragt wird, "http:/httpbin.org/ip". Wir werden sie in die entgangene Version der URL der Produktseite ändern, die am Anfang des Abschnitts präsentiert wird. Ändern Sie den zuvor angezeigten Link durch den folgenden:

https%3A%2F%2Fwww.amazon.co.uk%2Fdp%2FB088CZW8XC%2Fref%3Dgw_uk_desk_h1_vicc_sh_cto_kif0321%3Fpf_rd_r%3DRYXBGN8C757Y9BD6W38B

Der letzte Befehl sollte etwa so aussehen:

Nachdem wir die Eingabetaste gedrückt haben, wird uns der HTML-Code der Produktseite angezeigt. Sie können natürlich Cheerio oder einen anderen Markup-Parser verwenden, um die resultierende Datenstruktur zu manipulieren.

ScraperAPI scheint eine der besten Möglichkeiten zu sein, da die Erfolgsquote 100 % beträgt und die Latenzzeit nicht mehr als 1 Sekunde beträgt.

Wie wir bereits im vorherigen Kapitel erwähnt haben, sollten Sie bedenken, dass Amazon von Versuchen abrät, die Daten seiner Website auszulesen.

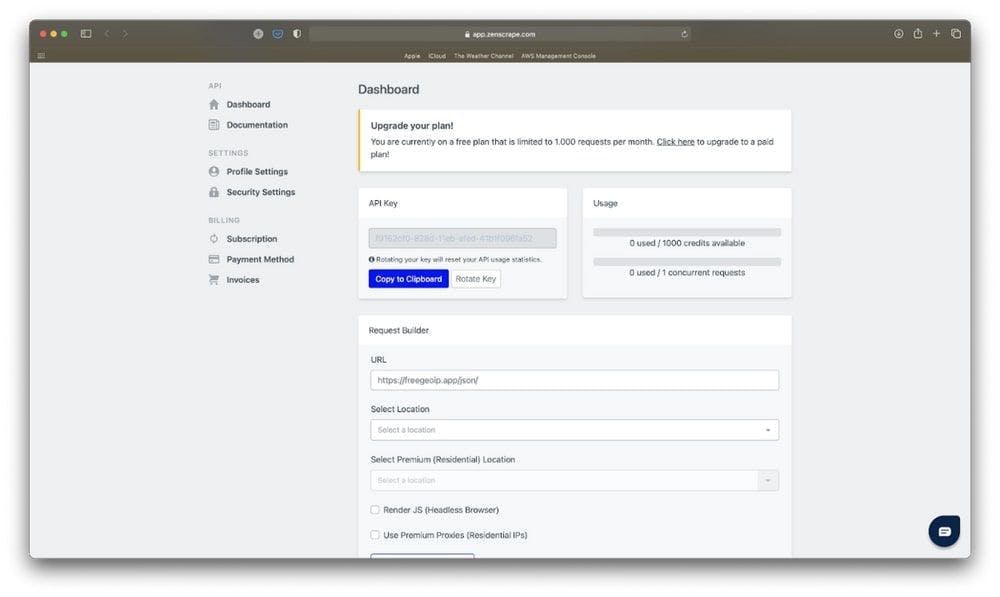

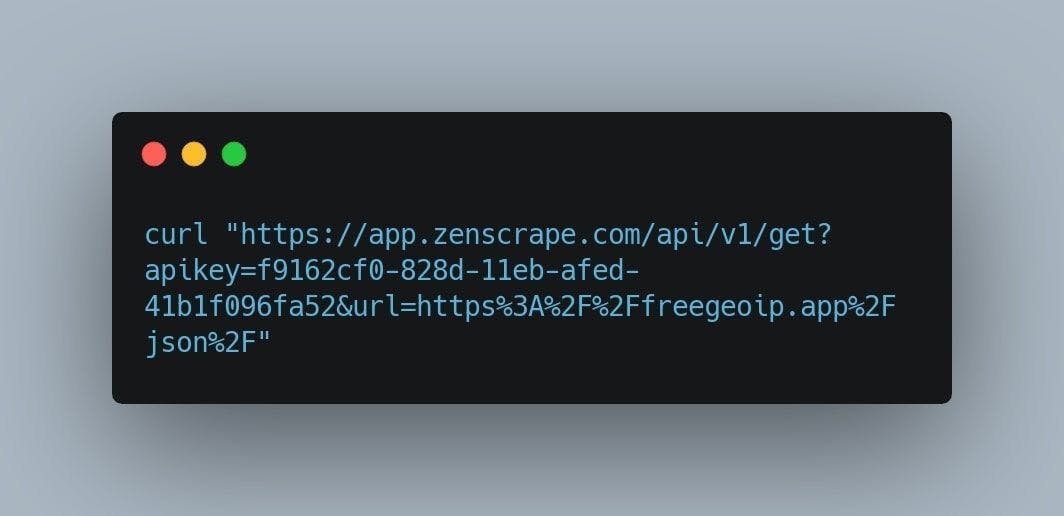

4. Zenscrape

Zenscrape ist eine Web-Scraping-API, die den HTML-Code einer beliebigen Website zurückgibt und dafür sorgt, dass Entwickler schnell und effizient Informationen sammeln. Das Tool ermöglicht es Ihnen, Online-Inhalte reibungslos und zuverlässig zu sammeln, indem es Javascript-Rendering oder CHAPTCHAs löst.

Genau wie zuvor werden wir nach Abschluss der Registrierung auf die Dashboard-Seite weitergeleitet.

Kopieren Sie die URL der Produktseite und fügen Sie sie in die URL-Eingabe ein.

Um den Curl-Befehl zu finden, den wir für das Scraping der Amazon-Daten benötigen, scrollen wir bis zur Mitte der Seite herunter. Klicken Sie auf die Schaltfläche "In die Zwischenablage kopieren", öffnen Sie ein neues Terminalfenster und fügen Sie den Befehl ein. Es sollte in etwa so aussehen:

Genau wie bei den anderen Web-Scraping-Tools wird das Ergebnis die Seite sein, die im HTML-Format strukturiert ist.

Bei unseren Recherchen fanden wir heraus, dass Zenscrape eine Erfolgsquote von 98 % mit 98 erfolgreichen Anfragen von 100 und einer Latenzzeit von 1,4 Sekunden hat. Damit liegt es zwar unter den zuvor vorgestellten Tools, aber unserer Meinung nach verfügt es über eine der intuitivsten und schönsten Benutzeroberflächen und erledigt definitiv seine Aufgabe.

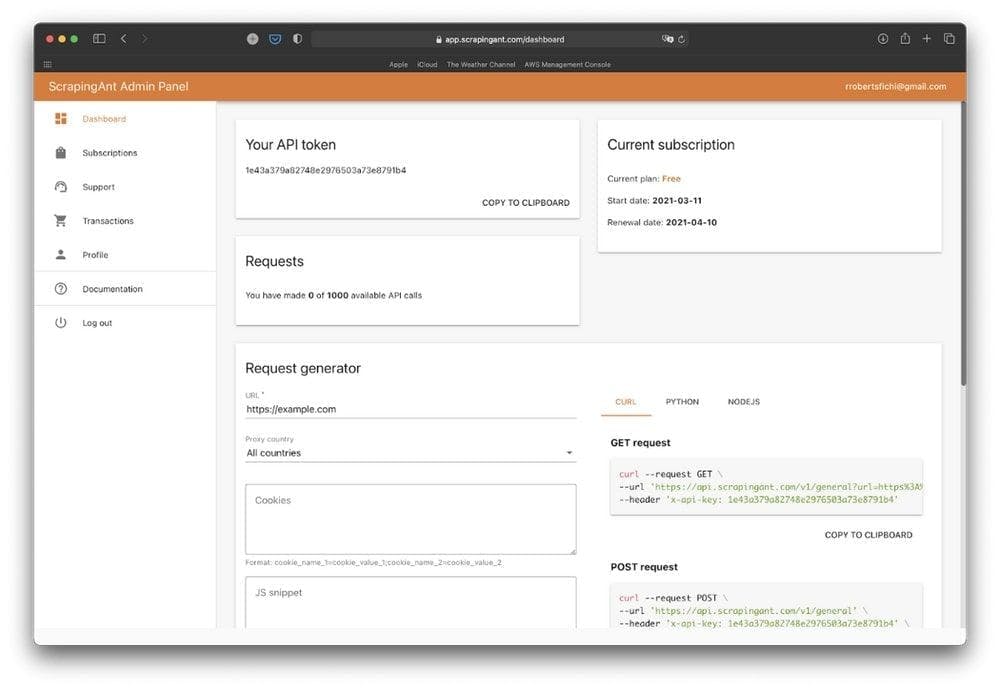

5. ScrapingAnt

ScrapingAnt ist ein Scraping-Tool, das seinen Kunden ein komplettes Web-Harvesting und Scraping-Erlebnis bietet. Es handelt sich um einen Service, der Javascript-Rendering, Headless-Browser-Updates und -Wartung, Proxy-Vielfalt und Rotation übernimmt. Die Scraping-API bietet hohe Verfügbarkeit, Zuverlässigkeit und eine Anpassung der Funktionen an die Bedürfnisse des jeweiligen Unternehmens.

Für unseren letzten Test wiederholen wir den gleichen Prozess. Wir erstellen ein neues Konto bei ScrapingAnt und nutzen die 1000 kostenlosen Anfragen, um die Amazon-Produktseite zu scrapen.

Ich glaube, wir haben uns mit den Web Scraper-Schnittstellen ziemlich vertraut gemacht.

Ersetzen Sie wie zuvor den URL-Eingabewert durch unsere URL, kopieren Sie den Befehl curl in ein neues Terminalfenster und drücken Sie ENTER.

Das Ergebnis ist eine ähnliche HTML-Struktur, die wir dann mit Cheerio oder einem anderen Markup-Parser analysieren können. Die wichtigsten Funktionen von ScrapingAnt sind das Rendern von Chrome-Seiten, die Vorverarbeitung von Ausgaben und Scraping-Anfragen mit einer geringen Wahrscheinlichkeit, dass eine CAPTCHA-Prüfung ausgelöst wird.

Bei unseren Recherchen haben wir herausgefunden, dass ScrapingAnt eine Erfolgsquote von 100 % bei einer Latenzzeit von 3 Sekunden hat. Obwohl die Erfolgsrate eine der höchsten in dieser Liste ist, stellt die Latenzzeit von 3 Sekunden ein großes Problem dar, wenn wir viele Amazon-Produktdaten abfragen.

Schlussfolgerung

Wie wir gesehen haben, ist der Prozess bei allen Web-Scraping-APIs so ziemlich derselbe. Sie finden eine Seite zum Scrapen, schreiben die Curl-Anfrage mit dem Link zum Produkt, stellen die Anfrage und analysieren die erhaltenen Daten nach Ihren persönlichen Bedürfnissen.

Dabei haben wir versucht, herauszufinden, welches das beste Werkzeug für diese Aufgabe ist. Wir haben 5 Scraper getestet und analysiert und festgestellt, dass die Ergebnisse nicht so unterschiedlich sind. Letztendlich erledigen sie alle den Job. Der Unterschied liegt in der Latenzzeit, der Erfolgsrate, der Anzahl der kostenlosen Anfragen und dem Preis der einzelnen Scraper.

WebScrapingAPI ist eine großartige Lösung für das Scraping von Amazon-Daten, da sie eine der geringsten Latenzen (1 Sekunde) und eine Erfolgsquote von nahezu 100 % aufweist. Es gibt eine kostenlose Stufe für diejenigen von uns, die keine große Anzahl von Anfragen machen müssen, und es gibt auch 1000 kostenlose Anfragen, wenn Sie es einfach nur ausprobieren möchten.

ScrapingBee ist der zweite Web Scraper, den wir getestet haben, aber die Ergebnisse waren nicht so zufriedenstellend. Mit einer Erfolgsquote von nur 92,5 % und einer ziemlich großen Latenzzeit (6 Sekunden) wäre es schwierig gewesen, die benötigten Informationen über unser Amazon-Produkt zu erhalten.

ScraperAPI ist auch einer der schnellsten Scraper, die wir getestet haben. Mit einer Latenzzeit von nur 1 Sekunde und einer Erfolgsquote von 100 % hat er die besten Ergebnisse, was die technischen Anforderungen angeht. Sein Nachteil ist die Benutzeroberfläche, die sehr rudimentär zu sein scheint. Das Preismodell ist ein weiterer Schwachpunkt, da es keine kostenlose Stufe gibt.

Zenscrape hat definitiv eine der intuitivsten Benutzeroberflächen von allen Scrapern, die wir getestet haben. Der einzige, der dem nahe kommt, ist WebScrapingAPI. Zenscrape hat eine Latenzzeit von nur 1,4 Sekunden und eine Erfolgsquote von 98 %.

ScrapingAnt ist der letzte Scraper, den wir getestet haben. Mit einer Latenzzeit von ca. 3 Sekunden und einer Erfolgsquote von 100 % ist es eine gute Wahl für das Scrapen der benötigten Amazon-Informationen, aber ein bisschen langsam.

Letztendlich leisten alle von uns getesteten Web Scraper sehr gute Arbeit, wenn es um das Scrapen von Amazon-Produktdaten geht. Obwohl das Ergebnis ziemlich knapp ausfällt, sollten wir immer das effizienteste Tool für unsere spezifischen Anforderungen wählen.

Wir empfehlen Ihnen, sie selbst auszuprobieren. Finden Sie heraus, welches Produkt für Ihre Bedürfnisse am besten geeignet ist. Lesen Sie auch diesen Artikel darüber, wie Sie eine Web-Scraping-API in vollem Umfang nutzen können. Schließlich ist es nicht dasselbe, ein Tool auszuwählen und zu wissen, wie man es einsetzt.

Nachrichten und Aktualisierungen

Bleiben Sie auf dem Laufenden mit den neuesten Web Scraping-Anleitungen und Nachrichten, indem Sie unseren Newsletter abonnieren.

Der Schutz Ihrer Daten liegt uns am Herzen. Lesen Sie unsere Datenschutzrichtlinie.

Ähnliche Artikel

Sind XPath-Selektoren besser als CSS-Selektoren für Web Scraping? Erfahren Sie mehr über die Stärken und Grenzen der einzelnen Methoden und treffen Sie die richtige Wahl für Ihr Projekt!

Erfahren Sie, wie Sie Proxies mit Axios & Node.js für effizientes Web Scraping nutzen können. Tipps, Code-Beispiele und die Vorteile der Verwendung von WebScrapingAPI inklusive.

Um den Unterschied zwischen zwei verschiedenen DAO-Modellen für die Dezentralisierung zu verstehen, betrachten wir die ähnlichen, aber grundlegend unterschiedlichen Neworks ice und Pi.