Web Scraping API Schnellstartanleitung

Mihnea-Octavian Manolache am 14. Juli 2023

WebScrapingAPI bietet eine Reihe von Web-Scraping-Lösungen. Unser Hauptprodukt ist ein Allzweck-Web-Scraper, der für das Sammeln von Echtzeitdaten von beliebigen Websites konzipiert wurde. Wie Sie in diesem Leitfaden erfahren werden, ist das Tool mit verschiedenen Funktionen ausgestattet, die es ermöglichen, von Anti-Bot-Systemen unentdeckt zu bleiben. Dieser Leitfaden soll Ihnen den Einstieg in die Nutzung der Web Scraping API erleichtern, da er eine Vielzahl von Funktionen bietet. Hier sind einige der Details, die wir behandeln werden:

- Arbeiten mit dem Frontend-Dashboard

- Verstehen der Parameter und Funktionen der API

- Senden von einfachen Anfragen an die API

- Einrichten eines komplexen Web Scrapers mit Hilfe der SDKs

Warum sollten Sie sich bei Web Scraping API anmelden?

Es gibt unzählige Gründe, warum Sie Web Scraping API anstelle eines normalen Scrapers verwenden sollten. Wir verlassen uns jedoch auf das Feedback unserer Kunden, wenn wir entscheiden, was uns zur besten Wahl macht. Und hier sind einige der Gründe, warum unsere Kunden uns gewählt haben:

- Professioneller Support - Unser Support wird von echten Software-Ingenieuren geleistet, die praktisch mit der API arbeiten. Wenn Sie sich also an uns wenden, um Hilfe zu erhalten, stellen wir sicher, dass Sie die bestmöglichen Antworten bekommen. Wenn Sie auf ein Problem stoßen, wird der Techniker, der mit Ihnen spricht, höchstwahrscheinlich in der Lage sein, es in kürzester Zeit zu beheben und die Lösung in die Produktion zu übernehmen.

- Benutzerfreundlichkeit - Die Entwicklung eines Web Scrapers kann eine Herausforderung sein. Man muss verschiedene Proxys, Umgehungen, Captchas, Browser usw. berücksichtigen. Mit der Web Scraping API erhalten Sie all das (und noch viel mehr) mit einem "Klick auf eine Schaltfläche".

- Skalierbarkeit - Als wir unser Produkt entwickelt haben, war eine unserer ersten Prioritäten, sicherzustellen, dass wir unabhängig von der Gesamtzahl der Anfragen, die wir erhalten, Ergebnisse liefern. Wenn Sie sich für Web Scraping API anmelden, melden Sie sich für unsere gesamte Infrastruktur an. Und das beinhaltet Proxys, Browser, HTTP-Clients und mehr.

Anmeldung für einen kostenlosen Cloud-basierten Scraper

Um sich bei Web Scraping API anzumelden, ist lediglich eine gültige E-Mail-Adresse erforderlich. Außerdem hat jeder Nutzer Anspruch auf eine 7-tägige kostenlose Testphase mit vollem Zugriff auf die API-Funktionen, die auf 1000 API-Credits begrenzt ist. Nach diesen 7 Tagen erhalten Sie weiterhin Zugang zu einer kostenlosen Stufe, die Ihnen 1000 API-Credits pro Monat bietet, jedoch mit eingeschränkten API-Funktionen. Wenn Sie weiterhin die Vollversion unseres cloudbasierten Web Scrapers nutzen möchten, bieten wir Ihnen flexible Preispläne an. Aktuelle Informationen zu den Preisen finden Sie auf unserer Preisseite. Als Höhepunkt bieten wir an:

- einen Starter-Tarif mit bis zu 100.000 API-Guthaben und 20 gleichzeitigen Aufrufen

- einen Grow-Plan mit bis zu 1.000.000 API-Guthaben und 50 gleichzeitigen Aufrufen

- einen Business-Plan mit bis zu 3.000.000 API-Guthaben und 100 gleichzeitigen Aufrufen

- ein Pro-Abo mit bis zu 10.000.000 API-Guthaben und 500 gleichzeitigen Aufrufen

- einen maßgeschneiderten Unternehmensplan, der auf der Grundlage Ihrer besonderen Bedürfnisse zu erörtern ist

Um loszulegen, besuchen Sie bitte unsere SigUp-Seite hier und erstellen Sie einfach ein kostenloses Konto.

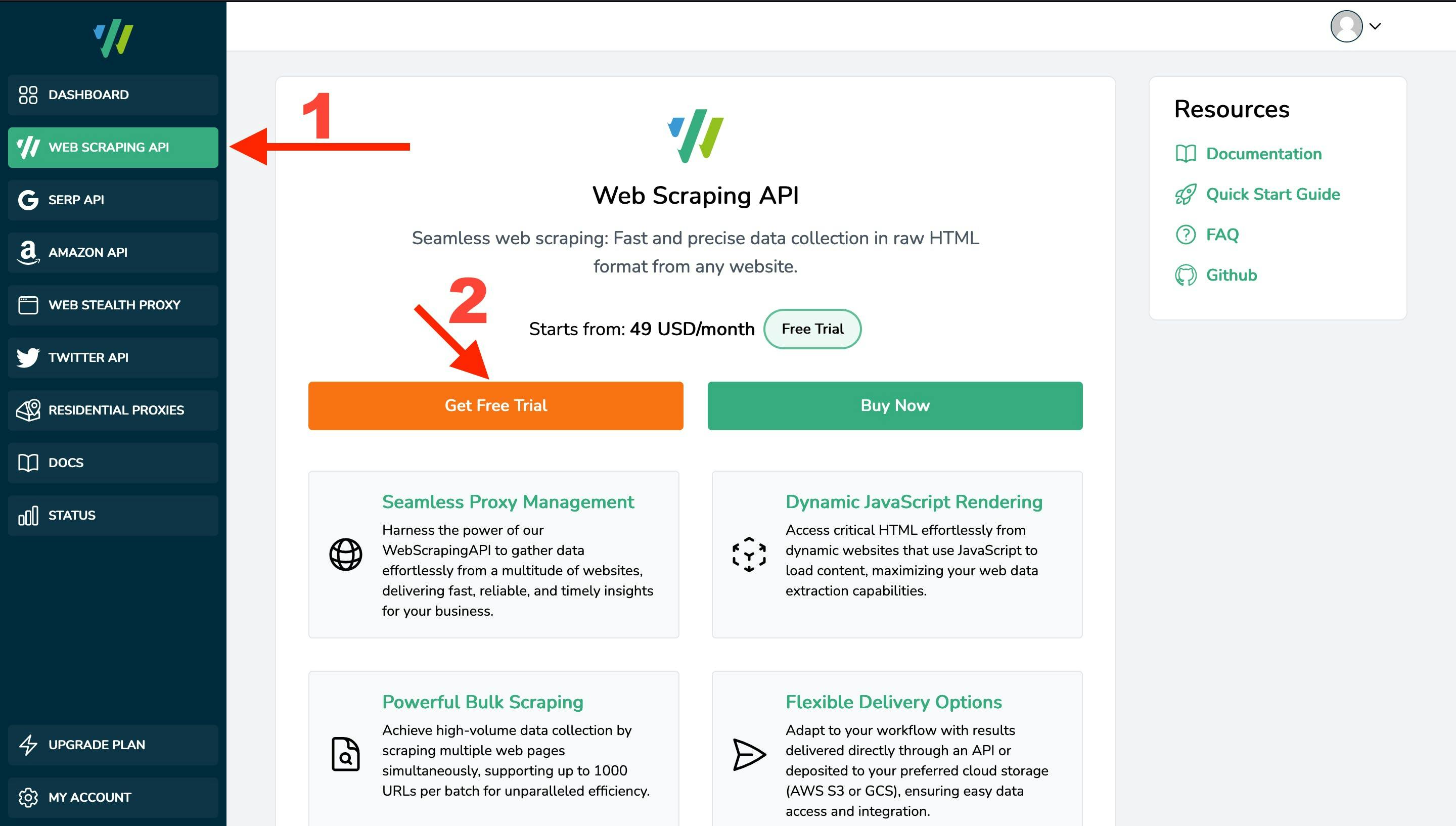

Das Dashboard verstehen

Wenn Sie sich in unserem Dashboard anmelden, erhalten Sie nicht automatisch Zugang zu unseren Produkten. Wie Sie sehen werden, zeigt die linke Seitenleiste einige Optionen an, die mit unseren Produkten verbunden sind. Da sich dieser Leitfaden auf den Allzweck-Web Scraper bezieht, navigieren Sie zu Web Scraping API und klicken Sie auf die Schaltfläche "Get Free Trial", um ein Abonnement für diesen Dienst zu erstellen. Sobald das Abonnement erstellt ist, erhalten Sie einen API-Schlüssel. Bewahren Sie diesen Schlüssel gut auf, da er Ihre eindeutige Kennung in unseren Systemen ist. Sie können dann auch auf die Statistikseite und den Playground zugreifen.

Die Grundlagen unserer Web Scraper API

Es gibt drei Möglichkeiten, mit unserem Web Scraper zu interagieren, von denen zwei, sagen wir mal, "programmatisch" sind und eine eher "einsteigerfreundlich" ist. Die ersten beiden beinhalten den Zugriff auf die API über HTTP-Clients oder über unsere SDKs. Bei der dritten wird der im Dashboard enthaltene Playground verwendet. Dazu kommen wir in Kürze, aber vorher ist es wichtig zu verstehen, wie die API funktioniert. Nur dann können Sie die volle Leistung der Web Scraping API nutzen. Lassen Sie uns also mit den Grundlagen beginnen:

Authentifizierungsanfragen

Wir authentifizieren Anfragen von registrierten Nutzern, indem wir den URL-Parameter `api_key` aktivieren. Der eindeutige API-Schlüssel ist mit Ihrem Konto verknüpft und enthält Informationen über Berechtigungen, Nutzung usw.

Bitte beachten Sie, dass jedem Produkt, für das Sie sich anmelden, ein eindeutiger API-Schlüssel zugeordnet ist. Sie können zum Beispiel den API-Schlüssel Ihres Allzweck-Web-Scrapers nicht für die SERP-API verwenden und umgekehrt.

Um eine URL als authentifizierter Benutzer zu scrapen, müssen Sie auf die folgende Ressource zugreifen:

https://api.webscrapingapi.com/v1?api_key=<YOUR_UNIQUE_API_KEY>

API-Parameter

Innerhalb unserer API werden Abfrageparameter verwendet, um den Scraper an Ihre Bedürfnisse anzupassen. Wenn Sie verstehen, wie die einzelnen Parameter funktionieren, können Sie die volle Leistung unserer Web Scraper API nutzen. Wir halten die Dokumentation der API-Parameter hier auf dem neuesten Stand. Wir werden jedoch auch hier in sie eintauchen, um besser zu verstehen, wie Abfrageparameter mit Web Scraping API funktionieren. Es gibt drei Arten von Parametern: erforderliche, Standard- und optionale Parameter. Die erforderlichen Parameter sind recht einfach:

- Der Parameter `api_key`, den wir oben besprochen haben

- Der Parameter "URL" steht für die URL, die Sie abrufen möchten.

Bitte beachten Sie, dass der Wert des Parameters "URL" eine gültige URL sein sollte, kein Domänenname, und dass er idealerweise URL-codiert sein sollte. (d.h. https%3A%2F%2Fwebscrapingapi.com)

Bei den Standardparametern haben wir historische Daten verwendet, um die Erfolgsquote unserer API (und damit auch die Ihres Projekts) zu erhöhen. Interne Daten zeigen, dass die beste Konfiguration für Web Scraping die Verwendung eines aktuellen Webbrowsers in Verbindung mit einer privaten IP-Adresse ist. Daher sind die Standardparameter unserer API wie folgt:

- `render_js=1`- um einen echten Browser zu starten (nicht einen einfachen HTTP-Client)

- proxy_type=residential" - für den Zugriff auf das Ziel über eine private IP-Adresse (nur aktiviert, wenn Ihr aktueller Tarif private Proxys unterstützt)

Natürlich können Sie den Wert für diese Parameter auch überschreiben, aber wir raten Ihnen davon ab. Scraping mit einem einfachen HTTP-Client und Rechenzentrums-Proxys führt in der Regel dazu, dass die Ziel-Website die Scraping-Aktivitäten bemerkt und den Zugriff blockiert.

Im Folgenden werden wir uns mit den optionalen Parametern befassen. Da wir alle Parameter in unserer Dokumentation dokumentiert haben, werden wir vorerst nur die am häufigsten verwendeten Parameter besprechen:

- Parameter: render_js

Beschreibung: Wenn Sie diesen Parameter aktivieren, können Sie die Ziel-URL über einen aktuellen Browser aufrufen. Dies hat den Vorteil, dass JavaScript-Dateien gerendert werden. Es ist eine gute Wahl für das Scraping von JavaScript-lastigen Websites (wie z. B. solche, die mit ReactJS erstellt wurden).

Dokumentation:[hier] - Parameter: proxy_type

Beschreibung: Ermöglicht den Zugriff auf die Ziel-URL über eine private oder eine Rechenzentrums-IP-Adresse.

Dokumentation:[hier] - Parameter: stealth_mode

Beschreibung: Web Scraping ist keine illegale Aktivität. Einige Websites neigen jedoch dazu, den Zugriff auf automatisierte Software (einschließlich Web Scraper) zu blockieren. Unser Team hat eine Reihe von Tools entwickelt, die es Anti-Bot-Systemen fast unmöglich machen, unseren Web Scraper zu entdecken. Sie können diese Funktionen aktivieren, indem Sie den Parameter stealth_mode=1 verwenden.

Dokumentation:[hier] - Parameter: country

Beschreibung: Ermöglicht den Zugriff auf Ihr Ziel von einem bestimmten Standort aus. Überprüfen Sie die unterstützten Länder [hier].

Dokumentation:[hier] - Parameter: timeout

Beschreibung: Standardmäßig wird eine Anfrage nach 10 Sekunden abgebrochen (und nicht berechnet, wenn sie fehlgeschlagen ist). Bei bestimmten Zielen kann es sinnvoll sein, diesen Wert auf bis zu 60s zu erhöhen.

Dokumentation:[hier] - Parameter: device

Beschreibung: Sie können dies verwenden, um Ihren Scraper wie einen 'Desktop', 'Tablet' oder 'Mobile' aussehen zu lassen.

Dokumentation:[hier] - Parameter: wait_until

Beschreibung: Einfach ausgedrückt: Sobald die Ziel-URL erreicht ist, wird der Scraper angehalten, bis ein bestimmtes Ereignis eintritt. Das Konzept, das wir verfolgen, wird am besten [hier] beschrieben.

Dokumentation:[hier] - Parameter: wait_for

Beschreibung: Dieser Parameter friert den Scraper für eine bestimmte Zeitspanne ein (die 60s nicht überschreiten darf).

Dokumentation:[hier] - Parameter: wait_for_css

Beschreibung: Friert den Scraper ein, bis ein bestimmter CSS-Selektor (d.h. eine Klasse oder ID) auf der Seite sichtbar ist.

Dokumentation:[hier] - Parameter: session

Beschreibung: Ermöglicht die Verwendung desselben Proxys (IP-Adresse) für mehrere Anfragen.

Dokumentation:[hier]

Antwort-Codes

Einer der wichtigsten Aspekte, den Sie über Antwortcodes wissen müssen, ist, dass wir nur für erfolgreiche Antworten Gebühren erheben. Wenn Ihre Anfrage also etwas anderes als den Statuscode 200 ergibt, werden Ihnen keine Kosten in Rechnung gestellt. Abgesehen davon sind die API-Fehler hier dokumentiert, und wie Sie sehen werden, folgen sie den regulären HTTP-Statuscodes. Um nur einige zu nennen:

- 400: Bad Request - Wenn Sie ungültige Parameter senden, zum Beispiel

- 401: Unerlaubt - Wenn Sie keinen `api_key` senden können oder der API-Schlüssel ungültig ist

- 422: Unverarbeitbare Entität - Wenn die API die Anforderung nicht erfüllen kann (z. B. wenn der erwartete CSS-Selektor auf der Seite nicht sichtbar ist)

Interaktion mit der Web Scraper API

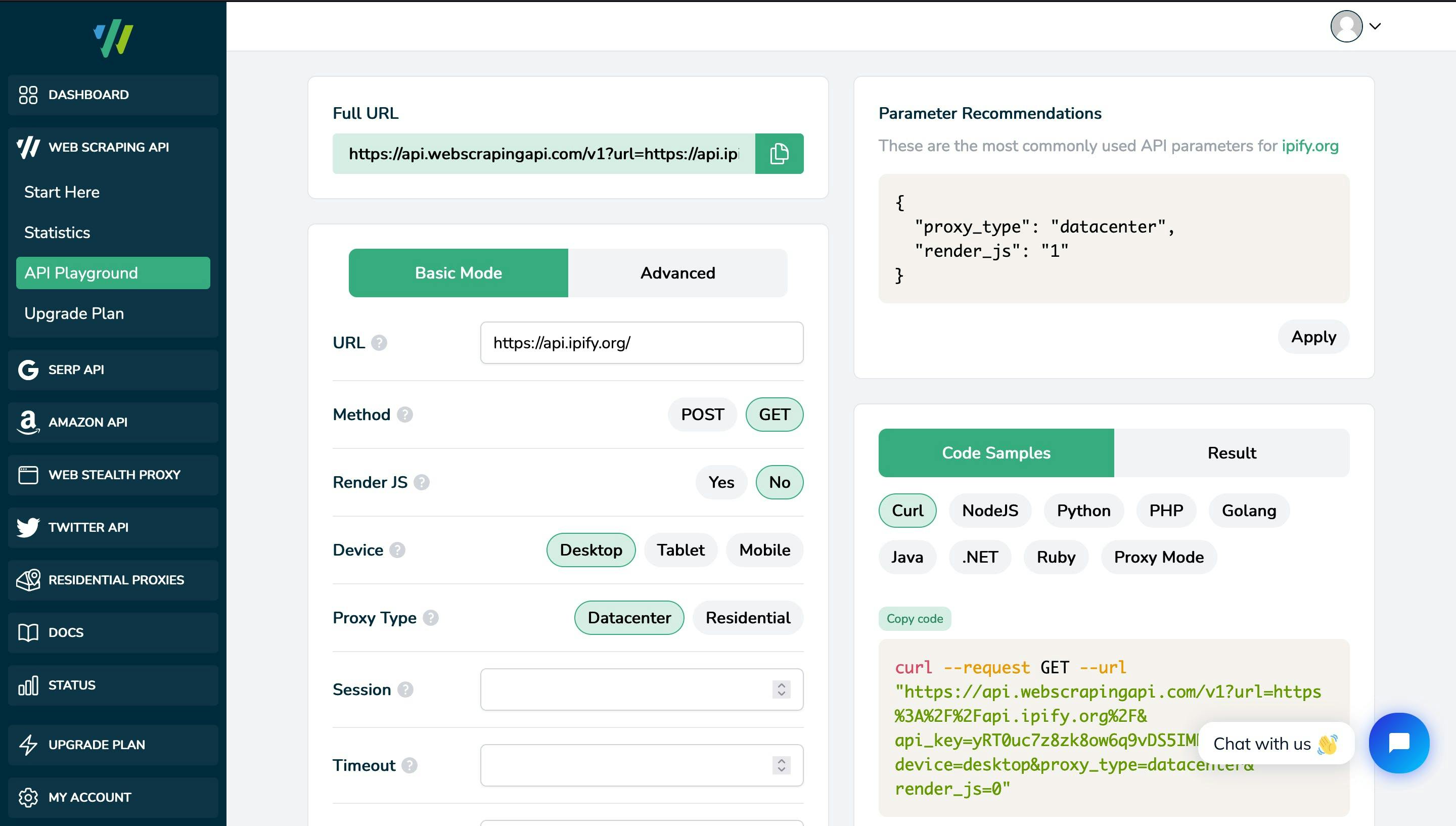

Wie gesagt, gibt es hauptsächlich drei Möglichkeiten, mit der Web Scraper API zu interagieren. Zunächst einmal ist die Verwendung der SDKs oder der Zugriff auf die API über HTTP-Clients eher sprach- (oder technologie-)abhängig und erfordert ein gewisses technisches Hintergrundwissen. Eine einsteigerfreundlichere Schnittstelle ist in unserem Dashboard unter dem API Playground verfügbar. Dieses Tool ermöglicht es Ihnen, mit unserem Web Scraper zu spielen, ihn zu testen und ein Gefühl dafür zu bekommen, wie Sie die Parameter zu Ihrem Vorteil nutzen können, bevor Sie sich mit programmatischen Implementierungen oder fortgeschrittenen Funktionen beschäftigen. Einige wichtige Aspekte des Playgrounds sind:

- Es behebt automatisch Parameter-Inkompatibilitäten (z.B. `stealth_mode=1` ist nicht kompatibel mit `render_js=0`)

- Es enthält aktuelle Codebeispiele für verschiedene Programmiersprachen, die Sie für Ihr Projekt verwenden können

- Sie zeigt empfohlene Parameter an, die auf unseren internen Tests und historischen Daten früherer Anfragen basieren, damit Sie die Erfolgsquote Ihres Projekts erhöhen können.

Erweiterte Web-Scraping-Funktionen

Für fortgeschrittene Benutzer ist unsere API mit verschiedenen Funktionen ausgestattet, die sie anpassbar und bereit für jedes Scraping-Projekt machen. Eine gute Informationsquelle ist auch hier unsere offizielle Dokumentation. Hier sind jedoch einige der Aspekte, die wir hervorheben sollten:

POST, PUT und PATCH

Mit der Web Scraping API sind Sie nicht auf die Verwendung von GET-Anfragen beschränkt. Sollte Ihr Scraping-Projekt Ressourcen erstellen, ersetzen oder aktualisieren müssen, können Sie unsere POST-, PUT- oder PATCH-Anfragen verwenden. Ein wichtiger Aspekt dieser Anfragen ist, dass Sie auch `render_js=1` verwenden können, d.h. einen echten Webbrowser und keinen einfachen HTTP-Client. Ein Beispiel für eine POST-Anfrage ist:

curl --request POST --url "https://api.webscrapingapi.com/v1?api_key=<YOUR_API_KEY>&url=https%3A%2F%2Fhttpbin.org%2Fpost" --data "{

"foo": "bar"

}"Proxy-Modus

Sie können unsere API auch als Proxy verwenden, um Ihre Ziel-URL zu scrapen. Um auf die API als Proxy zuzugreifen, müssen Sie Folgendes beachten:

- Der Benutzername für die Authentifizierung beim Proxy wird immer auf `webscrapingapi` gesetzt, gefolgt von den Parametern, die Sie aktivieren möchten, getrennt durch Punkte.

- Das Passwort ist immer Ihr persönlicher API-Schlüssel

Hier ist ein Beispiel für eine URL, die Sie für den Zugriff auf den Web Scraper über unseren Proxy-Modus verwenden können :

https://webscrapingapi.<parameter_1.parameter_2.parameter_n>:<YOUR_API_KEY>@proxy.webscrapingapi.com:8000

Schlussfolgerungen

Web Scraping API bietet eine Reihe von leistungsstarken Scraping-Tools, die von einem Team von Ingenieuren unterstützt werden und sofort einsatzbereit sind. Sie ist mit Dutzenden von Funktionen ausgestattet, die sie zu einer anpassbaren Web Scraping-Lösung machen. Darüber hinaus können Sie den universellen Cloud Web Scraper mit jeder Programmiersprache oder Technologie integrieren, da er entweder rohes HTML oder geparste JSONs zurückgibt. Unsere umfangreiche Dokumentation und die öffentlichen GitHub-Repositories sollten Ihnen helfen, Ihr Projekt in kürzester Zeit zu starten.

Wir hoffen, dass dieser Leitfaden ein guter Ausgangspunkt für Sie ist. Bitte beachten Sie, dass unser Support immer für Sie da ist, wenn Sie Fragen haben. Wir freuen uns darauf, Ihr Partner für den Erfolg zu sein!

Nachrichten und Aktualisierungen

Bleiben Sie auf dem Laufenden mit den neuesten Web Scraping-Anleitungen und Nachrichten, indem Sie unseren Newsletter abonnieren.

Der Schutz Ihrer Daten liegt uns am Herzen. Lesen Sie unsere Datenschutzrichtlinie.

Ähnliche Artikel

Scrapen Sie Amazon effizient mit der kosteneffizienten Lösung von Web Scraping API. Greifen Sie auf Echtzeitdaten zu, von Produkten bis zu Verkäuferprofilen. Jetzt anmelden!

Sammeln Sie mühelos Echtzeitdaten von Suchmaschinen mit der SERP Scraping API. Verbessern Sie Marktanalysen, SEO und Themenforschung mit Leichtigkeit. Legen Sie noch heute los!

Erforschen Sie die transformative Kraft des Web Scraping im Finanzsektor. Von Produktdaten bis zur Stimmungsanalyse bietet dieser Leitfaden Einblicke in die verschiedenen Arten von Webdaten, die für Investitionsentscheidungen zur Verfügung stehen.